ServiceMesh - Istio - Week3

5. 트래픽 제어: 세밀한 트래픽 라우팅

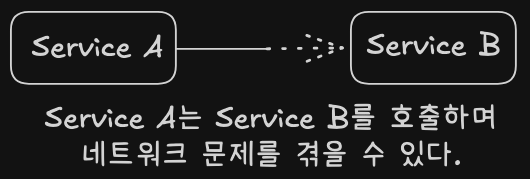

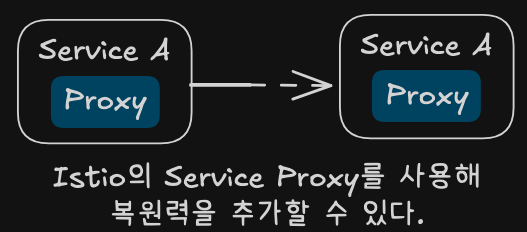

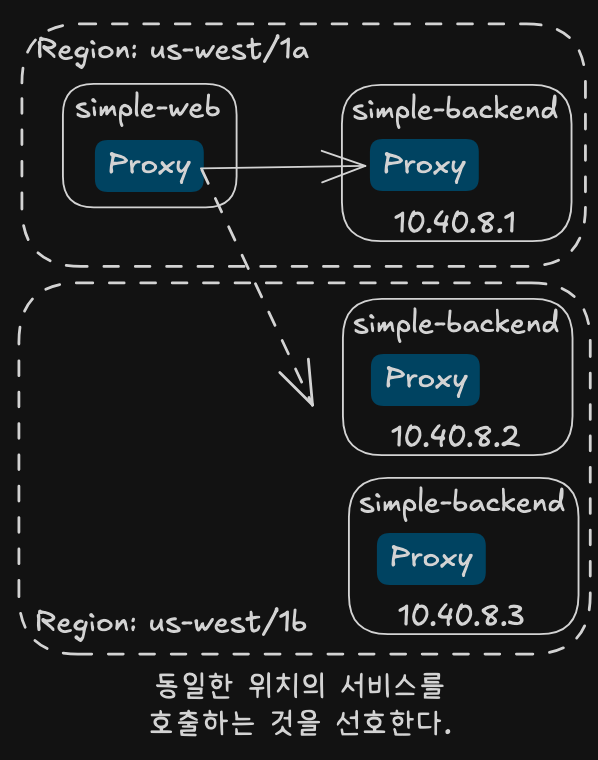

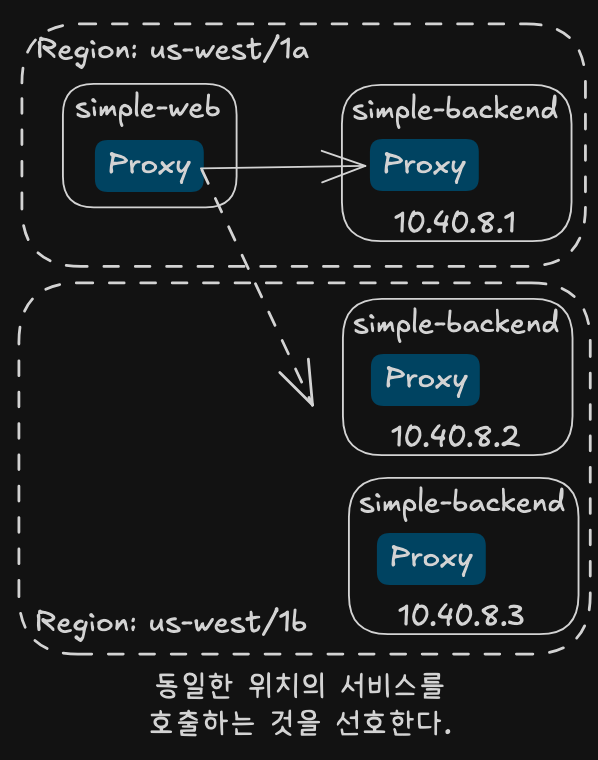

Istio를 사용해 서비스 간 트래픽을 정밀하게 제어하는 방법을 다룬다. 새 소프트웨어 릴리스의 위험을 줄이고, 복잡한 배포 패턴을 지원할 수 있다.

새로운 코드 배포의 위험 줄이기

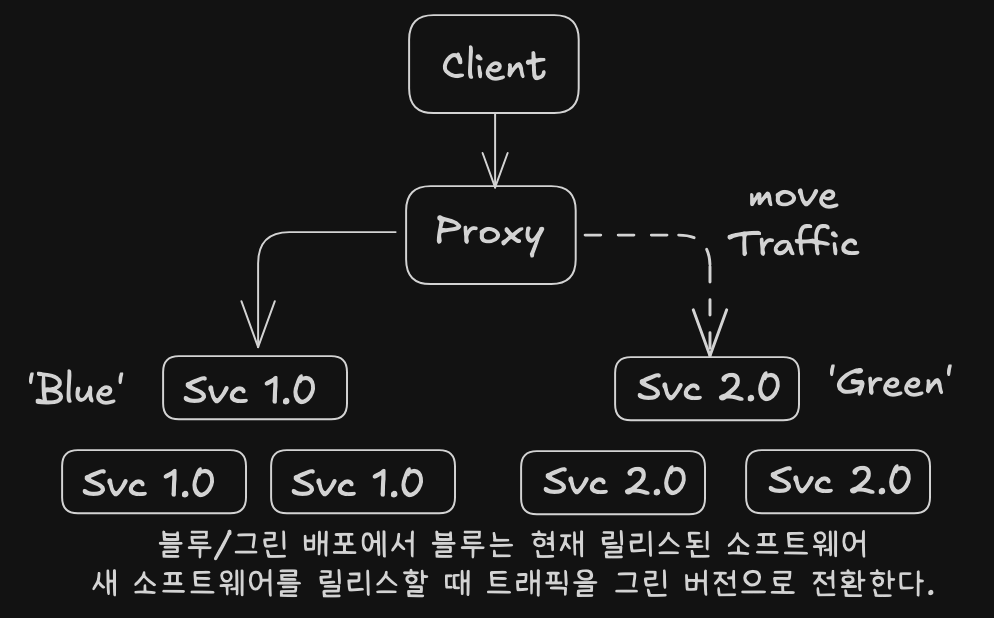

ACME사는 블루/그린 배포를 사용해 서비스 v2(그린)를 기존 v1(블루) 옆에 배포했다.

트래픽을 v2로 전환하거나, 문제 발생 시 v1으로 빠르게 되돌릴 수 있었다.

트래픽을 v2로 전환하거나, 문제 발생 시 v1으로 빠르게 되돌릴 수 있었다.

하지만 블루/그린 배포만으로는 여전히 ‘빅뱅 릴리스’의 위험이 있었다. 이를 해결하기 위해 배포와 릴리스를 분리하는 전략이 필요하다.

배포 vs 릴리스

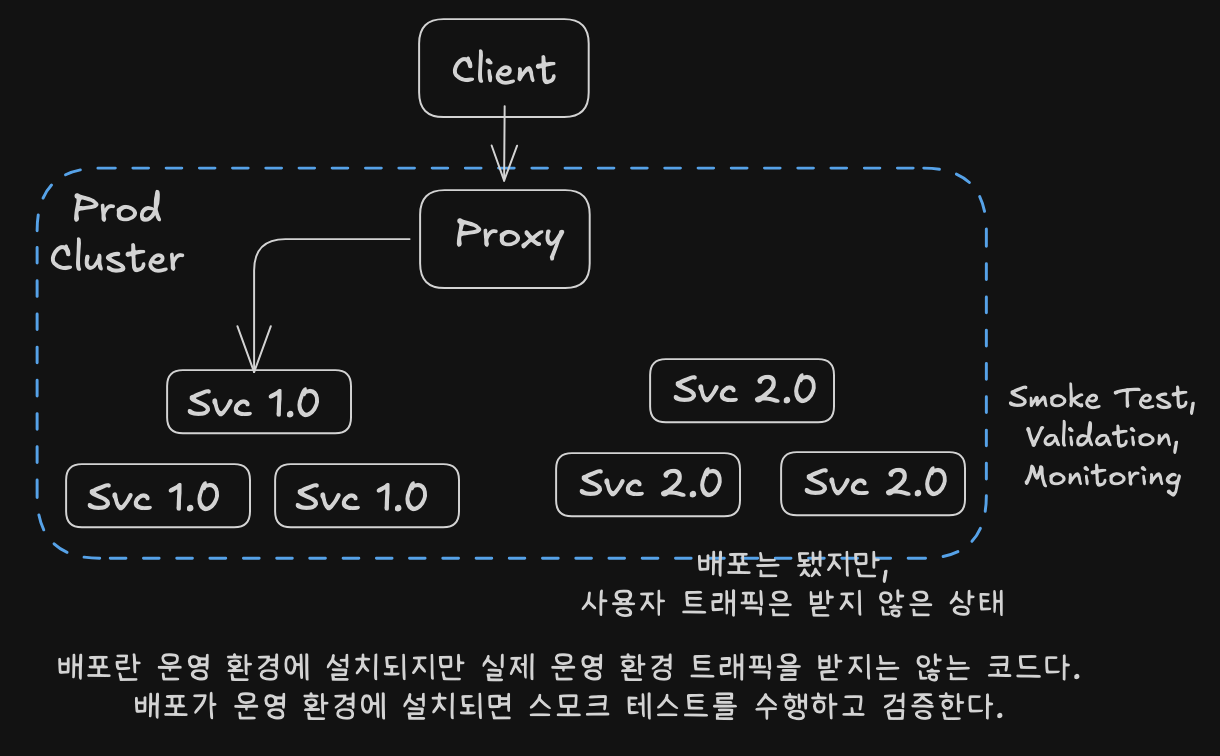

catalog 서비스 v1이 운영 중일 때, 새로운 코드 변경(v1.1)을 추가하려면:

- 빌드하고 태깅한 후 스테이징 환경에 배포

- 검증과 승인을 거친 뒤 운영 환경에 배포

운영 환경에 새 버전을 설치해도, 트래픽을 연결하지 않으면 사용자에겐 아무 영향이 없다. 운영 환경에서 새 버전의 메트릭과 로그를 수집해 안정성을 검증할 수 있다.

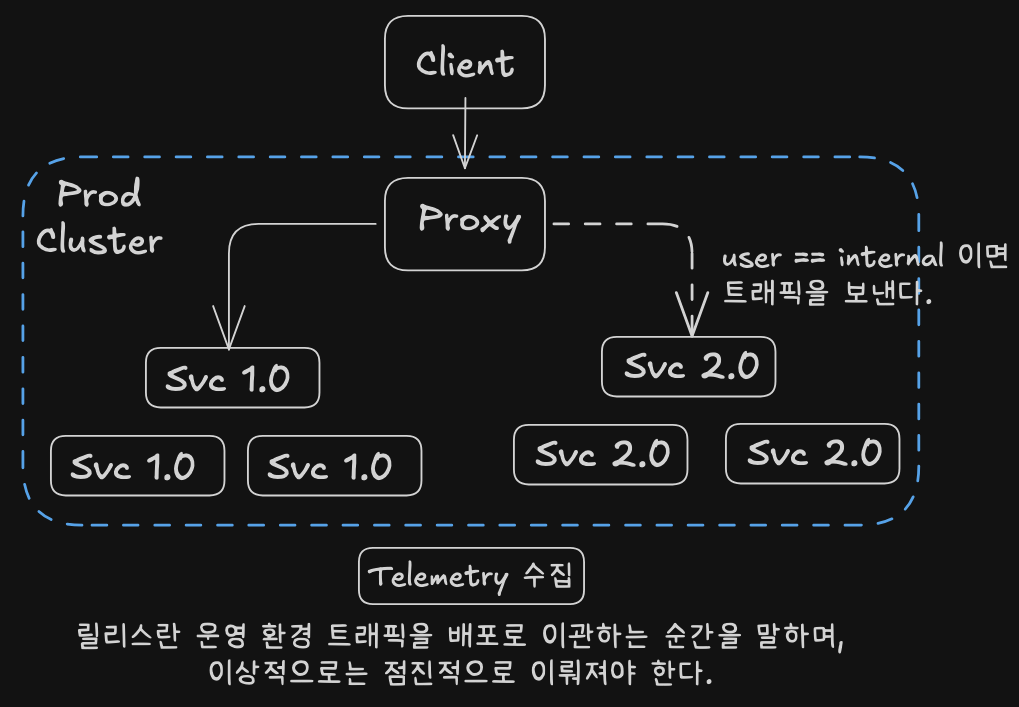

검증이 완료되면 실제 트래픽을 일부 옮겨 릴리스를 시작한다.

처음에는 내부 직원만 신버전을 사용하게 할 수 있다. 이렇게 하면 내부 피드백을 통해 안정성을 검증할 수 있다.

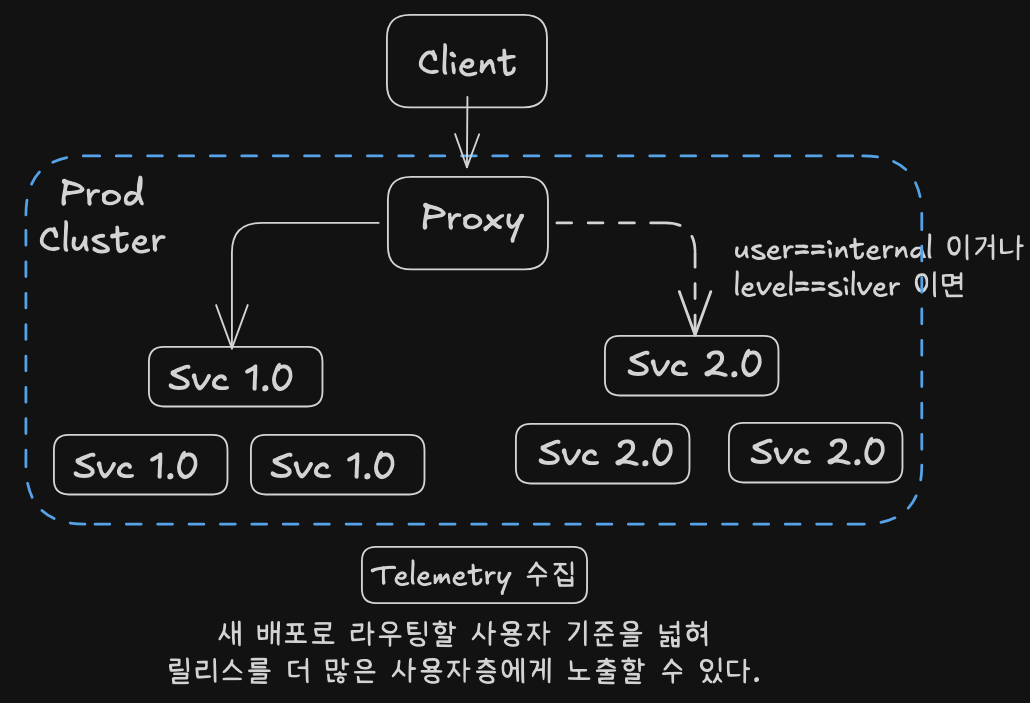

검증 후 무과금 고객이나 실버 등급 고객 등으로 릴리스를 확장해 전체 배포를 완료한다.

실습 준비

- kind로 cluster 셋팅

- istio 설치 및 추가 설정

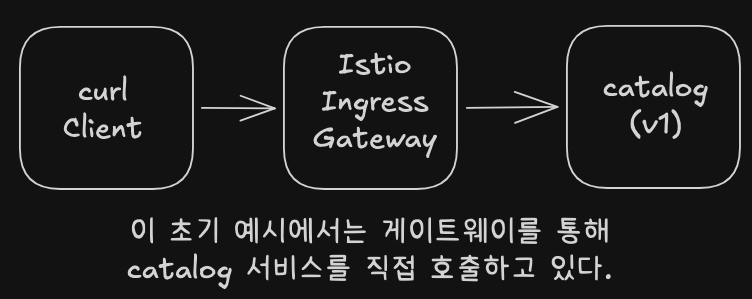

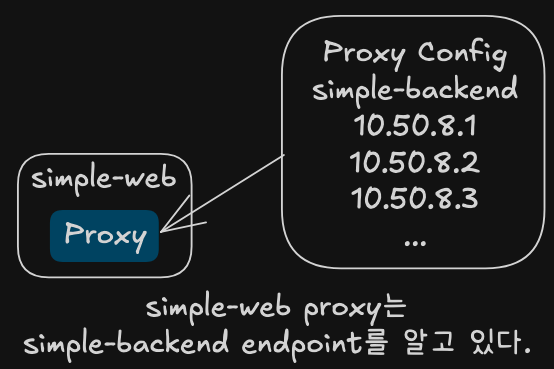

catalog 서비스 트래픽을 제어하기 위해 Istio VirtualService를 사용한다. 특정 요청만 신버전으로 보내는 다크 런치(dark launch) 기법을 구현할 수 있다.

작업 공간 청소

k config set-context $(kubectl config current-context) --namespace=istioinaction

k delete deployment,svc,gateway,virtualservice,destinationrule --all -n istioinaction

catalog 서비스 v1 배포

# Let’s deploy v1 of our catalog service. From the root of the book’s source code, run the following command

kubectl apply -f services/catalog/kubernetes/catalog.yaml -n istioinaction

# 확인

kubectl get pod -n istioinaction -owide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

catalog-6cf4b97d-x45bl 2/2 Running 0 16s 10.10.0.21 myk8s-control-plane <none> <none>

# 도메인 질의를 위한 임시 설정 : 실습 완료 후에는 삭제 해둘 것

echo "127.0.0.1 catalog.istioinaction.io" | sudo tee -a /etc/hosts

cat /etc/hosts | tail -n 3

# netshoot로 내부에서 catalog 접속 확인

kubectl exec -it netshoot -- curl -s http://catalog.istioinaction/items | jq

# 외부 노출을 위해 Gateway 설정

cat ch5/catalog-gateway.yaml

apiVersion: networking.istio.io/v1alpha3

kind: Gateway

metadata:

name: catalog-gateway

spec:

selector:

istio: ingressgateway

servers:

- port:

number: 80

name: http

protocol: HTTP

hosts:

- "catalog.istioinaction.io"

kubectl apply -f ch5/catalog-gateway.yaml -n istioinaction

# 트래픽을 catalog 서비스로 라우팅하는 VirtualService 리소스 설정

cat ch5/catalog-vs.yaml

apiVersion: networking.istio.io/v1alpha3

kind: VirtualService

metadata:

name: catalog-vs-from-gw

spec:

hosts:

- "catalog.istioinaction.io"

gateways:

- catalog-gateway

http:

- route:

- destination:

host: catalog

kubectl apply -f ch5/catalog-vs.yaml -n istioinaction

# 확인

kubectl get gw,vs -n istioinaction

NAME AGE

gateway.networking.istio.io/catalog-gateway 21s

NAME GATEWAYS HOSTS AGE

virtualservice.networking.istio.io/catalog-vs-from-gw ["catalog-gateway"] ["catalog.istioinaction.io"] 11s

# istio-ingressgateway Service(NodePort)에 포트 정보 확인

kubectl get svc -n istio-system istio-ingressgateway -o jsonpath="{.spec.ports}" | jq

[

{

"name": "status-port",

"nodePort": 31674,

"port": 15021,

"protocol": "TCP",

"targetPort": 15021

},

{

"name": "http2",

"nodePort": 30000, # 순서1

"port": 80,

"protocol": "TCP",

"targetPort": 8080 # 순서2

},

{

"name": "https",

"nodePort": 30005,

"port": 443,

"protocol": "TCP",

"targetPort": 8443

}

]

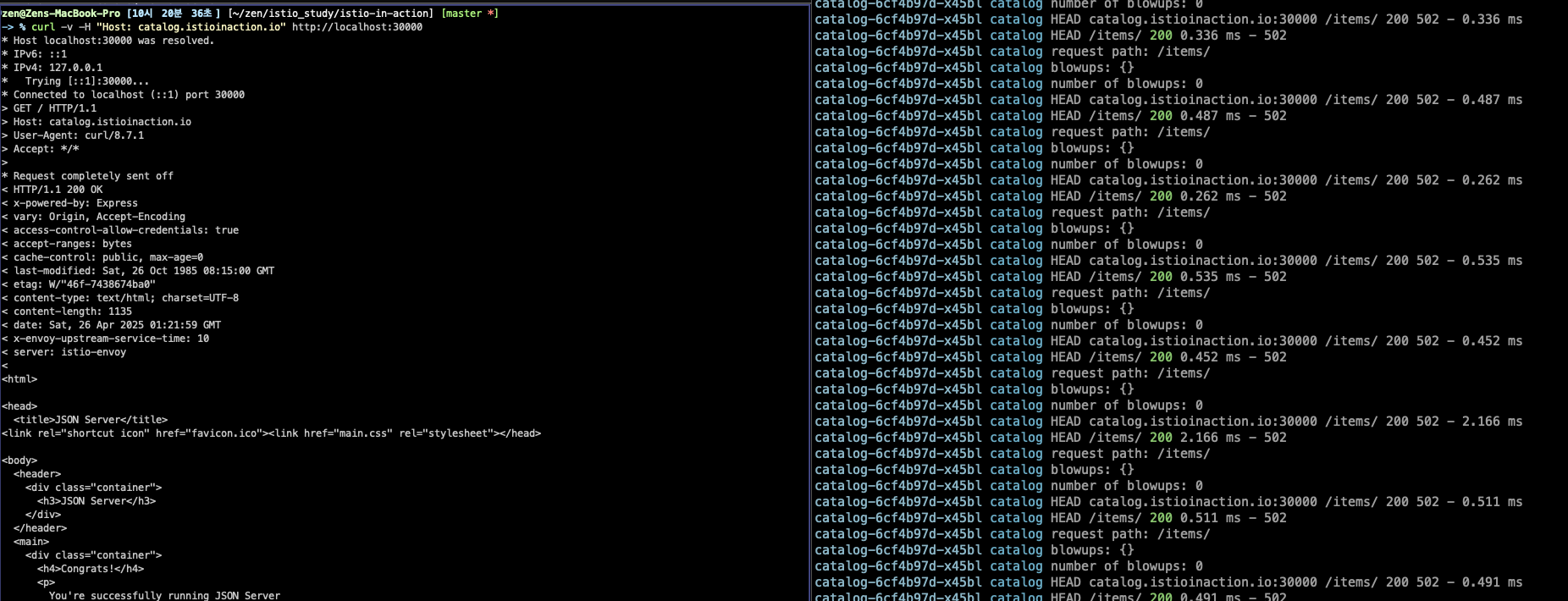

# 호스트에서 NodePort(Service)로 접속 확인

curl -v -H "Host: catalog.istioinaction.io" http://localhost:30000

kubectl stern -l app=catalog -n istioinaction

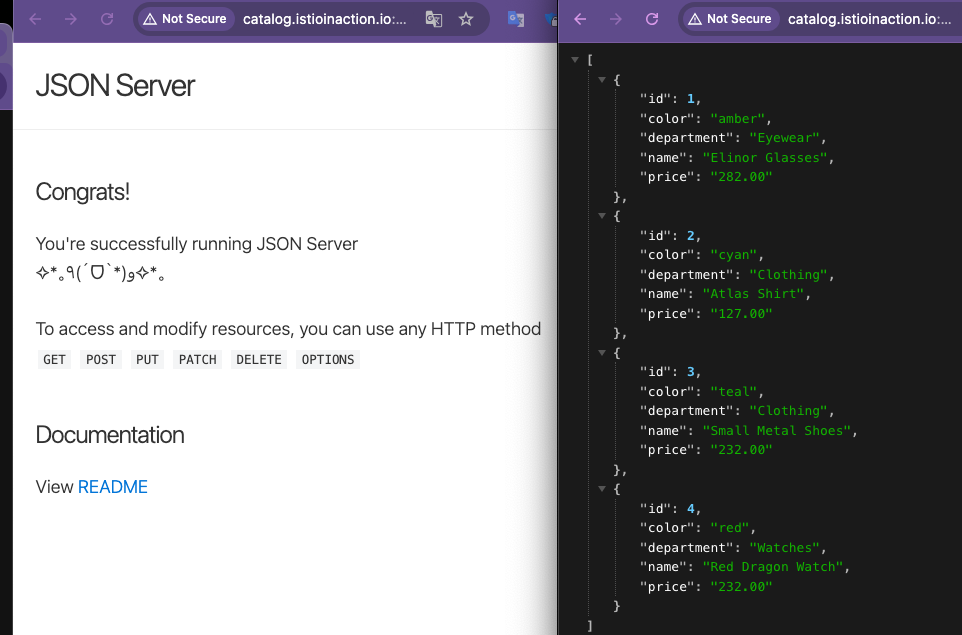

open http://localhost:30000

open http://catalog.istioinaction.io:30000

open http://catalog.istioinaction.io:30000/items

# 신규 터미널 : 반복 접속 실행 해두기

while true; do curl -s http://catalog.istioinaction.io:30000/items/ ; sleep 1; echo; done

while true; do curl -s http://catalog.istioinaction.io:30000/items/ -I | head -n 1 ; date "+%Y-%m-%d %H:%M:%S" ; sleep 1; echo; done

while true; do curl -s http://catalog.istioinaction.io:30000/items/ -I | head -n 1 ; date "+%Y-%m-%d %H:%M:%S" ; sleep 0.5; echo; done

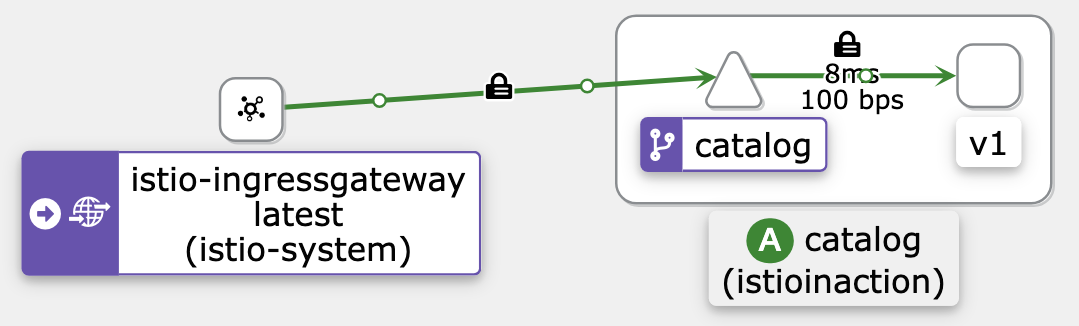

docker exec -it myk8s-control-plane istioctl proxy-status

NAME CLUSTER CDS LDS EDS RDS ECDS ISTIOD VERSION

catalog-6cf4b97d-x45bl.istioinaction Kubernetes SYNCED SYNCED SYNCED SYNCED NOT SENT istiod-7df6ffc78d-wplhm 1.17.8

istio-ingressgateway-996bc6bb6-chtgt.istio-system Kubernetes SYNCED SYNCED SYNCED SYNCED NOT SENT istiod-7df6ffc78d-wplhm 1.17.8

netshoot.istioinaction Kubernetes SYNCED SYNCED SYNCED SYNCED NOT SENT istiod-7df6ffc78d-wplhm 1.17.8

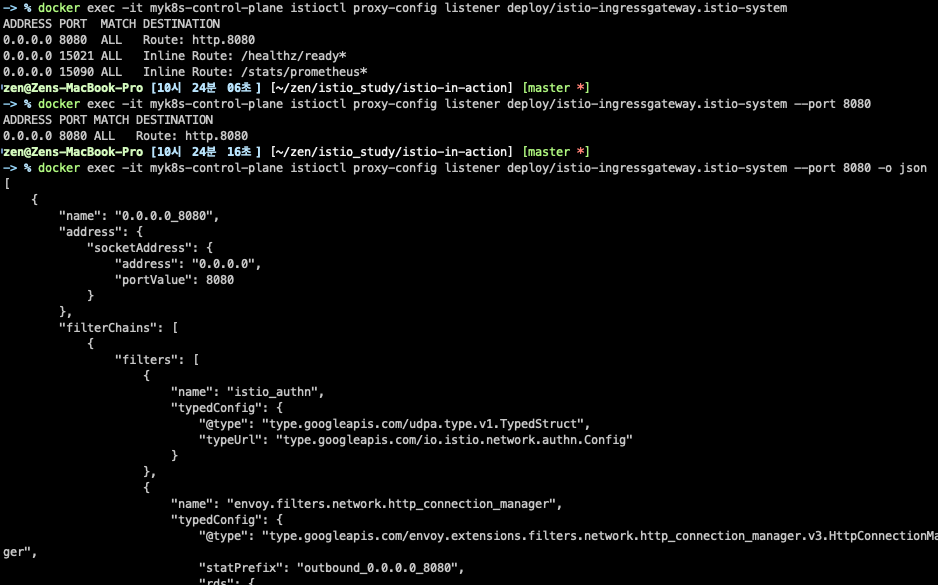

# istio-ingressgateway

## LDS - Listener Discovery Service

docker exec -it myk8s-control-plane istioctl proxy-config listener deploy/istio-ingressgateway.istio-system

docker exec -it myk8s-control-plane istioctl proxy-config listener deploy/istio-ingressgateway.istio-system --port 8080

docker exec -it myk8s-control-plane istioctl proxy-config listener deploy/istio-ingressgateway.istio-system --port 8080 -o json

## RDS - Route Discovery Service

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/istio-ingressgateway.istio-system

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/istio-ingressgateway.istio-system --name http.8080

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/istio-ingressgateway.istio-system --name http.8080 -o json

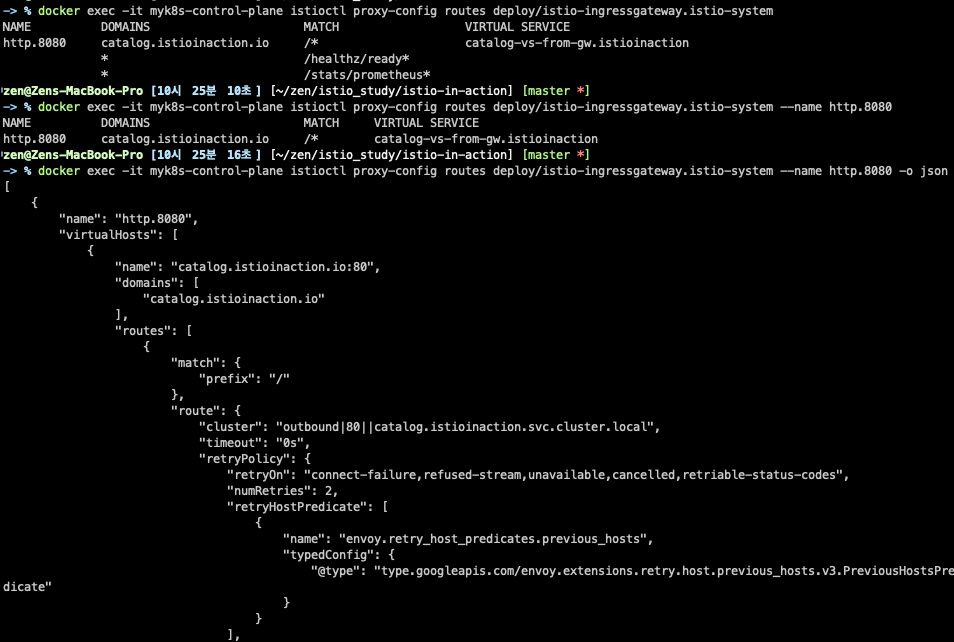

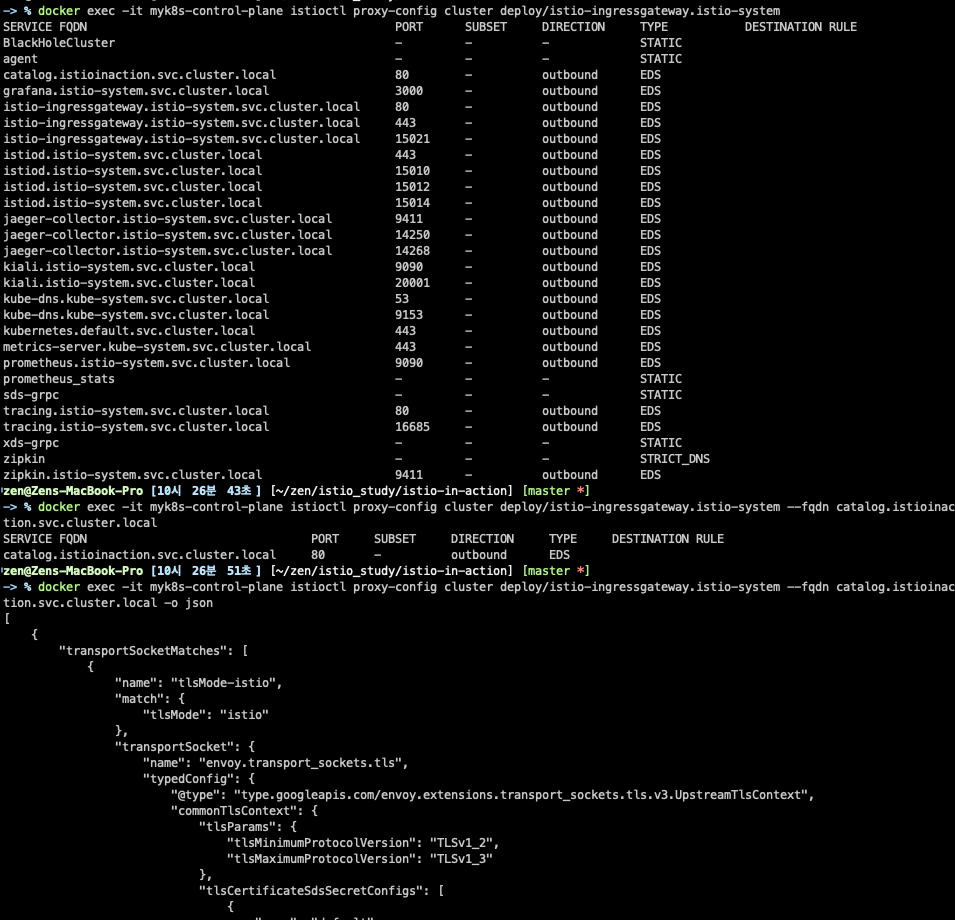

## CDS - Cluseter Discovery Service

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/istio-ingressgateway.istio-system

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/istio-ingressgateway.istio-system --fqdn catalog.istioinaction.svc.cluster.local

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/istio-ingressgateway.istio-system --fqdn catalog.istioinaction.svc.cluster.local -o json

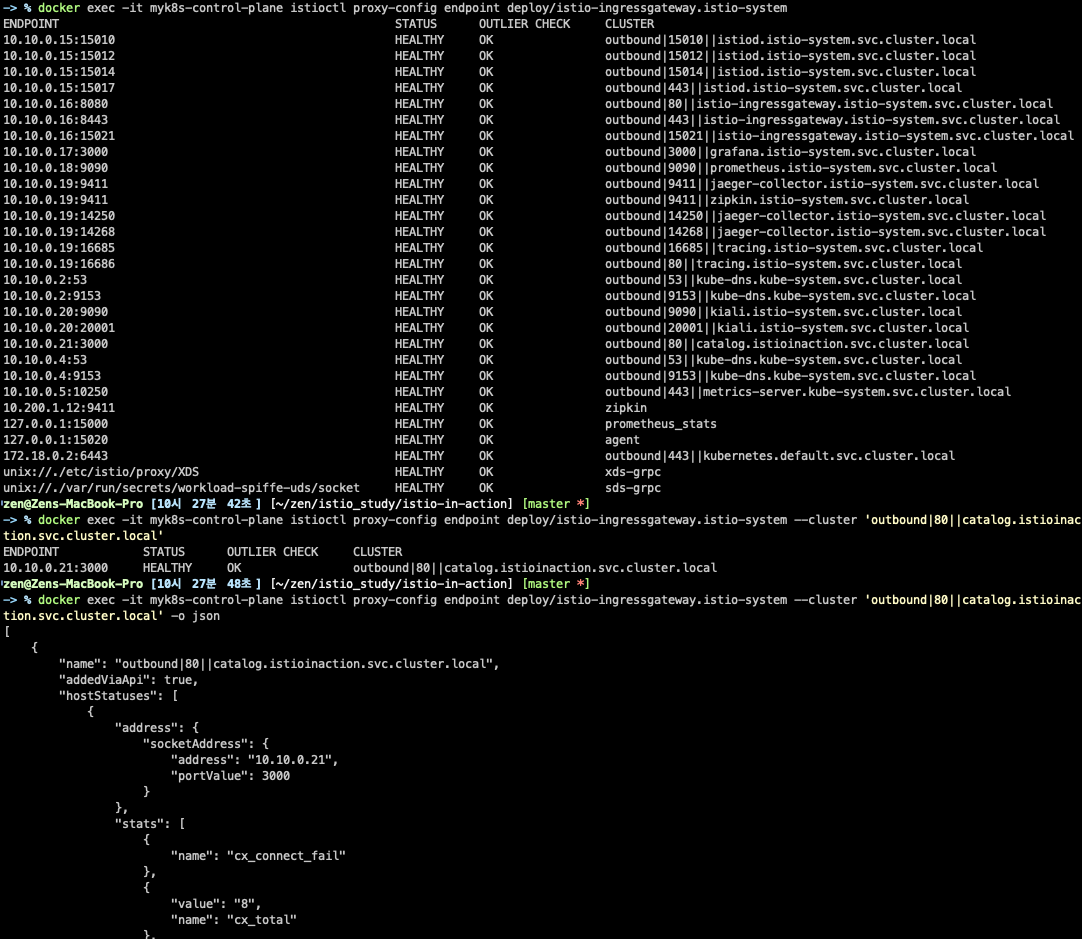

## EDS - Endpoint Discovery Service

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/istio-ingressgateway.istio-system

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/istio-ingressgateway.istio-system --cluster 'outbound|80||catalog.istioinaction.svc.cluster.local'

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/istio-ingressgateway.istio-system --cluster 'outbound|80||catalog.istioinaction.svc.cluster.local' -o json

# catalog

docker exec -it myk8s-control-plane istioctl proxy-config listener deploy/catalog.istioinaction

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/catalog.istioinaction

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/catalog.istioinaction

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/catalog.istioinaction

LDS(Listener)

LDS(Listener)

RDS(Routes)

RDS(Routes)

CDS(Cluster)

CDS(Cluster)

EDS(Endpoint)

EDS(Endpoint)

# catalog's xDS

$ docker exec -it myk8s-control-plane istioctl proxy-config listener deploy/catalog.istioinaction

ADDRESS PORT MATCH DESTINATION

10.200.1.10 53 ALL Cluster: outbound|53||kube-dns.kube-system.svc.cluster.local

0.0.0.0 80 Trans: raw_buffer; App: http/1.1,h2c Route: 80

0.0.0.0 80 ALL PassthroughCluster

10.200.1.1 443 ALL Cluster: outbound|443||kubernetes.default.svc.cluster.local

10.200.1.172 443 ALL Cluster: outbound|443||istiod.istio-system.svc.cluster.local

10.200.1.199 443 ALL Cluster: outbound|443||istio-ingressgateway.istio-system.svc.cluster.local

10.200.1.214 443 ALL Cluster: outbound|443||metrics-server.kube-system.svc.cluster.local

10.200.1.59 3000 Trans: raw_buffer; App: http/1.1,h2c Route: grafana.istio-system.svc.cluster.local:3000

10.200.1.59 3000 ALL Cluster: outbound|3000||grafana.istio-system.svc.cluster.local

0.0.0.0 9090 Trans: raw_buffer; App: http/1.1,h2c Route: 9090

0.0.0.0 9090 ALL PassthroughCluster

10.200.1.10 9153 Trans: raw_buffer; App: http/1.1,h2c Route: kube-dns.kube-system.svc.cluster.local:9153

10.200.1.10 9153 ALL Cluster: outbound|9153||kube-dns.kube-system.svc.cluster.local

0.0.0.0 9411 Trans: raw_buffer; App: http/1.1,h2c Route: 9411

0.0.0.0 9411 ALL PassthroughCluster

10.200.1.75 14250 Trans: raw_buffer; App: http/1.1,h2c Route: jaeger-collector.istio-system.svc.cluster.local:14250

10.200.1.75 14250 ALL Cluster: outbound|14250||jaeger-collector.istio-system.svc.cluster.local

10.200.1.75 14268 Trans: raw_buffer; App: http/1.1,h2c Route: jaeger-collector.istio-system.svc.cluster.local:14268

10.200.1.75 14268 ALL Cluster: outbound|14268||jaeger-collector.istio-system.svc.cluster.local

0.0.0.0 15001 ALL PassthroughCluster

0.0.0.0 15001 Addr: *:15001 Non-HTTP/Non-TCP

0.0.0.0 15006 Addr: *:15006 Non-HTTP/Non-TCP

0.0.0.0 15006 Trans: tls; App: istio-http/1.0,istio-http/1.1,istio-h2; Addr: 0.0.0.0/0 InboundPassthroughClusterIpv4

0.0.0.0 15006 Trans: raw_buffer; App: http/1.1,h2c; Addr: 0.0.0.0/0 InboundPassthroughClusterIpv4

0.0.0.0 15006 Trans: tls; App: TCP TLS; Addr: 0.0.0.0/0 InboundPassthroughClusterIpv4

0.0.0.0 15006 Trans: raw_buffer; Addr: 0.0.0.0/0 InboundPassthroughClusterIpv4

0.0.0.0 15006 Trans: tls; Addr: 0.0.0.0/0 InboundPassthroughClusterIpv4

0.0.0.0 15006 Trans: tls; App: istio,istio-peer-exchange,istio-http/1.0,istio-http/1.1,istio-h2; Addr: *:3000 Cluster: inbound|3000||

0.0.0.0 15006 Trans: raw_buffer; Addr: *:3000 Cluster: inbound|3000||

0.0.0.0 15010 Trans: raw_buffer; App: http/1.1,h2c Route: 15010

0.0.0.0 15010 ALL PassthroughCluster

10.200.1.172 15012 ALL Cluster: outbound|15012||istiod.istio-system.svc.cluster.local

0.0.0.0 15014 Trans: raw_buffer; App: http/1.1,h2c Route: 15014

0.0.0.0 15014 ALL PassthroughCluster

0.0.0.0 15021 ALL Inline Route: /healthz/ready*

10.200.1.199 15021 Trans: raw_buffer; App: http/1.1,h2c Route: istio-ingressgateway.istio-system.svc.cluster.local:15021

10.200.1.199 15021 ALL Cluster: outbound|15021||istio-ingressgateway.istio-system.svc.cluster.local

0.0.0.0 15090 ALL Inline Route: /stats/prometheus*

0.0.0.0 16685 Trans: raw_buffer; App: http/1.1,h2c Route: 16685

0.0.0.0 16685 ALL PassthroughCluster

0.0.0.0 20001 Trans: raw_buffer; App: http/1.1,h2c Route: 20001

0.0.0.0 20001 ALL PassthroughCluster

$ docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/catalog.istioinaction

NAME DOMAINS MATCH VIRTUAL SERVICE

80 catalog, catalog.istioinaction + 1 more... /*

80 istio-ingressgateway.istio-system, 10.200.1.199 /*

80 tracing.istio-system, 10.200.1.157 /*

9090 kiali.istio-system, 10.200.1.111 /*

9090 prometheus.istio-system, 10.200.1.248 /*

9411 jaeger-collector.istio-system, 10.200.1.75 /*

9411 zipkin.istio-system, 10.200.1.12 /*

istio-ingressgateway.istio-system.svc.cluster.local:15021 * /*

15014 istiod.istio-system, 10.200.1.172 /*

grafana.istio-system.svc.cluster.local:3000 * /*

15010 istiod.istio-system, 10.200.1.172 /*

jaeger-collector.istio-system.svc.cluster.local:14250 * /*

20001 kiali.istio-system, 10.200.1.111 /*

jaeger-collector.istio-system.svc.cluster.local:14268 * /*

kube-dns.kube-system.svc.cluster.local:9153 * /*

16685 tracing.istio-system, 10.200.1.157 /*

InboundPassthroughClusterIpv4 * /*

* /stats/prometheus*

InboundPassthroughClusterIpv4 * /*

inbound|3000|| * /*

* /healthz/ready*

inbound|3000|| * /*

$ docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/catalog.istioinaction

SERVICE FQDN PORT SUBSET DIRECTION TYPE DESTINATION RULE

3000 - inbound ORIGINAL_DST

BlackHoleCluster - - - STATIC

InboundPassthroughClusterIpv4 - - - ORIGINAL_DST

PassthroughCluster - - - ORIGINAL_DST

agent - - - STATIC

catalog.istioinaction.svc.cluster.local 80 - outbound EDS

grafana.istio-system.svc.cluster.local 3000 - outbound EDS

istio-ingressgateway.istio-system.svc.cluster.local 80 - outbound EDS

istio-ingressgateway.istio-system.svc.cluster.local 443 - outbound EDS

istio-ingressgateway.istio-system.svc.cluster.local 15021 - outbound EDS

istiod.istio-system.svc.cluster.local 443 - outbound EDS

istiod.istio-system.svc.cluster.local 15010 - outbound EDS

istiod.istio-system.svc.cluster.local 15012 - outbound EDS

istiod.istio-system.svc.cluster.local 15014 - outbound EDS

jaeger-collector.istio-system.svc.cluster.local 9411 - outbound EDS

jaeger-collector.istio-system.svc.cluster.local 14250 - outbound EDS

jaeger-collector.istio-system.svc.cluster.local 14268 - outbound EDS

kiali.istio-system.svc.cluster.local 9090 - outbound EDS

kiali.istio-system.svc.cluster.local 20001 - outbound EDS

kube-dns.kube-system.svc.cluster.local 53 - outbound EDS

kube-dns.kube-system.svc.cluster.local 9153 - outbound EDS

kubernetes.default.svc.cluster.local 443 - outbound EDS

metrics-server.kube-system.svc.cluster.local 443 - outbound EDS

prometheus.istio-system.svc.cluster.local 9090 - outbound EDS

prometheus_stats - - - STATIC

sds-grpc - - - STATIC

tracing.istio-system.svc.cluster.local 80 - outbound EDS

tracing.istio-system.svc.cluster.local 16685 - outbound EDS

xds-grpc - - - STATIC

zipkin - - - STRICT_DNS

zipkin.istio-system.svc.cluster.local 9411 - outbound EDS

$ docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/catalog.istioinaction

ENDPOINT STATUS OUTLIER CHECK CLUSTER

10.10.0.15:15010 HEALTHY OK outbound|15010||istiod.istio-system.svc.cluster.local

10.10.0.15:15012 HEALTHY OK outbound|15012||istiod.istio-system.svc.cluster.local

10.10.0.15:15014 HEALTHY OK outbound|15014||istiod.istio-system.svc.cluster.local

10.10.0.15:15017 HEALTHY OK outbound|443||istiod.istio-system.svc.cluster.local

10.10.0.16:8080 HEALTHY OK outbound|80||istio-ingressgateway.istio-system.svc.cluster.local

10.10.0.16:8443 HEALTHY OK outbound|443||istio-ingressgateway.istio-system.svc.cluster.local

10.10.0.16:15021 HEALTHY OK outbound|15021||istio-ingressgateway.istio-system.svc.cluster.local

10.10.0.17:3000 HEALTHY OK outbound|3000||grafana.istio-system.svc.cluster.local

10.10.0.18:9090 HEALTHY OK outbound|9090||prometheus.istio-system.svc.cluster.local

10.10.0.19:9411 HEALTHY OK outbound|9411||jaeger-collector.istio-system.svc.cluster.local

10.10.0.19:9411 HEALTHY OK outbound|9411||zipkin.istio-system.svc.cluster.local

10.10.0.19:14250 HEALTHY OK outbound|14250||jaeger-collector.istio-system.svc.cluster.local

10.10.0.19:14268 HEALTHY OK outbound|14268||jaeger-collector.istio-system.svc.cluster.local

10.10.0.19:16685 HEALTHY OK outbound|16685||tracing.istio-system.svc.cluster.local

10.10.0.19:16686 HEALTHY OK outbound|80||tracing.istio-system.svc.cluster.local

10.10.0.2:53 HEALTHY OK outbound|53||kube-dns.kube-system.svc.cluster.local

10.10.0.2:9153 HEALTHY OK outbound|9153||kube-dns.kube-system.svc.cluster.local

10.10.0.20:9090 HEALTHY OK outbound|9090||kiali.istio-system.svc.cluster.local

10.10.0.20:20001 HEALTHY OK outbound|20001||kiali.istio-system.svc.cluster.local

10.10.0.21:3000 HEALTHY OK inbound|3000||

10.10.0.21:3000 HEALTHY OK outbound|80||catalog.istioinaction.svc.cluster.local

10.10.0.4:53 HEALTHY OK outbound|53||kube-dns.kube-system.svc.cluster.local

10.10.0.4:9153 HEALTHY OK outbound|9153||kube-dns.kube-system.svc.cluster.local

10.10.0.5:10250 HEALTHY OK outbound|443||metrics-server.kube-system.svc.cluster.local

10.200.1.12:9411 HEALTHY OK zipkin

127.0.0.1:15000 HEALTHY OK prometheus_stats

127.0.0.1:15020 HEALTHY OK agent

172.18.0.2:6443 HEALTHY OK outbound|443||kubernetes.default.svc.cluster.local

unix://./etc/istio/proxy/XDS HEALTHY OK xds-grpc

unix://./var/run/secrets/workload-spiffe-uds/socket HEALTHY OK sds-grpc

# 신규 터미널 : istio-ingressgateway 파드

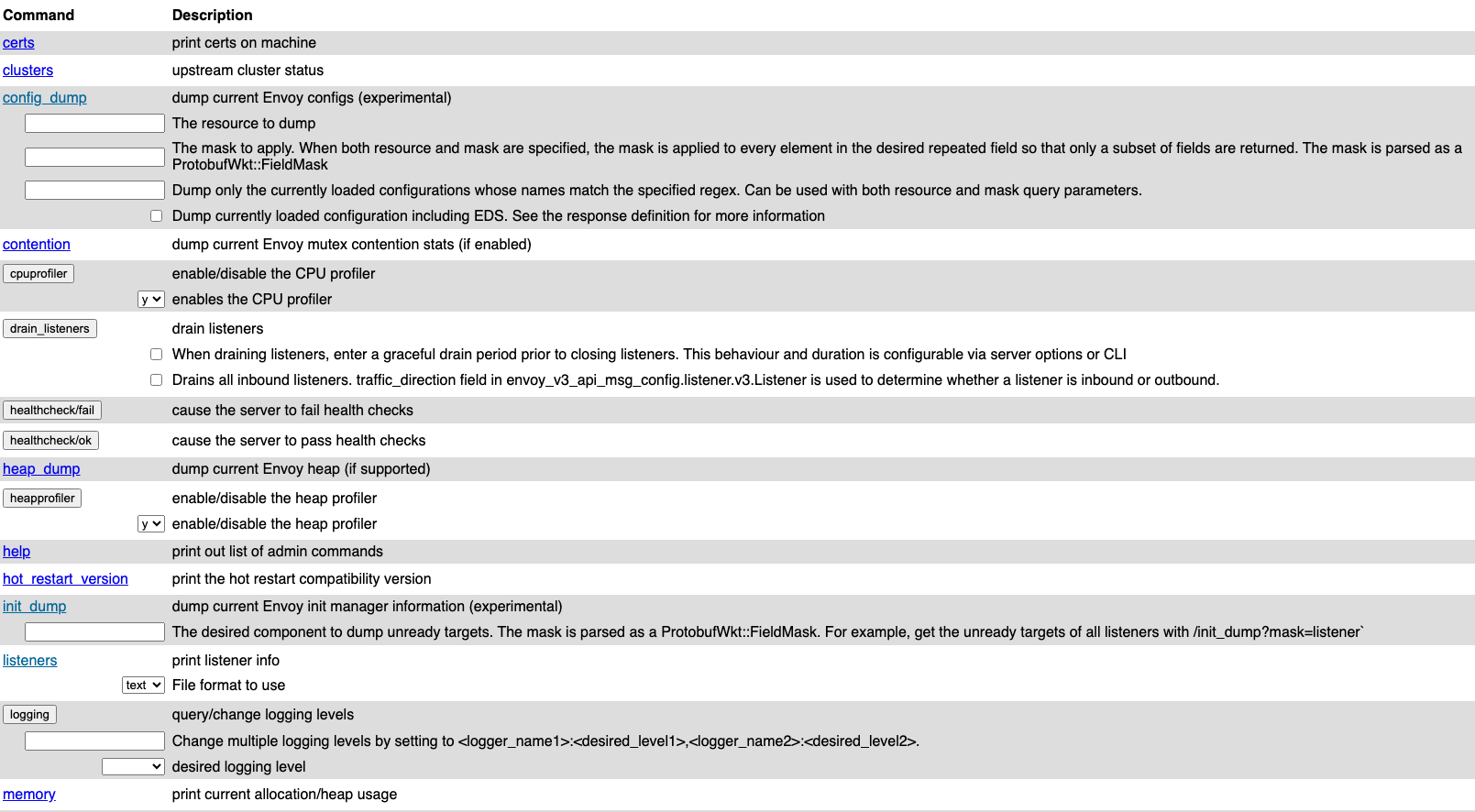

kubectl port-forward deploy/istio-ingressgateway -n istio-system 15000:15000

#

open http://127.0.0.1:15000

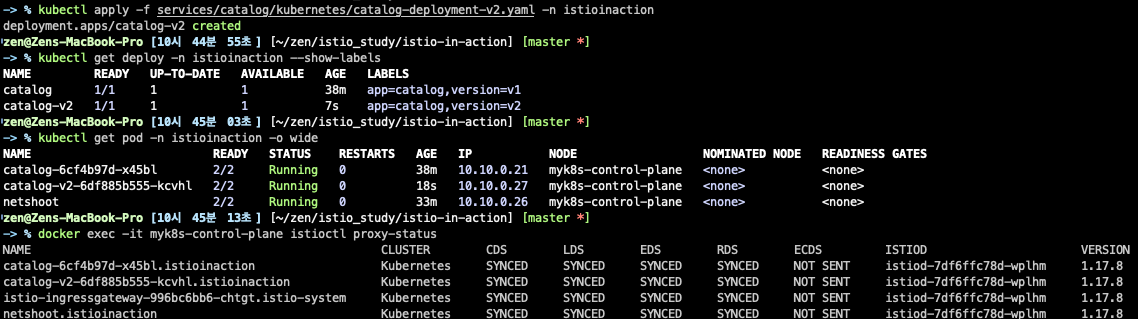

catalog 서비스 v2 배포

# catalog 서비스 v2 를 배포 : v2에서는 imageUrl 필드가 추가

kubectl apply -f services/catalog/kubernetes/catalog-deployment-v2.yaml -n istioinaction

kubectl get deploy -n istioinaction --show-labels

NAME READY UP-TO-DATE AVAILABLE AGE LABELS

catalog 1/1 1 1 30m app=catalog,version=v1

catalog-v2 1/1 1 1 34s app=catalog,version=v2

kubectl get pod -n istioinaction -o wide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

catalog-6cf4b97d-ftl77 2/2 Running 0 43m 10.10.0.14 myk8s-control-plane <none> <none>

catalog-v2-6df885b555-6hmcl 2/2 Running 0 13m 10.10.0.15 myk8s-control-plane <none> <none>

docker exec -it myk8s-control-plane istioctl proxy-status

NAME CLUSTER CDS LDS EDS RDS ECDS ISTIOD VERSION

catalog-6cf4b97d-ftl77.istioinaction Kubernetes SYNCED SYNCED SYNCED SYNCED NOT SENT istiod-7df6ffc78d-fl492 1.17.8

catalog-v2-6df885b555-6hmcl.istioinaction Kubernetes SYNCED SYNCED SYNCED SYNCED NOT SENT istiod-7df6ffc78d-fl492 1.17.8

istio-ingressgateway-996bc6bb6-zvtdc.istio-system Kubernetes SYNCED SYNCED SYNCED SYNCED NOT SENT istiod-7df6ffc78d-fl492 1.17.8

# 호출 테스트 : v1 , v2 호출 확인

for i in {1..10}; do curl -s http://catalog.istioinaction.io:30000/items/ ; printf "\n\n"; done

# istio-ingressgateway proxy-config 확인

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/istio-ingressgateway.istio-system --fqdn catalog.istioinaction.svc.cluster.local

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/istio-ingressgateway.istio-system --fqdn catalog.istioinaction.svc.cluster.local -o json

...

"name": "outbound|80||catalog.istioinaction.svc.cluster.local",

"type": "EDS",

"edsClusterConfig": {

"edsConfig": {

"ads": {},

"initialFetchTimeout": "0s",

"resourceApiVersion": "V3"

},

"serviceName": "outbound|80||catalog.istioinaction.svc.cluster.local"

},

"connectTimeout": "10s",

"lbPolicy": "LEAST_REQUEST",

"circuitBreakers": {

"thresholds": [

{

"maxConnections": 4294967295,

"maxPendingRequests": 4294967295,

"maxRequests": 4294967295,

"maxRetries": 4294967295,

"trackRemaining": true

}

]

},

"commonLbConfig": {

"localityWeightedLbConfig": {}

},

...

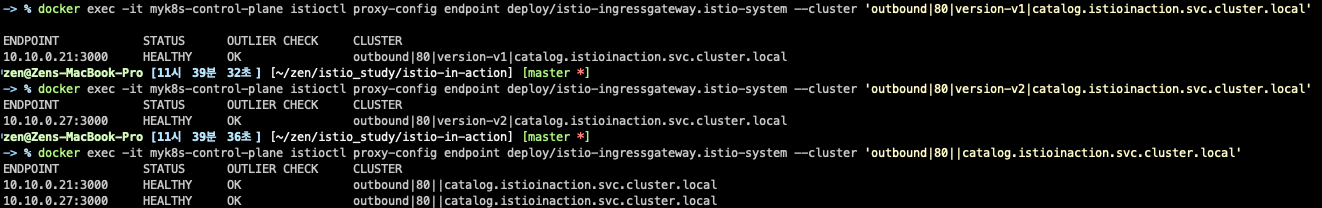

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/istio-ingressgateway.istio-system --cluster 'outbound|80||catalog.istioinaction.svc.cluster.local'

ENDPOINT STATUS OUTLIER CHECK CLUSTER

10.10.0.21:3000 HEALTHY OK outbound|80||catalog.istioinaction.svc.cluster.local

10.10.0.27:3000 HEALTHY OK outbound|80||catalog.istioinaction.svc.cluster.local

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/istio-ingressgateway.istio-system --cluster 'outbound|80||catalog.istioinaction.svc.cluster.local' -o json

...

{

"name": "outbound|80||catalog.istioinaction.svc.cluster.local",

"addedViaApi": true,

"hostStatuses": [

{

"address": {

"socketAddress": {

"address": "10.10.0.14",

"portValue": 3000

}

},

"stats": [

{

"name": "cx_connect_fail"

},

{

"value": "8",

"name": "cx_total"

},

{

"name": "rq_error"

},

{

"value": "315",

"name": "rq_success"

},

{

"name": "rq_timeout"

},

{

"value": "315",

"name": "rq_total"

},

{

"type": "GAUGE",

"value": "8",

"name": "cx_active"

},

{

"type": "GAUGE",

"name": "rq_active"

}

],

"healthStatus": {

"edsHealthStatus": "HEALTHY"

},

"weight": 1,

"locality": {}

},

{

"address": {

"socketAddress": {

"address": "10.10.0.15",

"portValue": 3000

}

},

"stats": [

{

"name": "cx_connect_fail"

},

{

"value": "8",

"name": "cx_total"

},

{

"name": "rq_error"

},

{

"value": "308",

"name": "rq_success"

},

{

"name": "rq_timeout"

},

{

"value": "308",

"name": "rq_total"

},

{

"type": "GAUGE",

"value": "8",

"name": "cx_active"

},

{

"type": "GAUGE",

"name": "rq_active"

}

],

"healthStatus": {

"edsHealthStatus": "HEALTHY"

},

"weight": 1,

"locality": {}

}

],

"circuitBreakers": {

"thresholds": [

{

"maxConnections": 4294967295,

"maxPendingRequests": 4294967295,

"maxRequests": 4294967295,

"maxRetries": 4294967295

},

{

"priority": "HIGH",

"maxConnections": 1024,

"maxPendingRequests": 1024,

"maxRequests": 1024,

"maxRetries": 3

}

]

},

"observabilityName": "outbound|80||catalog.istioinaction.svc.cluster.local",

"edsServiceName": "outbound|80||catalog.istioinaction.svc.cluster.local"

},

...

# catalog proxy-config 도 직접 확인해보자

$ docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/catalog.istioinaction --cluster 'outbound|80||catalog.istioinaction.svc.cluster.local'

ENDPOINT STATUS OUTLIER CHECK CLUSTER

10.10.0.21:3000 HEALTHY OK outbound|80||catalog.istioinaction.svc.cluster.local

10.10.0.27:3000 HEALTHY OK outbound|80||catalog.istioinaction.svc.cluster.local

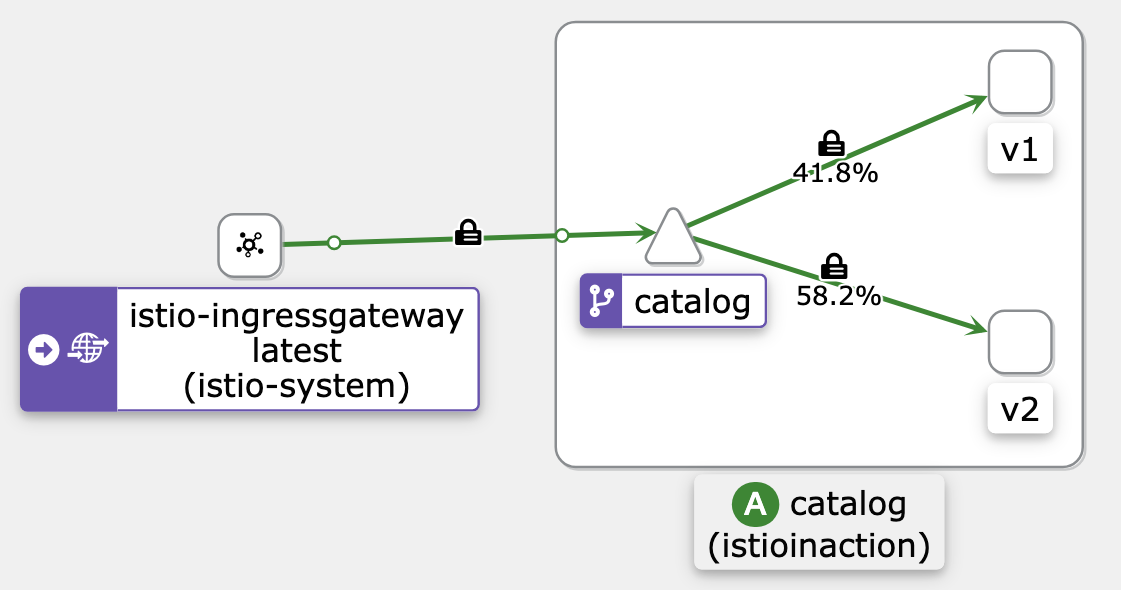

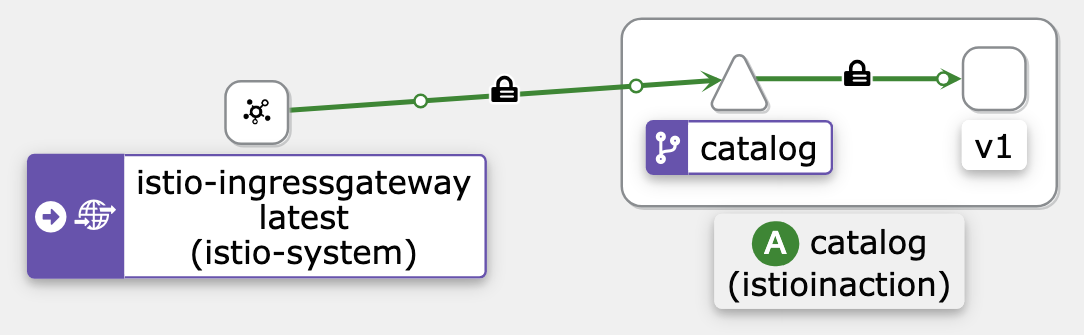

모든 트래픽을 v1으로 라우팅

kubectl get pod -l app=catalog -n istioinaction --show-labels

NAME READY STATUS RESTARTS AGE LABELS

catalog-6cf4b97d-x45bl 2/2 Running 0 90m app=catalog,pod-template-hash=6cf4b97d,security.istio.io/tlsMode=istio,service.istio.io/canonical-name=catalog,service.istio.io/canonical-revision=v1,version=v1

catalog-v2-6df885b555-kcvhl 2/2 Running 0 52m app=catalog,pod-template-hash=6df885b555,security.istio.io/tlsMode=istio,service.istio.io/canonical-name=catalog,service.istio.io/canonical-revision=v2,version=v2

cat ch5/catalog-dest-rule.yaml

apiVersion: networking.istio.io/v1alpha3

kind: DestinationRule

metadata:

name: catalog

spec:

host: catalog.istioinaction.svc.cluster.local

subsets:

- name: version-v1

labels:

version: v1

- name: version-v2

labels:

version: v2

kubectl apply -f ch5/catalog-dest-rule.yaml -n istioinaction

# 확인

kubectl get destinationrule -n istioinaction

NAME HOST AGE

catalog catalog.istioinaction.svc.cluster.local 5s

# catalog proxy-config 확인 : SUBSET(v1, v2, -) 확인

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/istio-ingressgateway.istio-system --fqdn catalog.istioinaction.svc.cluster.local

SERVICE FQDN PORT SUBSET DIRECTION TYPE DESTINATION RULE

catalog.istioinaction.svc.cluster.local 80 - outbound EDS catalog.istioinaction

catalog.istioinaction.svc.cluster.local 80 version-v1 outbound EDS catalog.istioinaction

catalog.istioinaction.svc.cluster.local 80 version-v2 outbound EDS catalog.istioinaction

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/istio-ingressgateway.istio-system --subset version-v1 -o json

...

"name": "outbound|80|version-v1|catalog.istioinaction.svc.cluster.local",

"type": "EDS",

"edsClusterConfig": {

"edsConfig": {

"ads": {},

"initialFetchTimeout": "0s",

"resourceApiVersion": "V3"

},

"serviceName": "outbound|80|version-v1|catalog.istioinaction.svc.cluster.local"

},

"connectTimeout": "10s",

"lbPolicy": "LEAST_REQUEST",

...

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/istio-ingressgateway.istio-system --subset version-v2 -o json

...

"name": "outbound|80|version-v2|catalog.istioinaction.svc.cluster.local",

"type": "EDS",

"edsClusterConfig": {

"edsConfig": {

"ads": {},

"initialFetchTimeout": "0s",

"resourceApiVersion": "V3"

},

"serviceName": "outbound|80|version-v2|catalog.istioinaction.svc.cluster.local"

},

"connectTimeout": "10s",

"lbPolicy": "LEAST_REQUEST",

...

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/istio-ingressgateway.istio-system --fqdn catalog.istioinaction.svc.cluster.local -o json

...

"name": "outbound|80||catalog.istioinaction.svc.cluster.local",

"type": "EDS",

"edsClusterConfig": {

"edsConfig": {

"ads": {},

"initialFetchTimeout": "0s",

"resourceApiVersion": "V3"

},

"serviceName": "outbound|80||catalog.istioinaction.svc.cluster.local"

},

...

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/istio-ingressgateway.istio-system | egrep 'ENDPOINT|istioinaction'

ENDPOINT STATUS OUTLIER CHECK CLUSTER

10.10.0.21:3000 HEALTHY OK outbound|80|version-v1|catalog.istioinaction.svc.cluster.local

10.10.0.21:3000 HEALTHY OK outbound|80||catalog.istioinaction.svc.cluster.local

10.10.0.27:3000 HEALTHY OK outbound|80|version-v2|catalog.istioinaction.svc.cluster.local

10.10.0.27:3000 HEALTHY OK outbound|80||catalog.istioinaction.svc.cluster.local

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/istio-ingressgateway.istio-system --cluster 'outbound|80|version-v1|catalog.istioinaction.svc.cluster.local'

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/istio-ingressgateway.istio-system --cluster 'outbound|80|version-v1|catalog.istioinaction.svc.cluster.local' -o json

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/istio-ingressgateway.istio-system --cluster 'outbound|80|version-v2|catalog.istioinaction.svc.cluster.local'

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/istio-ingressgateway.istio-system --cluster 'outbound|80|version-v2|catalog.istioinaction.svc.cluster.local' -o json

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/istio-ingressgateway.istio-system --cluster 'outbound|80||catalog.istioinaction.svc.cluster.local'

# VirtualService 수정 (subset 추가)

cat ch5/catalog-vs-v1.yaml

apiVersion: networking.istio.io/v1alpha3

kind: VirtualService

metadata:

name: catalog-vs-from-gw

spec:

hosts:

- "catalog.istioinaction.io"

gateways:

- catalog-gateway

http:

- route:

- destination:

host: catalog

subset: version-v1

kubectl apply -f ch5/catalog-vs-v1.yaml -n istioinaction

# 호출 테스트 : v1

for i in {1..10}; do curl -s http://catalog.istioinaction.io:30000/items/ ; printf "\n\n"; done

# 세부 정보 확인

# routes 에 virtualHosts 항목에 routes.route 에 cluster 부분이 ...version-v1... 설정 확인

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/istio-ingressgateway.istio-system

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/istio-ingressgateway.istio-system --name http.8080 -o json

...

"virtualHosts": [

{

"name": "catalog.istioinaction.io:80",

"domains": [

"catalog.istioinaction.io"

],

"routes": [

{

"match": {

"prefix": "/"

},

"route": {

"cluster": "outbound|80|version-v1|catalog.istioinaction.svc.cluster.local",

"timeout": "0s",

"retryPolicy": {

"retryOn": "connect-failure,refused-stream,unavailable,cancelled,retriable-status-codes",

"numRetries": 2,

...

# cluster

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/istio-ingressgateway.istio-system --fqdn catalog.istioinaction.svc.cluster.local

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/istio-ingressgateway.istio-system --subset version-v1

SERVICE FQDN PORT SUBSET DIRECTION TYPE DESTINATION RULE

catalog.istioinaction.svc.cluster.local 80 version-v1 outbound EDS catalog.istioinaction

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/istio-ingressgateway.istio-system --subset version-v1 -o json

...

"name": "outbound|80|version-v1|catalog.istioinaction.svc.cluster.local",

"type": "EDS",

"edsClusterConfig": {

"edsConfig": {

"ads": {},

"initialFetchTimeout": "0s",

"resourceApiVersion": "V3"

},

"serviceName": "outbound|80|version-v1|catalog.istioinaction.svc.cluster.local"

},

...

"metadata": {

"filterMetadata": {

"istio": {

"config": "/apis/networking.istio.io/v1alpha3/namespaces/istioinaction/destination-rule/catalog",

"default_original_port": 80,

"services": [

{

"host": "catalog.istioinaction.svc.cluster.local",

"name": "catalog",

"namespace": "istioinaction"

}

],

"subset": "version-v1"

...

# endpoint

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/istio-ingressgateway.istio-system | egrep 'ENDPOINT|istioinaction'

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/istio-ingressgateway.istio-system --cluster 'outbound|80|version-v1|catalog.istioinaction.svc.cluster.local'

ENDPOINT STATUS OUTLIER CHECK CLUSTER

10.10.0.16:3000 HEALTHY OK outbound|80|version-v1|catalog.istioinaction.svc.cluster.local

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/istio-ingressgateway.istio-system --cluster 'outbound|80|version-v1|catalog.istioinaction.svc.cluster.local' -o json

...

# istio-proxy (catalog)

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/catalog.istioinaction --subset version-v1 -o json

...

"metadata": {

"filterMetadata": {

"istio": {

"config": "/apis/networking.istio.io/v1alpha3/namespaces/istioinaction/destination-rule/catalog",

"default_original_port": 80,

"services": [

{

"host": "catalog.istioinaction.svc.cluster.local",

"name": "catalog",

"namespace": "istioinaction"

}

],

"subset": "version-v1"

}

}

},

...

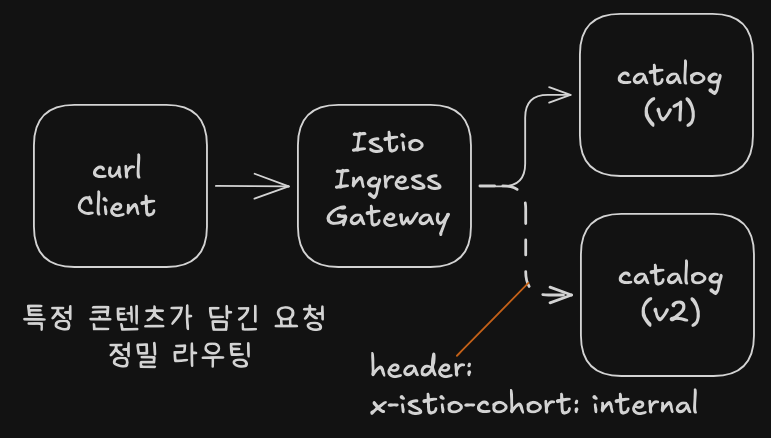

특정 요청을 v2로 라우팅

- HTTP 요청 헤더를

x-istio-cohort: internal를 포함한 트래픽은 v2로 보낸다.

cat ch5/catalog-vs-v2-request.yaml

apiVersion: networking.istio.io/v1alpha3

kind: VirtualService

metadata:

name: catalog-vs-from-gw

spec:

hosts:

- "catalog.istioinaction.io"

gateways:

- catalog-gateway

http:

- match:

- headers:

x-istio-cohort:

exact: "internal"

route:

- destination:

host: catalog

subset: version-v2

- route:

- destination:

host: catalog

subset: version-v1

kubectl apply -f ch5/catalog-vs-v2-request.yaml -n istioinaction

# 호출 테스트 : 여전히 v1

for i in {1..10}; do curl -s http://catalog.istioinaction.io:30000/items/ ; printf "\n\n"; done

# 요청 헤더 포함 호출 테스트 : v2!

curl http://catalog.istioinaction.io:30000/items -H "x-istio-cohort: internal"

# (옵션) 신규 터미널 : v2 반복 접속

while true; do curl -s http://catalog.istioinaction.io:30000/items/ -H "x-istio-cohort: internal" -I | head -n 1 ; date "+%Y-%m-%d %H:%M:%S" ; sleep 2; echo; done

# 상세 확인

# route 추가 : routes 에 2개의 route 확인 - 위에서 부터 적용되는 순서 중요!

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/istio-ingressgateway.istio-system --name http.8080

NAME DOMAINS MATCH VIRTUAL SERVICE

http.8080 catalog.istioinaction.io /* catalog-vs-from-gw.istioinaction

http.8080 catalog.istioinaction.io /* catalog-vs-from-gw.istioinaction

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/istio-ingressgateway.istio-system --name http.8080 -o json

...

"virtualHosts": [

{

"name": "catalog.istioinaction.io:80",

"domains": [

"catalog.istioinaction.io"

],

"routes": [

{

"match": {

"prefix": "/",

"caseSensitive": true,

"headers": [

{

"name": "x-istio-cohort",

"stringMatch": {

"exact": "internal"

}

}

]

},

"route": {

"cluster": "outbound|80|version-v2|catalog.istioinaction.svc.cluster.local",

"timeout": "0s",

...

{

"match": {

"prefix": "/"

},

"route": {

"cluster": "outbound|80|version-v1|catalog.istioinaction.svc.cluster.local",

...

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/istio-ingressgateway.istio-system --fqdn catalog.istioinaction.svc.cluster.local

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/istio-ingressgateway.istio-system | egrep 'ENDPOINT|istioinaction'

# istio-proxy (catalog)에는 routes 정보가 아래 cluster 로 보내는 1개만 있다. 즉 istio-proxy(istio-ingressgateway)가 routes 분기 처리하는 것을 알 수 있다.

## "cluster": "outbound|80||catalog.istioinaction.svc.cluster.local"

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/catalog.istioinaction --name 80 -o json

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/catalog.istioinaction | grep catalog

80 catalog, catalog.istioinaction + 1 more... /*

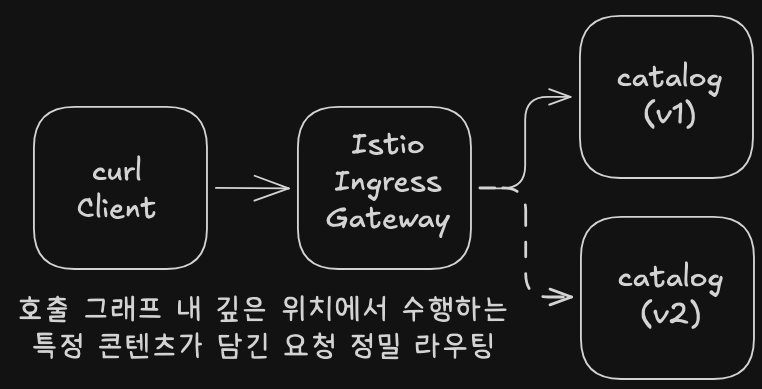

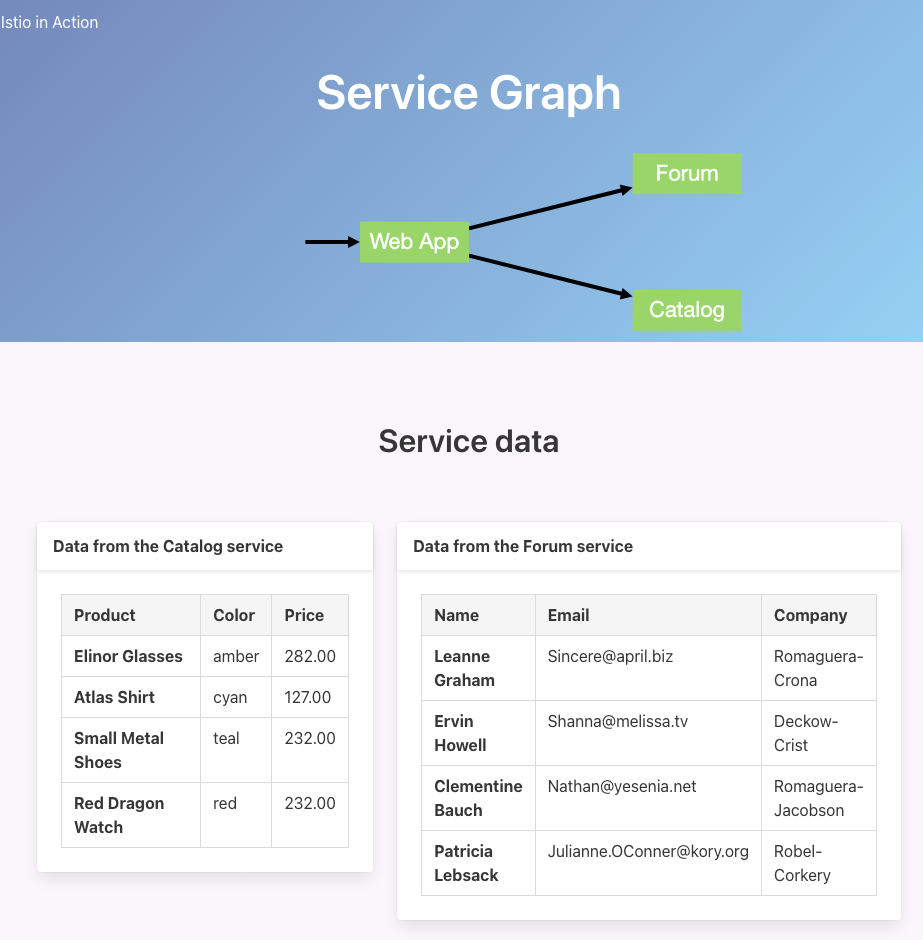

호출 그래프 내 깊은 위치에서 라우팅

# 초기화

kubectl delete gateway,virtualservice,destinationrule --all -n istioinaction

# webapp 기동

kubectl apply -n istioinaction -f services/webapp/kubernetes/webapp.yaml

kubectl apply -f services/catalog/kubernetes/catalog.yaml -n istioinaction # 이미 배포 상태

kubectl apply -f services/catalog/kubernetes/catalog-deployment-v2.yaml -n istioinaction # 이미 배포 상태

# 확인

kubectl get deploy,pod,svc,ep -n istioinaction

NAME READY UP-TO-DATE AVAILABLE AGE

deployment.apps/catalog 1/1 1 1 55m

deployment.apps/catalog-v2 1/1 1 1 48m

deployment.apps/webapp 1/1 1 1 42s

NAME READY STATUS RESTARTS AGE

pod/catalog-6cf4b97d-x45bl 2/2 Running 0 55m

pod/catalog-v2-6df885b555-kcvhl 2/2 Running 0 48m

pod/webapp-7685bcb84-dhprj 2/2 Running 0 42s

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

service/catalog ClusterIP 10.200.1.229 <none> 80/TCP 55m

service/webapp ClusterIP 10.200.1.113 <none> 80/TCP 42s

NAME ENDPOINTS AGE

endpoints/catalog 10.10.0.21:3000,10.10.0.27:3000 55m

endpoints/webapp 10.10.0.28:8080 42s

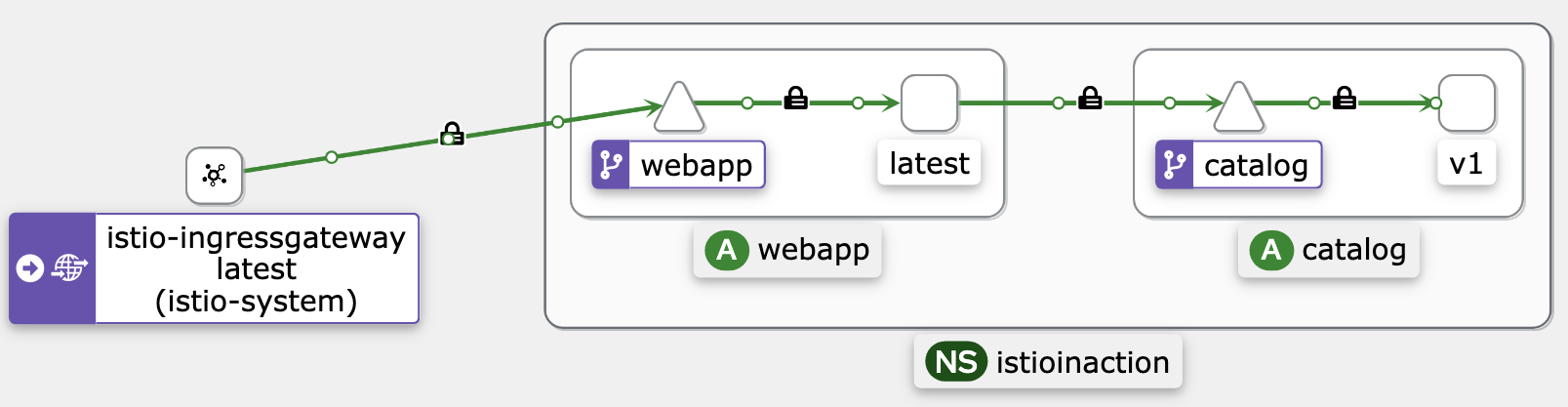

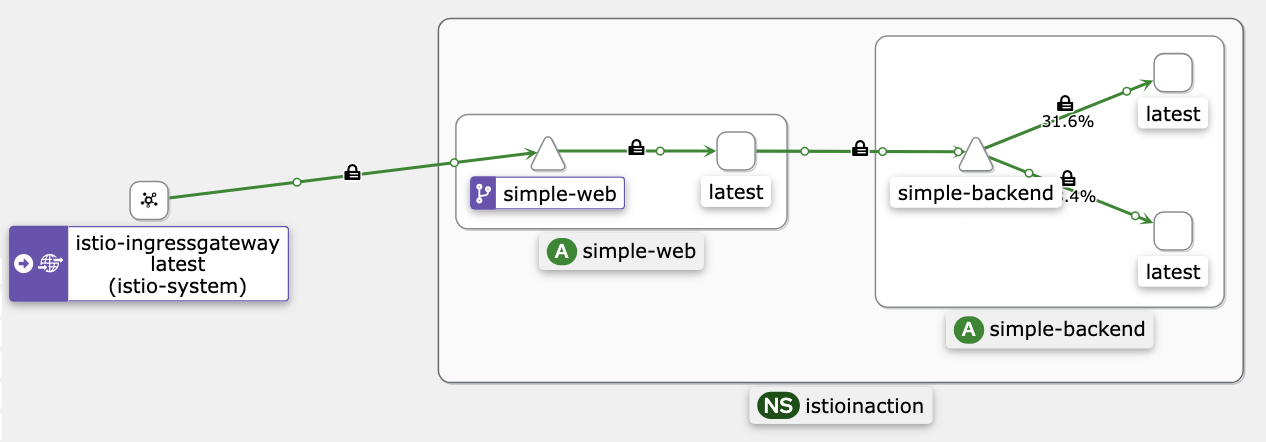

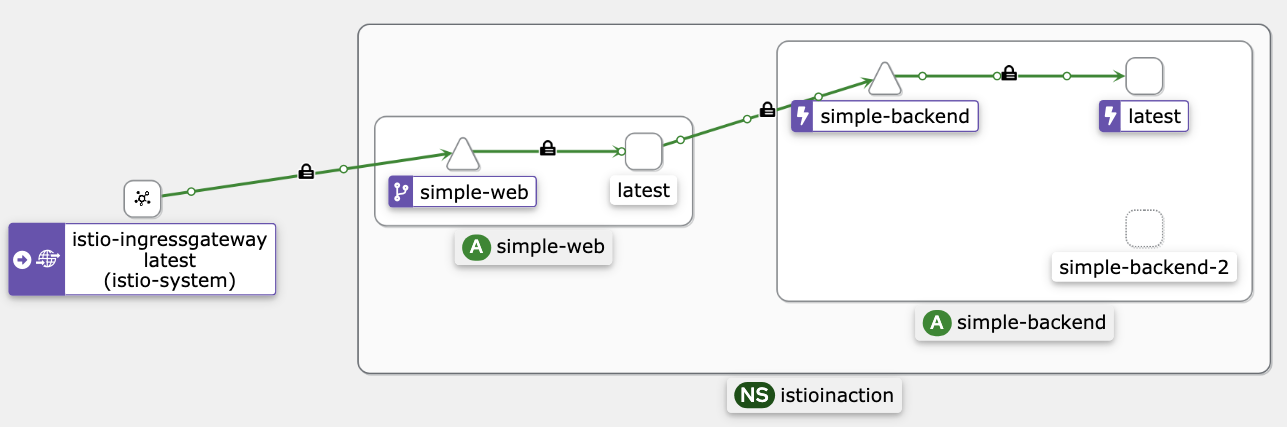

- GW, VS 설정 후 호출 테스트: webapp -> catalog는 k8s service(clusterIP) 라우팅 사용

# Now, set up the Istio ingress gateway to route to the webapp service

cat services/webapp/istio/webapp-catalog-gw-vs.yaml

---

apiVersion: networking.istio.io/v1alpha3

kind: Gateway

metadata:

name: coolstore-gateway

spec:

selector:

istio: ingressgateway # use istio default controller

servers:

- port:

number: 80

name: http

protocol: HTTP

hosts:

- "webapp.istioinaction.io"

---

apiVersion: networking.istio.io/v1alpha3

kind: VirtualService

metadata:

name: webapp-virtualservice

spec:

hosts:

- "webapp.istioinaction.io"

gateways:

- coolstore-gateway

http:

- route:

- destination:

host: webapp

port:

number: 80

kubectl apply -f services/webapp/istio/webapp-catalog-gw-vs.yaml -n istioinaction

# 확인

kubectl get gw,vs -n istioinaction

NAME AGE

gateway.networking.istio.io/coolstore-gateway 3s

NAME GATEWAYS HOSTS AGE

virtualservice.networking.istio.io/webapp-virtualservice ["coolstore-gateway"] ["webapp.istioinaction.io"] 3s

# 도메인 질의를 위한 임시 설정 : 실습 완료 후에는 삭제 해둘 것

echo "127.0.0.1 webapp.istioinaction.io" | sudo tee -a /etc/hosts

cat /etc/hosts | tail -n 3

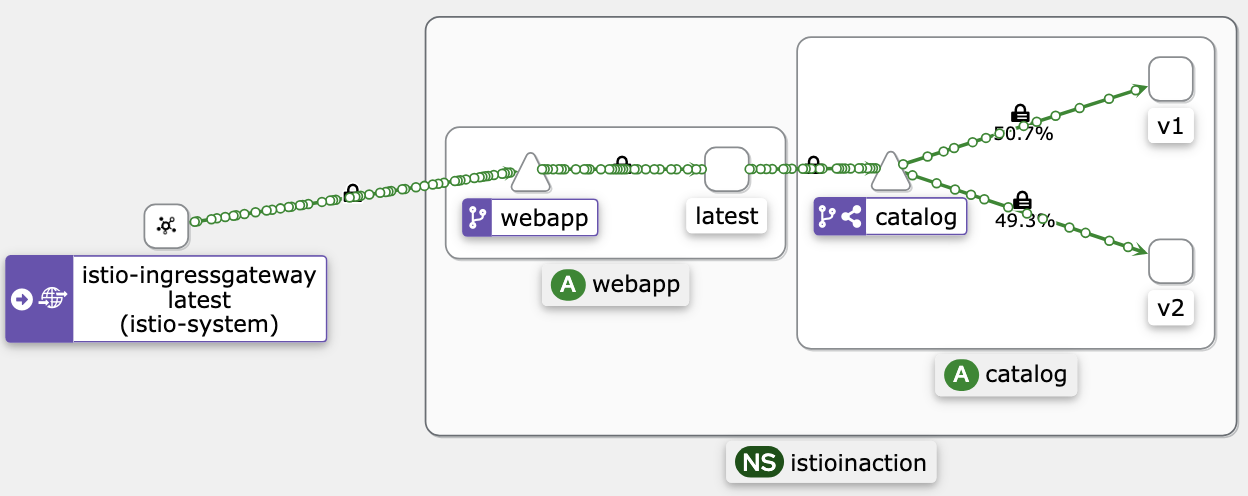

# 호출테스트 : 외부(web, curl) → ingressgw → webapp → catalog (v1, v2)

curl -s http://webapp.istioinaction.io:30000/api/catalog | jq

# 반복 호출테스트 : 신규터미널 2개에 아래 각각 실행 해두기

while true; do curl -s http://webapp.istioinaction.io:30000/api/catalog -I | head -n 1 ; date "+%Y-%m-%d %H:%M:%S" ; sleep 1; echo; done

while true; do curl -s http://webapp.istioinaction.io:30000/api/catalog -H "x-istio-cohort: internal" -I | head -n 1 ; date "+%Y-%m-%d %H:%M:%S" ; sleep 2; echo; done

# proxy-config : istio-ingressgateway

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/istio-ingressgateway.istio-system --name http.8080

NAME DOMAINS MATCH VIRTUAL SERVICE

http.8080 webapp.istioinaction.io /* webapp-virtualservice.istioinaction

=> route."cluster": "outbound|80||webapp.istioinaction.svc.cluster.local"

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/istio-ingressgateway.istio-system | egrep 'webapp|catalog'

catalog.istioinaction.svc.cluster.local 80 - outbound EDS

webapp.istioinaction.svc.cluster.local 80 - outbound EDS

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/istio-ingressgateway.istio-system --fqdn webapp.istioinaction.svc.cluster.local -o json

...

"name": "outbound|80||webapp.istioinaction.svc.cluster.local",

"type": "EDS",

...

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/istio-ingressgateway.istio-system --cluster 'outbound|80||webapp.istioinaction.svc.cluster.local'

ENDPOINT STATUS OUTLIER CHECK CLUSTER

10.10.0.28:8080 HEALTHY OK outbound|80||webapp.istioinaction.svc.cluster.local

# proxy-config : webapp

docker exec -it myk8s-control-plane istioctl proxy-config listener deploy/webapp.istioinaction

...

## 80번 포트에서 HTTP/1.1, h2c 트래픽 수신

## raw_buffer: TLS 종료 없이 평문 통신 사용

## webapp의 아웃바운드 트래픽이 암호화되지 않은 상태로 catalog로 전송

0.0.0.0 80 Trans: raw_buffer; App: http/1.1,h2c Route: 80

...

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/webapp.istioinaction

...

## 모든 경로(/*)에 대해 기본 라우팅 적용

## VS 미설정 상태

80 webapp, webapp.istioinaction + 1 more... /*

...

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/webapp.istioinaction

...

## 클러스터 포트 80

catalog.istioinaction.svc.cluster.local 80 - outbound EDS

...

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/webapp.istioinaction

...

## 2개의 정상 파드에 로드밸런싱

## 서비스의 80포트 -> 파드의 30000포트

10.10.0.21:3000 HEALTHY OK outbound|80||catalog.istioinaction.svc.cluster.local

10.10.0.27:3000 HEALTHY OK outbound|80||catalog.istioinaction.svc.cluster.local

...

# proxy-config : catalog

docker exec -it myk8s-control-plane istioctl proxy-config listener deploy/catalog.istioinaction

...

## 3000번 포트에서 HTTP 트래픽 수신

0.0.0.0 15006 Trans: tls; App: istio-http/1.0,istio-http/1.1,istio-h2; Addr: 0.0.0.0/0 InboundPassthroughClusterIpv4

...

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/catalog.istioinaction

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/catalog.istioinaction

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/catalog.istioinaction

# webapp istio-proxy 로그 활성화

# 신규 터미널

kubectl logs -n istioinaction -l app=webapp -c istio-proxy -f

# webapp istio-proxy 로그 활성화 적용

cat << EOF | kubectl apply -f -

apiVersion: telemetry.istio.io/v1alpha1

kind: Telemetry

metadata:

name: webapp

namespace: istioinaction

spec:

selector:

matchLabels:

app: webapp

accessLogging:

- providers:

- name: envoy #2 액세스 로그를 위한 프로바이더 설정

disabled: false #3 disable 를 false 로 설정해 활성화한다

EOF

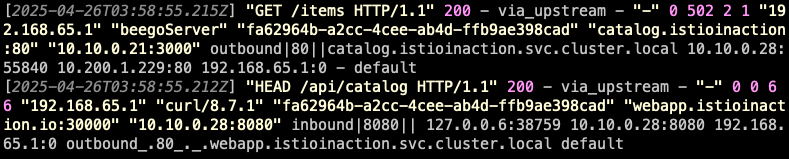

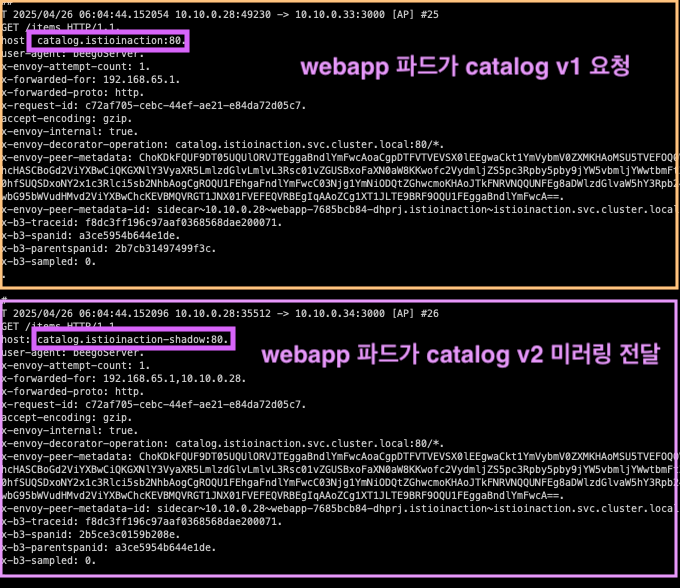

# webapp → catalog 는 k8s service(clusterIP) 라우팅 사용 확인!

kubectl logs -n istioinaction -l app=webapp -c istio-proxy -f

/items

webapp 서비스가 catalog 서비스로 HTTP 요청을 보냄

Envoy는 catalog.istioinaction이라는 k8s catalog 서비스(clusterIP 10.200.1.299:80)로 라우팅하고, 실제 Pod IP는 10.10.0.21:3000으로 연결됨

/api/catalog

이 로그는 webapp 서비스의 사이드카 클라이언트로부터 직접 HTTP 요청을 받음

이 요청을 10.10.0.28:8080(webapp 서비스의 실제 컨테이너)으로 보냄

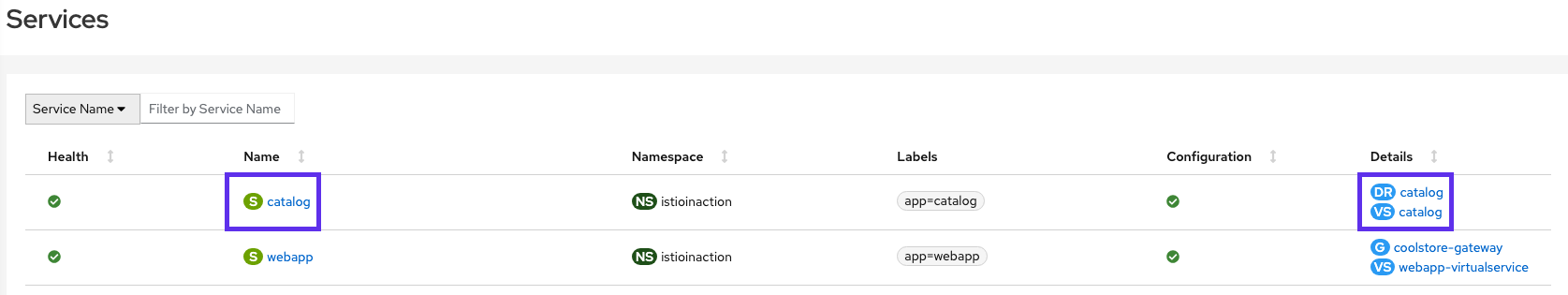

- catalog의 v1으로 모든 트래픽을을 라우팅하는 VS,DR 생성

cat ch5/catalog-dest-rule.yaml

apiVersion: networking.istio.io/v1alpha3

kind: DestinationRule

metadata:

name: catalog

spec:

host: catalog.istioinaction.svc.cluster.local

subsets:

- name: version-v1

labels:

version: v1

- name: version-v2

labels:

version: v2

kubectl apply -f ch5/catalog-dest-rule.yaml -n istioinaction

# istio-proxy

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/istio-ingressgateway.istio-system --fqdn catalog.istioinaction.svc.cluster.local

SERVICE FQDN PORT SUBSET DIRECTION TYPE DESTINATION RULE

catalog.istioinaction.svc.cluster.local 80 - outbound EDS catalog.istioinaction

catalog.istioinaction.svc.cluster.local 80 version-v1 outbound EDS catalog.istioinaction

catalog.istioinaction.svc.cluster.local 80 version-v2 outbound EDS catalog.istioinaction

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/istio-ingressgateway.istio-system | egrep 'ENDPOINT|istioinaction'

ENDPOINT STATUS OUTLIER CHECK CLUSTER

10.10.0.16:3000 HEALTHY OK outbound|80|version-v1|catalog.istioinaction.svc.cluster.local

10.10.0.16:3000 HEALTHY OK outbound|80||catalog.istioinaction.svc.cluster.local

10.10.0.17:3000 HEALTHY OK outbound|80|version-v2|catalog.istioinaction.svc.cluster.local

10.10.0.17:3000 HEALTHY OK outbound|80||catalog.istioinaction.svc.cluster.local

10.10.0.18:8080 HEALTHY OK outbound|80||webapp.istioinaction.svc.cluster.local

cat ch5/catalog-vs-v1-mesh.yaml

apiVersion: networking.istio.io/v1alpha3

kind: VirtualService

metadata:

name: catalog

spec:

hosts:

- catalog

gateways: # 만약, gateways 부분을 제외하고 배포하면 암묵적으로 mesh gateways가 적용됨.

- mesh # VirtualService는 메시 내의 모든 사이드카(현재 webapp, catalog)에 적용된다. edge는 제외.

http:

- route:

- destination:

host: catalog

subset: version-v1

kubectl apply -f ch5/catalog-vs-v1-mesh.yaml -n istioinaction

# VirtualService 확인 : GATEWAYS 에 mesh 확인

kubectl get vs -n istioinaction

NAME GATEWAYS HOSTS AGE

catalog ["mesh"] ["catalog"] 12s

webapp-virtualservice ["coolstore-gateway"] ["webapp.istioinaction.io"] 28s

# 반복 호출테스트 : 신규터미널 2개에 아래 각각 실행 해두기 >> 현재는 v1만 라우팅 처리

while true; do curl -s http://webapp.istioinaction.io:30000/api/catalog -I | head -n 1 ; date "+%Y-%m-%d %H:%M:%S" ; sleep 1; echo; done

while true; do curl -s http://webapp.istioinaction.io:30000/api/catalog -H "x-istio-cohort: internal" -I | head -n 1 ; date "+%Y-%m-%d %H:%M:%S" ; sleep 2; echo; done

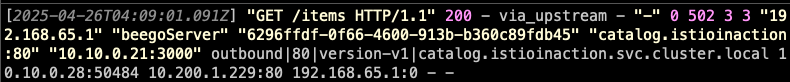

# webapp → catalog 호출도 istio 의 DestinationRule 라우팅 전달 처리! : 신규터미널

kubectl logs -n istioinaction -l app=webapp -c istio-proxy -f

이 로그는 webapp이 내부적으로 catalog 서비스를 호출하는 로그 version-v1이라는 subset으로 요청이 라우팅 됨 이는 DR에서

subset: version-v1으로 정의된 엔드포인트로 라우팅이 잘 되었다는 의미

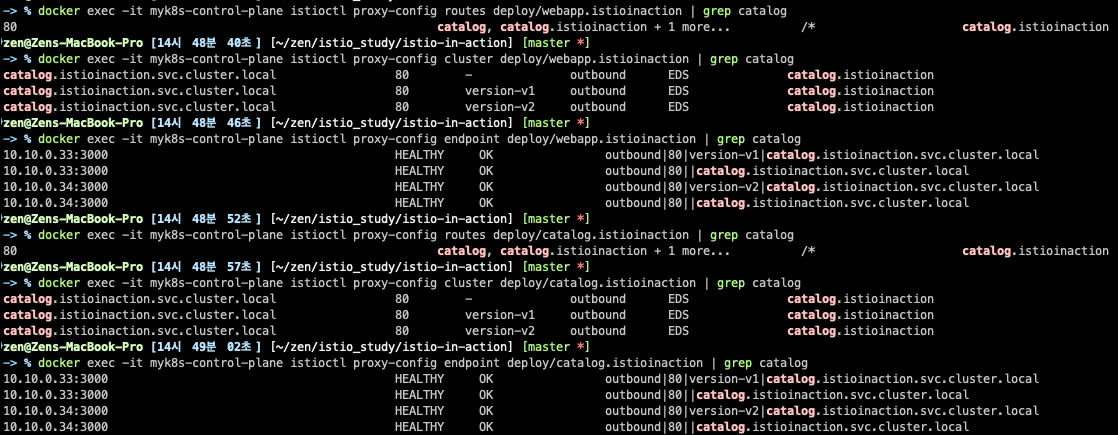

# proxy-config (webapp) : 기존에 webapp 에서 catalog 로 VirtualService 정보는 없었는데, 추가됨을 확인

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/webapp.istioinaction | egrep 'NAME|catalog'

NAME DOMAINS MATCH VIRTUAL SERVICE

80 catalog, catalog.istioinaction + 1 more... /* catalog.istioinaction

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/webapp.istioinaction --name 80 -o json > webapp-routes.json

cat webapp-routes.json | jq

...

"virtualHosts": [

{

"name": "catalog.istioinaction.svc.cluster.local:80",

"domains": [

"catalog.istioinaction.svc.cluster.local",

"catalog",

"catalog.istioinaction.svc",

"catalog.istioinaction",

"10.200.1.254" # 해당 IP는 catalog service(clusterIP)

],

"routes": [

{

"match": {

"prefix": "/"

},

"route": {

"cluster": "outbound|80|version-v1|catalog.istioinaction.svc.cluster.local",

"timeout": "0s",

...

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/webapp.istioinaction --fqdn catalog.istioinaction.svc.cluster.local

SERVICE FQDN PORT SUBSET DIRECTION TYPE DESTINATION RULE

catalog.istioinaction.svc.cluster.local 80 - outbound EDS catalog.istioinaction

catalog.istioinaction.svc.cluster.local 80 version-v1 outbound EDS catalog.istioinaction

catalog.istioinaction.svc.cluster.local 80 version-v2 outbound EDS catalog.istioinaction

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/webapp.istioinaction --subset version-v1 -o json

...

"name": "outbound|80|version-v1|catalog.istioinaction.svc.cluster.local",

"type": "EDS",

...

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/webapp.istioinaction | egrep 'ENDPOINT|catalog'

ENDPOINT STATUS OUTLIER CHECK CLUSTER

10.10.0.16:3000 HEALTHY OK outbound|80|version-v1|catalog.istioinaction.svc.cluster.local

10.10.0.16:3000 HEALTHY OK outbound|80||catalog.istioinaction.svc.cluster.local

10.10.0.17:3000 HEALTHY OK outbound|80|version-v2|catalog.istioinaction.svc.cluster.local

10.10.0.17:3000 HEALTHY OK outbound|80||catalog.istioinaction.svc.cluster.local

# proxy-config (catalog) : gateway.mesh 이므로, 메시 내에 모든 사이드카에 VirtualService 적용됨을 확인. 아래 routes 부분

docker exec -it myk8s-control-plane istioctl proxy-config listener deploy/catalog.istioinaction

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/catalog.istioinaction | egrep 'NAME|catalog'

NAME DOMAINS MATCH VIRTUAL SERVICE

80 catalog, catalog.istioinaction + 1 more... /* catalog.istioinaction

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/catalog.istioinaction

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/catalog.istioinaction

cat ch5/catalog-vs-v2-request-mesh.yaml

apiVersion: networking.istio.io/v1alpha3

kind: VirtualService

metadata:

name: catalog

spec:

hosts:

- catalog

gateways:

- mesh

http:

- match:

- headers:

x-istio-cohort:

exact: "internal"

route:

- destination:

host: catalog

subset: version-v2

- route:

- destination:

host: catalog

subset: version-v1

kubectl apply -f ch5/catalog-vs-v2-request-mesh.yaml -n istioinaction

# 반복 호출테스트 : 신규터미널 2개에 아래 각각 실행 >> v1, v2 각기 라우팅 확인

while true; do curl -s http://webapp.istioinaction.io:30000/api/catalog -I | head -n 1 ; date "+%Y-%m-%d %H:%M:%S" ; sleep 1; echo; done

while true; do curl -s http://webapp.istioinaction.io:30000/api/catalog -H "x-istio-cohort: internal" -I | head -n 1 ; date "+%Y-%m-%d %H:%M:%S" ; sleep 2; echo; done

# proxy-config (webapp) : 기존에 webapp 에서 catalog 로 VirtualService 추가된 2개 항목 확인

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/webapp.istioinaction | egrep 'NAME|catalog'

NAME DOMAINS MATCH VIRTUAL SERVICE

80 catalog, catalog.istioinaction + 1 more... /* catalog.istioinaction

80 catalog, catalog.istioinaction + 1 more... /* catalog.istioinaction

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/webapp.istioinaction --name 80 -o json > webapp-routes.json

cat webapp-routes.json | jq

...

"virtualHosts": [

{

"name": "catalog.istioinaction.svc.cluster.local:80",

"domains": [

"catalog.istioinaction.svc.cluster.local",

"catalog",

"catalog.istioinaction.svc",

"catalog.istioinaction",

"10.200.1.254"

],

"routes": [

{

"match": {

"prefix": "/",

"caseSensitive": true,

"headers": [

{

"name": "x-istio-cohort",

"stringMatch": {

"exact": "internal"

}

}

]

},

"route": {

"cluster": "outbound|80|version-v2|catalog.istioinaction.svc.cluster.local",

....

{

"match": {

"prefix": "/"

},

"route": {

"cluster": "outbound|80|version-v1|catalog.istioinaction.svc.cluster.local",

...

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/webapp.istioinaction --fqdn catalog.istioinaction.svc.cluster.local

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/webapp.istioinaction | egrep 'ENDPOINT|catalog'

# proxy-config (catalog) : mesh 이므로 VS가 아래 routes(catalog)에도 적용됨

docker exec -it myk8s-control-plane istioctl proxy-config listener deploy/catalog.istioinaction

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/catalog.istioinaction

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/catalog.istioinaction

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/catalog.istioinaction

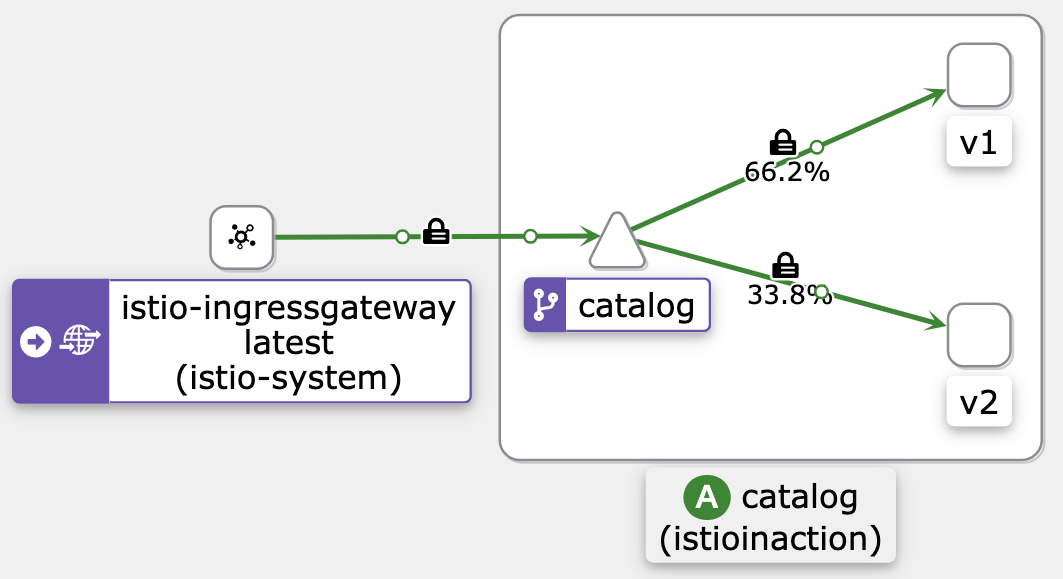

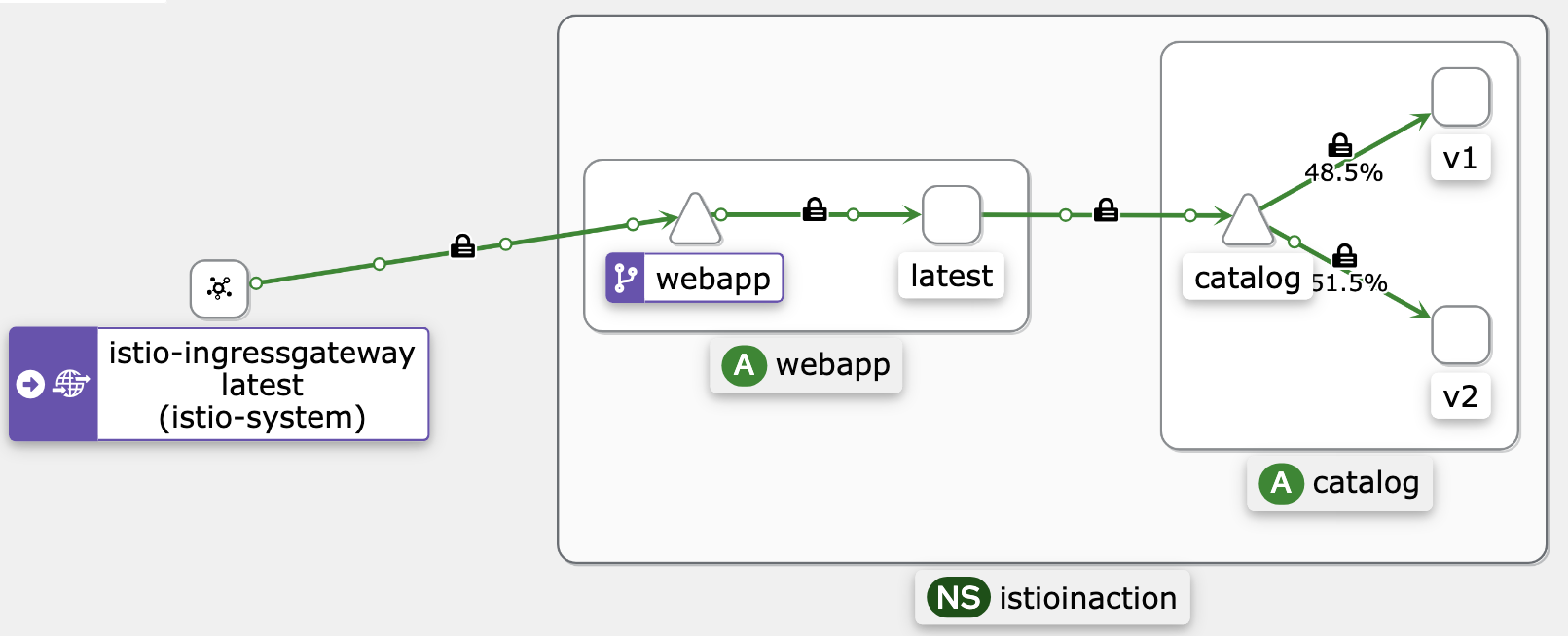

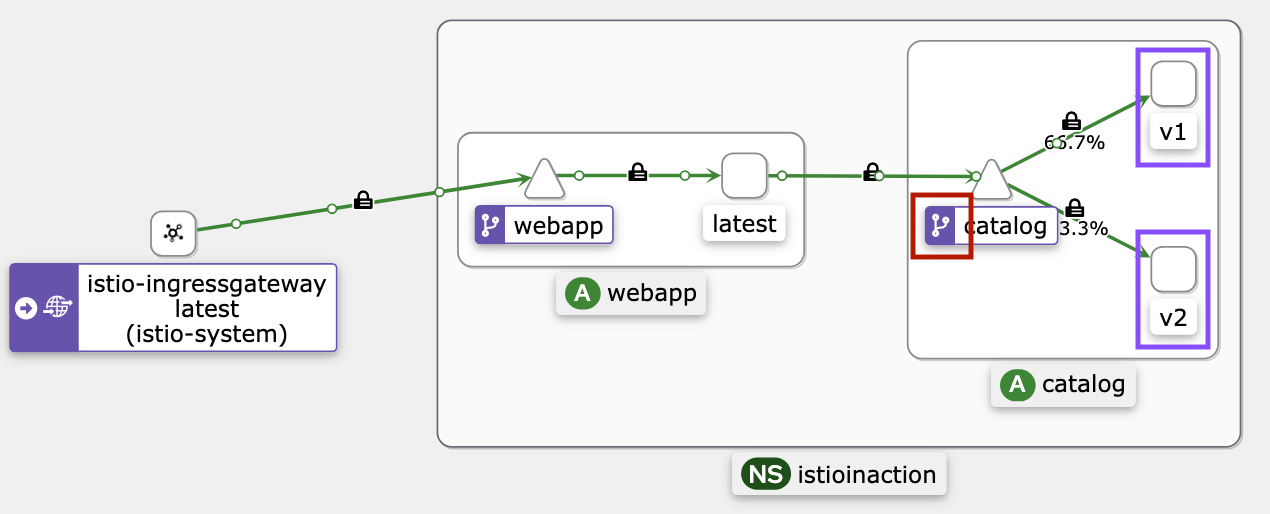

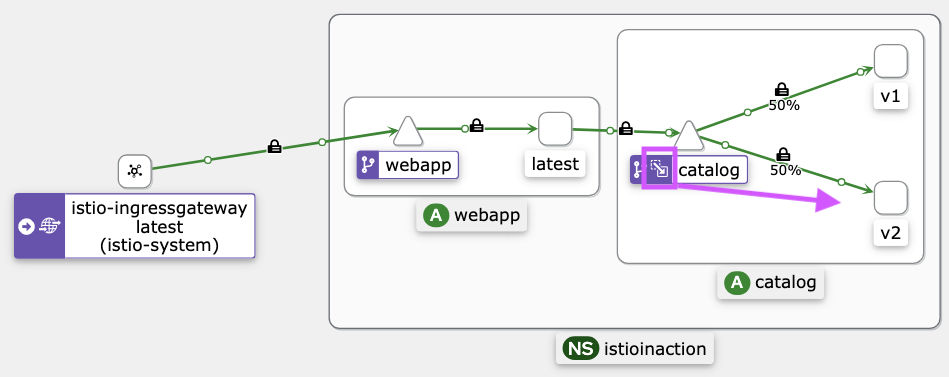

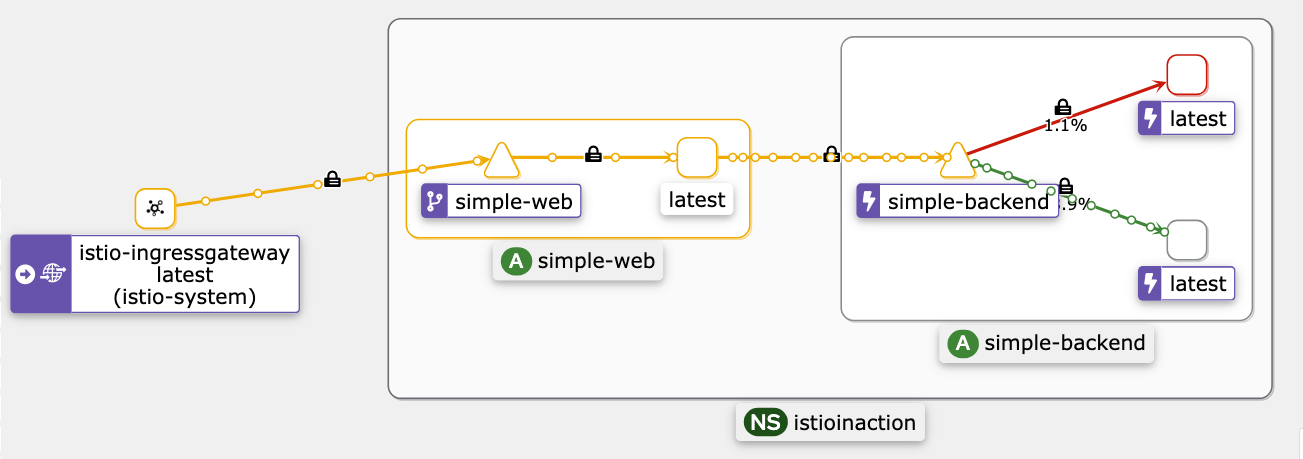

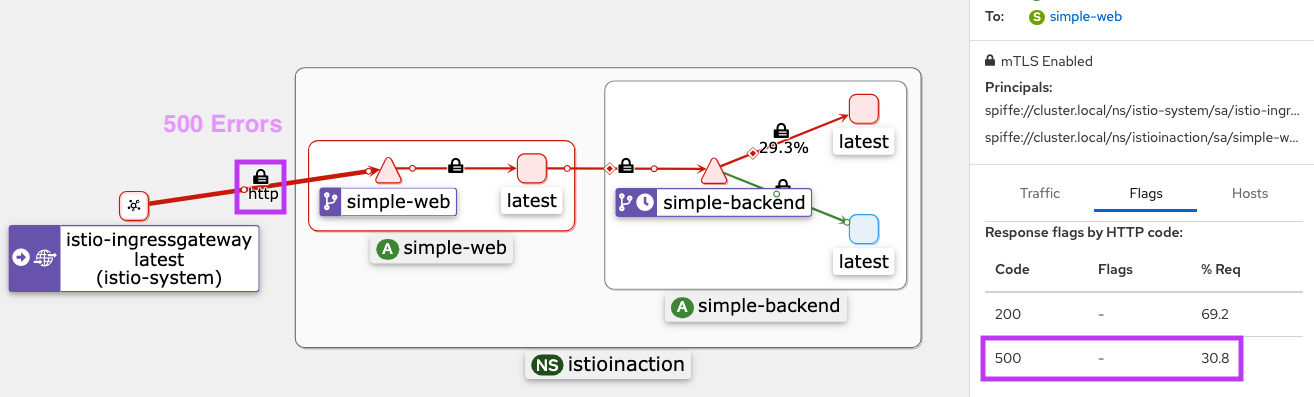

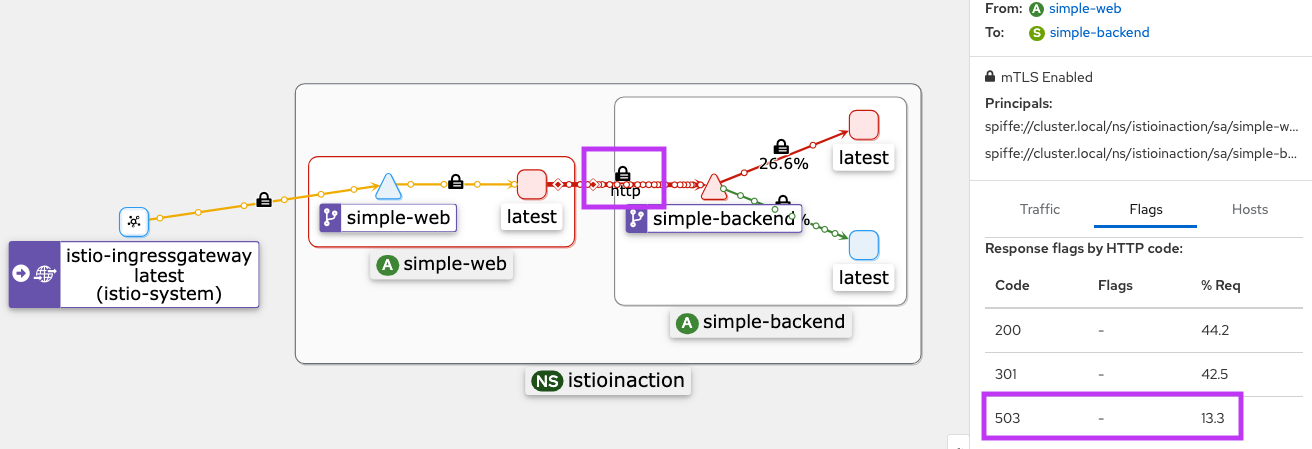

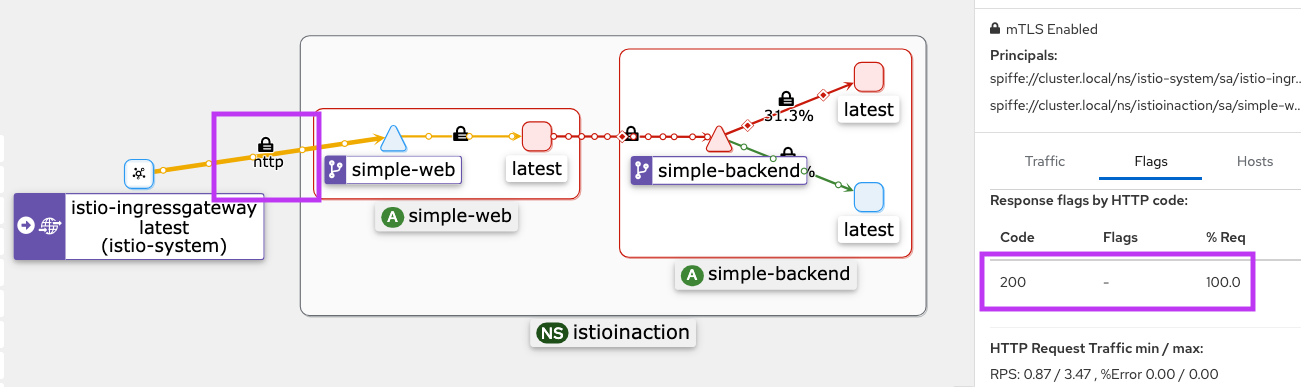

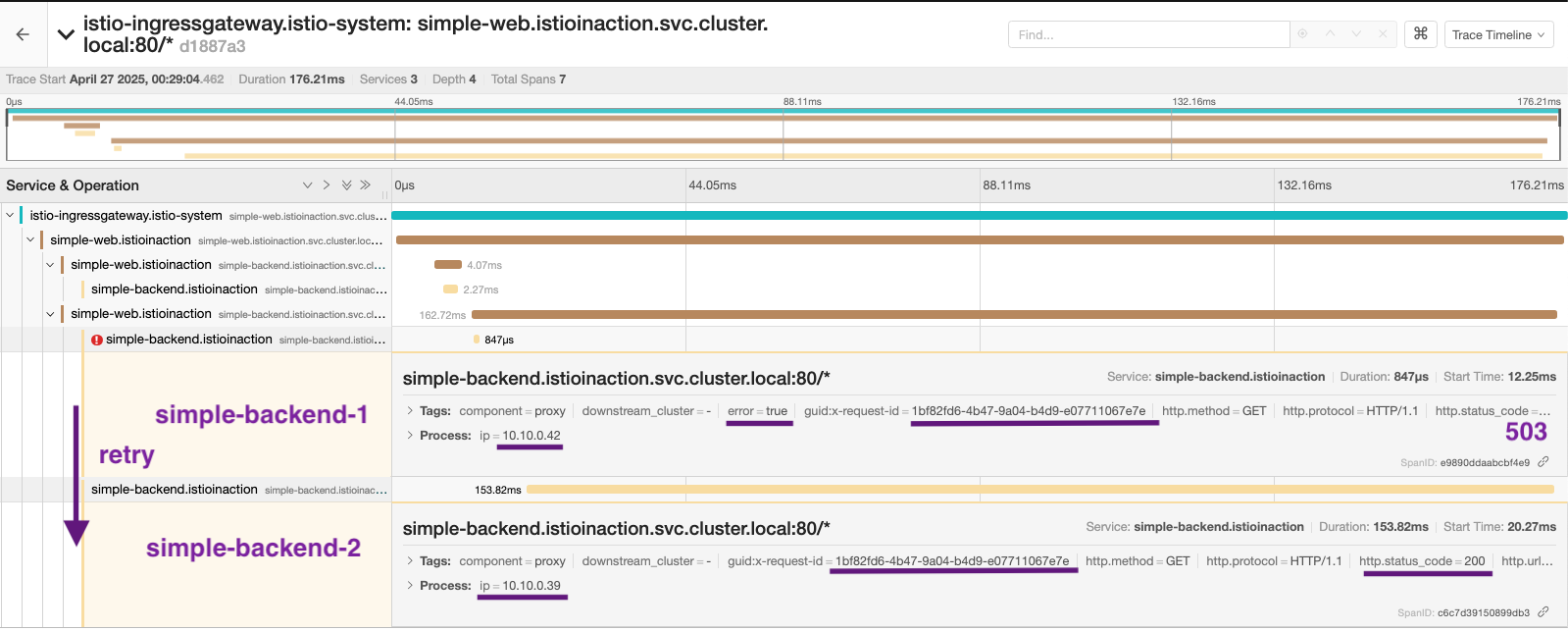

트래픽 전환

트래픽의 일부만 신버전(v2)으로 보내면서 점진적으로 배포를 확장하는 카나리 릴리스를 구현한다.

실습전 트래픽 초기화

# 반복 호출테스트 : 신규터미널

while true; do curl -s http://webapp.istioinaction.io:30000/api/catalog ; date "+%Y-%m-%d %H:%M:%S" ; sleep 1; echo; done

# 모든 트래픽을 catalog service v1 으로 재설정

cat ch5/catalog-vs-v1-mesh.yaml

...

http:

- route:

- destination:

host: catalog

subset: version-v1

kubectl apply -f ch5/catalog-vs-v1-mesh.yaml -n istioinaction

# 호출테스트

curl -s http://webapp.istioinaction.io:30000/api/catalog | jq

트래픽 10%만 v2로 보내기

cat ch5/catalog-vs-v2-10-90-mesh.yaml

apiVersion: networking.istio.io/v1alpha3

kind: VirtualService

metadata:

name: catalog

spec:

hosts:

- catalog

gateways:

- mesh

http:

- route:

- destination:

host: catalog

subset: version-v1

weight: 90

- destination:

host: catalog

subset: version-v2

weight: 10

kubectl apply -f ch5/catalog-vs-v2-10-90-mesh.yaml -n istioinaction

kubectl get vs -n istioinaction catalog

NAME GATEWAYS HOSTS AGE

catalog ["mesh"] ["catalog"] 112s

# 호출 테스트 : v2 호출 비중 확인

for i in {1..10}; do curl -s http://webapp.istioinaction.io:30000/api/catalog | grep -i imageUrl ; done | wc -l

for i in {1..100}; do curl -s http://webapp.istioinaction.io:30000/api/catalog | grep -i imageUrl ; done | wc -l

# proxy-config(webapp) : mesh 이므로 메시 내 모든 사이드카에 VS 적용

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/webapp.istioinaction --name 80 -o json

...

"route": {

"weightedClusters": {

"clusters": [

{

"name": "outbound|80|version-v1|catalog.istioinaction.svc.cluster.local",

"weight": 90

},

{

"name": "outbound|80|version-v2|catalog.istioinaction.svc.cluster.local",

"weight": 10

}

],

"totalWeight": 100

...

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/webapp.istioinaction --fqdn catalog.istioinaction.svc.cluster.local

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/webapp.istioinaction | grep catalog

# proxy-config(catalog) : mesh 이므로 메시 내 모든 사이드카에 VS 적용

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/catalog.istioinaction --name 80 -o json

...

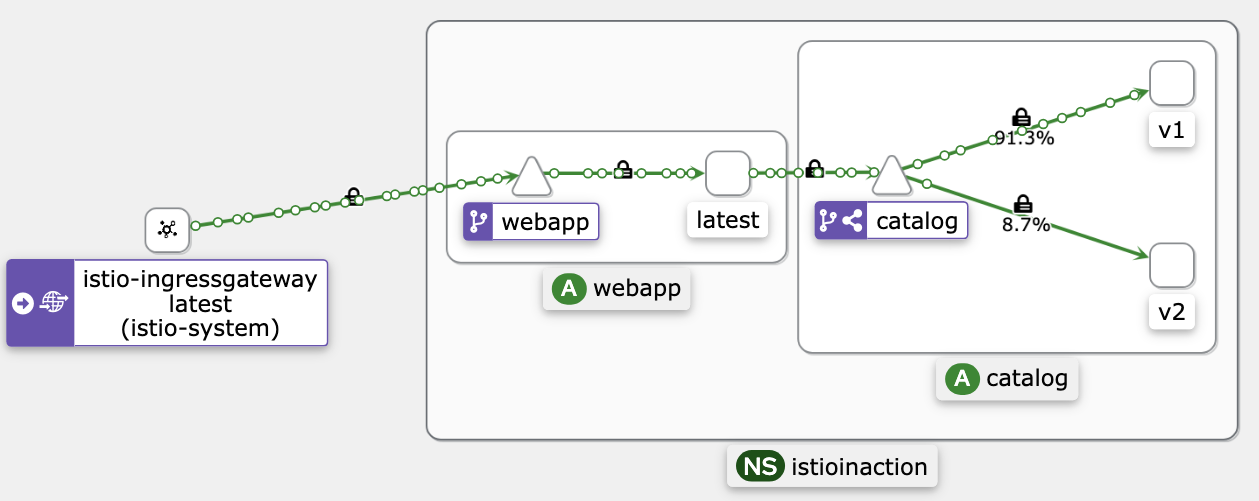

트래픽을 50:50으로 분할

cat ch5/catalog-vs-v2-50-50-mesh.yaml

apiVersion: networking.istio.io/v1alpha3

kind: VirtualService

metadata:

name: catalog

spec:

hosts:

- catalog

gateways:

- mesh

http:

- route:

- destination:

host: catalog

subset: version-v1

weight: 50

- destination:

host: catalog

subset: version-v2

weight: 50

kubectl apply -f ch5/catalog-vs-v2-50-50-mesh.yaml -n istioinaction

# 호출 테스트 : v2 호출 비중 확인

for i in {1..10}; do curl -s http://webapp.istioinaction.io:30000/api/catalog | grep -i imageUrl ; done | wc -l

for i in {1..100}; do curl -s http://webapp.istioinaction.io:30000/api/catalog | grep -i imageUrl ; done | wc -l

# proxy-config(webapp)

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/webapp.istioinaction --name 80 -o json

...

"route": {

"weightedClusters": {

"clusters": [

{

"name": "outbound|80|version-v1|catalog.istioinaction.svc.cluster.local",

"weight": 50

},

{

"name": "outbound|80|version-v2|catalog.istioinaction.svc.cluster.local",

"weight": 50

}

],

"totalWeight": 100

...

소프트웨어 새 버전을 천천히 출시할 때는 구 버전과 신 버전을 모두 모니터링하고 관찰해 안정성, 성능, 정확성 등을 확인해야 한다. 문제 발견시 가중치를 변경하여 구 버전으로 쉽게 롤백이 가능하다. 이 방식은 여러 버전을 동시에 실행할 수 있도록 서비스를 구축해야 한다. 서비스가 더 많은 상태를 갖을수록(심지어 외부에 의존하더라도) 이런 작업은 더 어려워진다. —

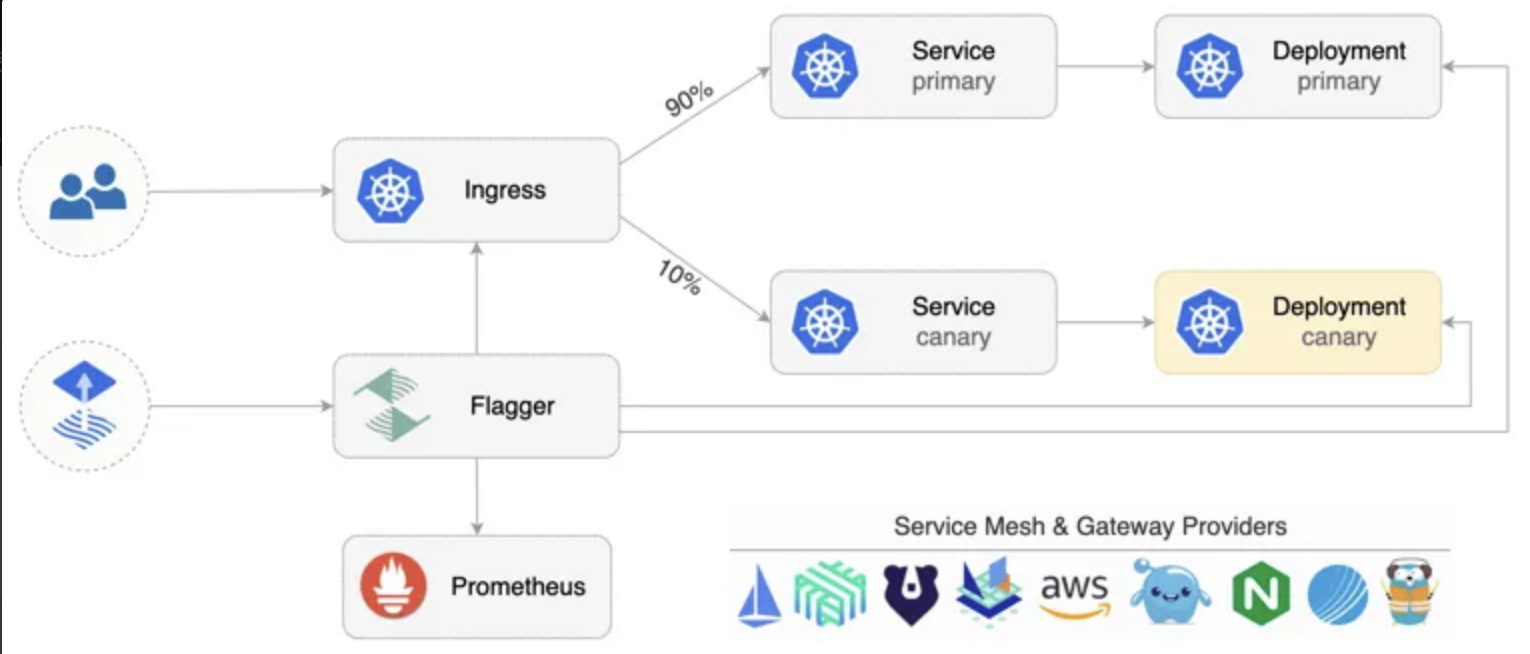

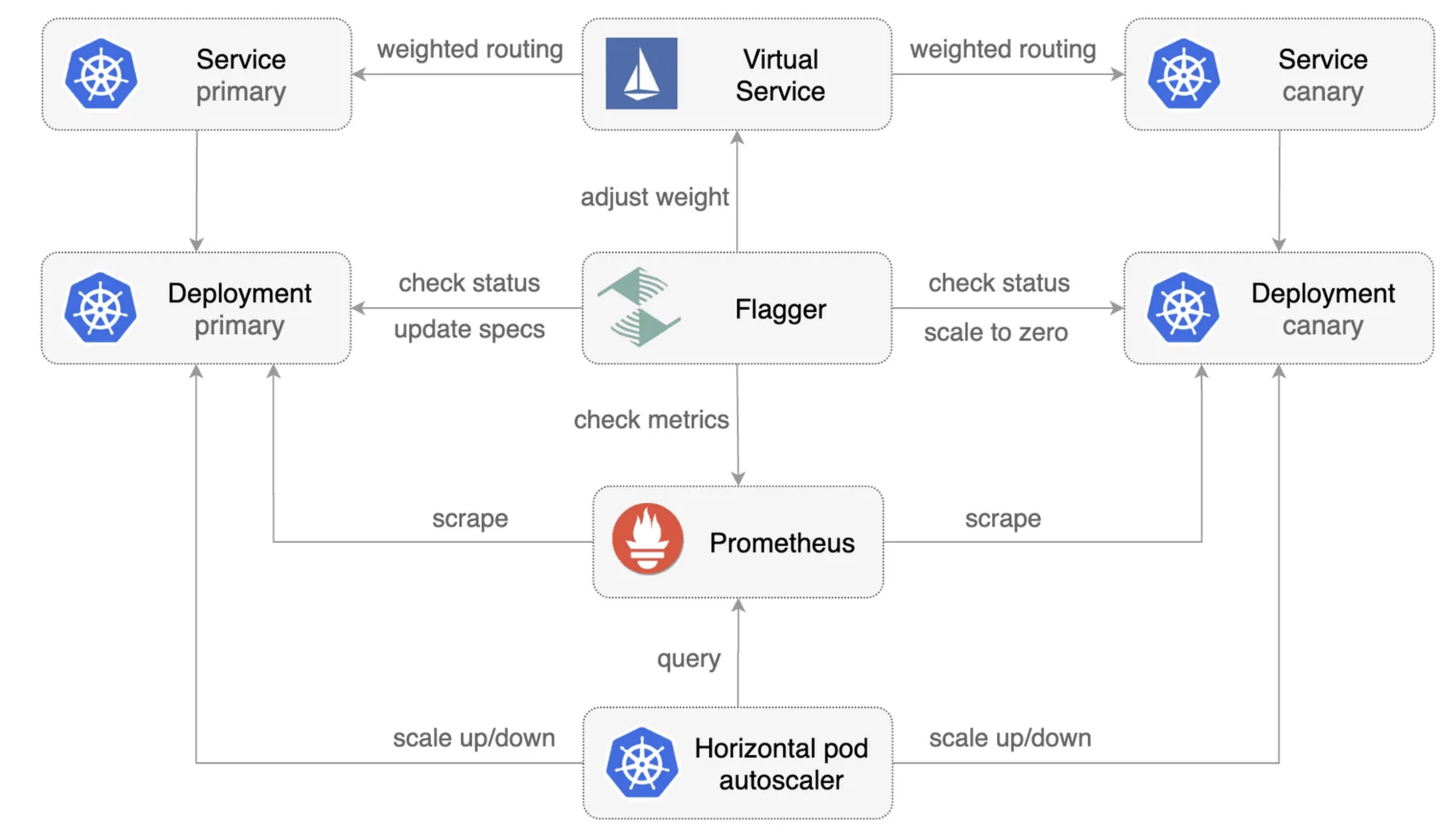

Flagger로 카나리 릴리스 자동화

Flagger는 트래픽 전환을 수동으로 하지 않고, 메트릭 기반으로 자동화하는 도구다. 성공률이나 지연 시간 기준으로 릴리스를 진행하거나 롤백할 수 있다.

Flagger 설치 및 설정

# catalog-v2 와 트래픽 라우팅을 명시적으로 제어하는 VirtualService를 제거

kubectl delete virtualservice catalog -n istioinaction

kubectl delete deploy catalog-v2 -n istioinaction

kubectl delete service catalog -n istioinaction

kubectl delete destinationrule catalog -n istioinaction

# 남은 리소스 확인

kubectl get deploy,svc,ep -n istioinaction

NAME READY UP-TO-DATE AVAILABLE AGE

deployment.apps/catalog 1/1 1 1 77m

deployment.apps/webapp 1/1 1 1 78m

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

service/webapp ClusterIP 10.200.1.73 <none> 80/TCP 78m

NAME ENDPOINTS AGE

endpoints/webapp 10.10.0.19:8080 78m

kubectl get gw,vs -n istioinaction

NAME AGE

gateway.networking.istio.io/coolstore-gateway 73m

NAME GATEWAYS HOSTS AGE

virtualservice.networking.istio.io/webapp-virtualservice ["coolstore-gateway"] ["webapp.istioinaction.io"] 73m

- helm을 사용하여 Flagger를 설치

# CRD 설치

kubectl apply -f https://raw.githubusercontent.com/fluxcd/flagger/main/artifacts/flagger/crd.yaml

kubectl get crd | grep flagger

alertproviders.flagger.app 2025-04-26T04:49:32Z

canaries.flagger.app 2025-04-26T04:49:32Z

metrictemplates.flagger.app 2025-04-26T04:49:32Z

# Helm 설치

helm repo add flagger https://flagger.app

helm install flagger flagger/flagger \

--namespace=istio-system \

--set crd.create=false \

--set meshProvider=istio \

--set metricServer=http://prometheus:9090

# 디플로이먼트 flagger 에 의해 배포된 파드 확인

kubectl get pod -n istio-system -l app.kubernetes.io/name=flagger

NAME READY STATUS RESTARTS AGE

flagger-6d4ffc5576-nvx5g 1/1 Running 0 22s

# 시크릿

kubectl get secret -n istio-system | grep flagger-token

flagger-token-gwqtv kubernetes.io/service-account-token 3 58s

# 시크릿 확인 : ca.crt 는 k8s 루프 인증서

kubectl view-secret -n istio-system flagger-token-gwqtv --all

ca.crt='-----BEGIN CERTIFICATE-----

...

-----END CERTIFICATE-----

'

namespace='istio-system'

token='...'

# token 을 jtw.io 에서 Decoded 확인

{

"iss": "kubernetes/serviceaccount",

"kubernetes.io/serviceaccount/namespace": "istio-system",

"kubernetes.io/serviceaccount/secret.name": "flagger-token-gwqtv",

"kubernetes.io/serviceaccount/service-account.name": "flagger",

"kubernetes.io/serviceaccount/service-account.uid": "f793713c-4dc6-41d9-aed4-1cd97eeef074",

"sub": "system:serviceaccount:istio-system:flagger"

}

Flagger Canary 리소스 생성

- 45초마다 트래픽 상태 평가

- 10%씩 트래픽 비율 증가

- 최대 50%까지 증가 후 전체로 전환

- 성공률 99% 이상, P99 지연 시간 500ms 이하 기준 유지

- 기준 미달 5회 발생 시 자동 롤백

cat ch5/flagger/catalog-release.yaml

apiVersion: flagger.app/v1beta1

kind: Canary

metadata:

name: catalog-release

namespace: istioinaction

spec:

targetRef: #1 카나리 대상 디플로이먼트 https://docs.flagger.app/usage/how-it-works#canary-target

apiVersion: apps/v1

kind: Deployment

name: catalog

progressDeadlineSeconds: 60

# Service / VirtualService Config

service: #2 서비스용 설정 https://docs.flagger.app/usage/how-it-works#canary-service

name: catalog

port: 80

targetPort: 3000

gateways:

- mesh

hosts:

- catalog

analysis: #3 카니리 진행 파라미터 https://docs.flagger.app/usage/how-it-works#canary-analysis

interval: 45s

threshold: 5

maxWeight: 50

stepWeight: 10

match:

- sourceLabels:

app: webapp

metrics: # https://docs.flagger.app/usage/metrics , https://docs.flagger.app/faq#metrics

- name: request-success-rate # built-in metric 요청 성공률

thresholdRange:

min: 99

interval: 1m

- name: request-duration # built-in metric 요청 시간

thresholdRange:

max: 500

interval: 30s

# 반복 호출테스트 : 신규터미널

while true; do curl -s http://webapp.istioinaction.io:30000/api/catalog -I | head -n 1 ; date "+%Y-%m-%d %H:%M:%S" ; sleep 1; echo; done

# flagger (operator) 가 catalog를 위한 canary 배포환경을 구성

kubectl apply -f ch5/flagger/catalog-release.yaml -n istioinaction

# flagger 로그 확인 : Service, Deployment, VirtualService 등을 설치하는 것을 확인할 수 있습니다.

kubectl logs -f deploy/flagger -n istio-system

...

# 확인

kubectl get canary -n istioinaction -w

NAME STATUS WEIGHT LASTTRANSITIONTIME

catalog-release Initializing 0 2025-04-19T05:10:00Z

catalog-release Initialized 0 2025-04-19T05:15:54Z

kubectl get canary -n istioinaction -owide

NAME STATUS WEIGHT SUSPENDED FAILEDCHECKS INTERVAL MIRROR STEPWEIGHT STEPWEIGHTS MAXWEIGHT LASTTRANSITIONTIME

catalog-release Initialized 0 0 45s 10 50 2025-04-19T05:15:54Z

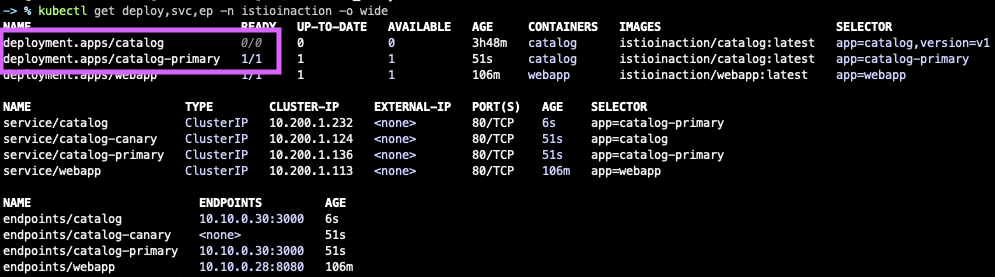

# flagger Initialized 동작 확인

## catalog-primary deployment/service 가 생성되어 있음, 기존 catalog deploy/service 는 파드가 0으로 됨

kubectl get deploy,svc,ep -n istioinaction -o wide

## VS catalog 생성되었음

kubectl get gw,vs -n istioinaction

NAME AGE

gateway.networking.istio.io/coolstore-gateway 137m

NAME GATEWAYS HOSTS AGE

virtualservice.networking.istio.io/catalog ["mesh"] ["catalog"] 8m17s

virtualservice.networking.istio.io/webapp-virtualservice ["coolstore-gateway"] ["webapp.istioinaction.io"] 137m

## VS catalog 확인

kubectl get vs -n istioinaction catalog -o yaml | kubectl neat

apiVersion: networking.istio.io/v1beta1

kind: VirtualService

metadata:

annotations:

helm.toolkit.fluxcd.io/driftDetection: disabled

kustomize.toolkit.fluxcd.io/reconcile: disabled

name: catalog

namespace: istioinaction

spec:

gateways:

- mesh

hosts:

- catalog

http:

- match:

- sourceLabels:

app: webapp

route:

- destination:

host: catalog-primary

weight: 100

- destination:

host: catalog-canary

weight: 0

- route:

- destination:

host: catalog-primary

weight: 100

# destinationrule 확인

kubectl get destinationrule -n istioinaction

NAME HOST AGE

catalog-canary catalog-canary 2m51s

catalog-primary catalog-primary 2m51s

kubectl get destinationrule -n istioinaction catalog-primary -o yaml | kubectl neat

apiVersion: networking.istio.io/v1beta1

kind: DestinationRule

metadata:

name: catalog-primary

namespace: istioinaction

spec:

host: catalog-primary

kubectl get destinationrule -n istioinaction catalog-canary -o yaml | kubectl neat

apiVersion: networking.istio.io/v1beta1

kind: DestinationRule

metadata:

name: catalog-canary

namespace: istioinaction

spec:

host: catalog-canary

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/webapp.istioinaction --name 80 -o json

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/webapp.istioinaction --name 80

NAME DOMAINS MATCH VIRTUAL SERVICE

80 catalog-canary, catalog-canary.istioinaction + 1 more... /*

80 catalog-primary, catalog-primary.istioinaction + 1 more... /*

80 catalog, catalog.istioinaction + 1 more... /* catalog.istioinaction

...

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/webapp.istioinaction | egrep 'RULE|catalog'

SERVICE FQDN PORT SUBSET DIRECTION TYPE DESTINATION RULE

catalog-canary.istioinaction.svc.cluster.local 80 - outbound EDS catalog-canary.istioinaction

catalog-primary.istioinaction.svc.cluster.local 80 - outbound EDS catalog-primary.istioinaction

catalog.istioinaction.svc.cluster.local 80 - outbound EDS

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/webapp.istioinaction --fqdn catalog.istioinaction.svc.cluster.local -o json

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/webapp.istioinaction --fqdn catalog-primary.istioinaction.svc.cluster.local -o json

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/webapp.istioinaction --fqdn catalog-canary.istioinaction.svc.cluster.local -o json

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/webapp.istioinaction | grep catalog

10.10.0.30:3000 HEALTHY OK outbound|80||catalog-primary.istioinaction.svc.cluster.local

10.10.0.30:3000 HEALTHY OK outbound|80||catalog.istioinaction.svc.cluster.local

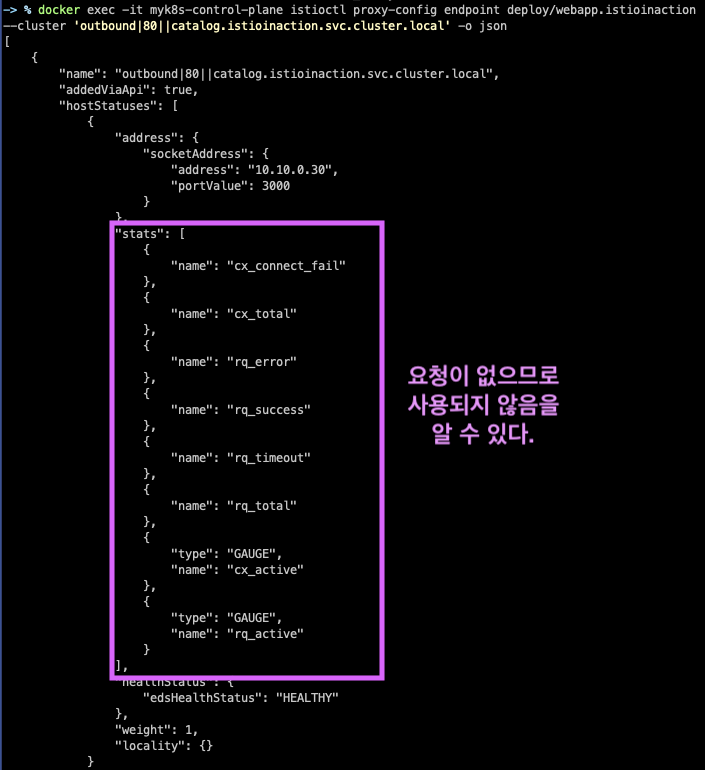

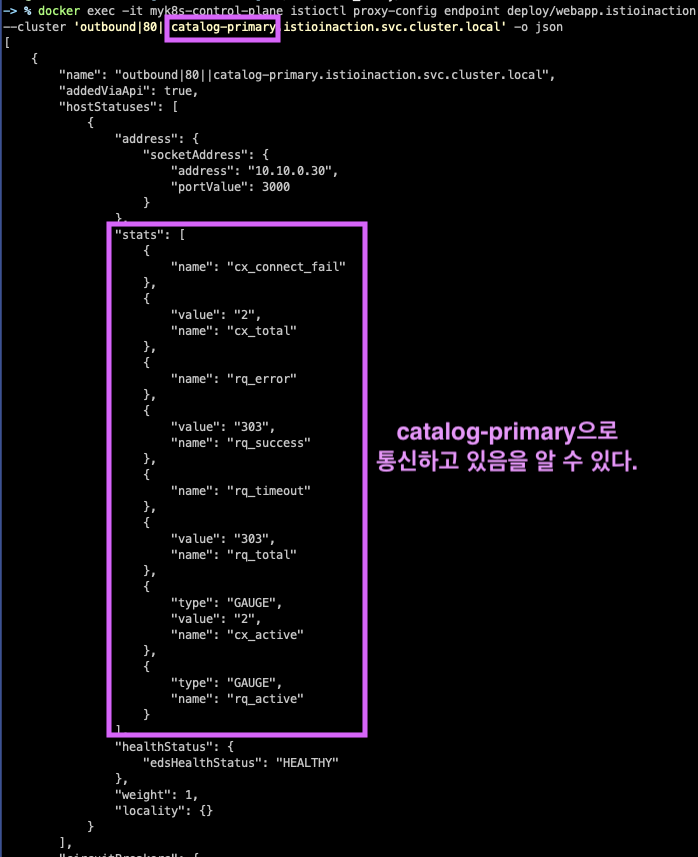

# 해당 EDS에 메트릭 통계 값 0.

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/webapp.istioinaction --cluster 'outbound|80||catalog.istioinaction.svc.cluster.local' -o json

...

# 현재 EDS primary 에 메트릭 통계 값 출력 중. 해당 EDS 호출.

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/webapp.istioinaction --cluster 'outbound|80||catalog-primary.istioinaction.svc.cluster.local' -o json

...

아직은 기본 설정만 하였고, 아직 실제 카나리는 수행하지 않았다.

flagger는 원본 디플로이먼트 대상의 변경사항을 지켜보고, 카나리 디플로이먼트 및 서비스를 생성하고, VS의 가중치를 조정한다.

# 반복 호출테스트 : 신규터미널1 - 부하 만들기

while true; do curl -s http://webapp.istioinaction.io:30000/api/catalog -I | head -n 1 ; date "+%Y-%m-%d %H:%M:%S" ; sleep 1; echo; done

# flagger 로그 확인 : 신규터미널2

kubectl logs -f deploy/flagger -n istio-system

# flagger 상태 확인 : 신규터미널3

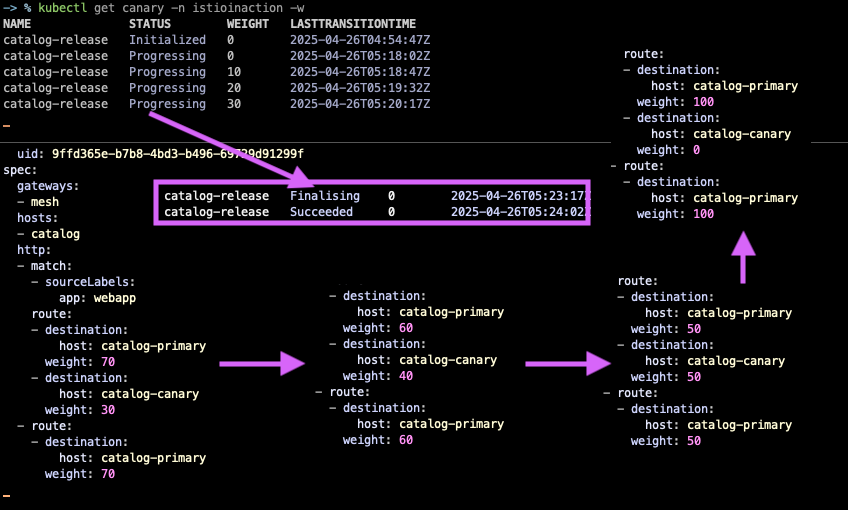

## 카나리는 Carary 오브젝트에 설정한 대로 45초마다 진행될 것이다.

## 트래픽의 50%가 카나리로 이동할 때까지는 단계별로 10%씩 증가한다.

## flagger가 메트릭에 문제가 없고 기준과 차이가 없다고 판단되면, 모든 트래픽이 카나리로 이동해 카나리가 기본 서비스로 승격 될 때까지 카나리가 진행된다.

## 만약 문제가 발생하면 flagger는 자동으로 카나리 릴리스를 롤백할 것이다.

kubectl get canary -n istioinaction -w

NAME STATUS WEIGHT LASTTRANSITIONTIME

catalog-release Initialized 0 2025-04-19T05:15:54Z

catalog-release Progressing 0 2025-04-19T06:09:09Z

catalog-release Progressing 10 2025-04-19T06:09:54Z # 45초 간격

catalog-release Progressing 20 2025-04-19T06:10:39Z

catalog-release Progressing 30 2025-04-19T06:11:24Z

catalog-release Progressing 40 2025-04-19T06:12:09Z

catalog-release Progressing 50 2025-04-19T06:12:54Z

catalog-release Promoting 0 2025-04-19T06:13:39Z

catalog-release Finalising 0 2025-04-19T06:14:24Z

catalog-release Succeeded 0 2025-04-19T06:15:09Z

# imageUrl 출력 (v2)을 포함하는 catalog deployment v2 배포

cat ch5/flagger/catalog-deployment-v2.yaml

apiVersion: apps/v1

kind: Deployment

metadata:

labels:

app: catalog

version: v1

name: catalog

spec:

replicas: 1

selector:

matchLabels:

app: catalog

version: v1

template:

metadata:

labels:

app: catalog

version: v1

spec:

containers:

- env:

- name: KUBERNETES_NAMESPACE

valueFrom:

fieldRef:

fieldPath: metadata.namespace

- name: SHOW_IMAGE

value: "true"

image: istioinaction/catalog:latest

imagePullPolicy: IfNotPresent

name: catalog

ports:

- containerPort: 3000

name: http

protocol: TCP

securityContext:

privileged: false

kubectl apply -f ch5/flagger/catalog-deployment-v2.yaml -n istioinaction

kubectl get vs -n istioinaction catalog -o yaml -w # catalog vs 에 가중치 변경 모니터링

# canary CRD 이벤트 확인

kubectl describe canary -n istioinaction catalog-release | grep Events: -A20

Events:

Type Reason Age From Message

---- ------ ---- ---- -------

Warning Synced 32m flagger catalog-primary.istioinaction not ready: waiting for rollout to finish: observed deployment generation less than desired generation

Normal Synced 32m (x2 over 32m) flagger all the metrics providers are available!

Normal Synced 32m flagger Initialization done! catalog-release.istioinaction

Normal Synced 8m57s flagger New revision detected! Scaling up catalog.istioinaction

Normal Synced 8m12s flagger Starting canary analysis for catalog.istioinaction

Normal Synced 8m12s flagger Advance catalog-release.istioinaction canary weight 10

Normal Synced 7m27s flagger Advance catalog-release.istioinaction canary weight 20

Normal Synced 6m42s flagger Advance catalog-release.istioinaction canary weight 30

Normal Synced 5m57s flagger Advance catalog-release.istioinaction canary weight 40

Normal Synced 5m12s flagger Advance catalog-release.istioinaction canary weight 50

Normal Synced 4m27s flagger Copying catalog.istioinaction template spec to catalog-primary.istioinaction

Normal Synced 3m42s flagger Routing all traffic to primary

Normal Synced 2m57s flagger (combined from similar events): Promotion completed! Scaling down catalog.istioinaction

# 최종 v2 접속 확인

for i in {1..100}; do curl -s http://webapp.istioinaction.io:30000/api/catalog | grep -i imageUrl ; done | wc -l

100

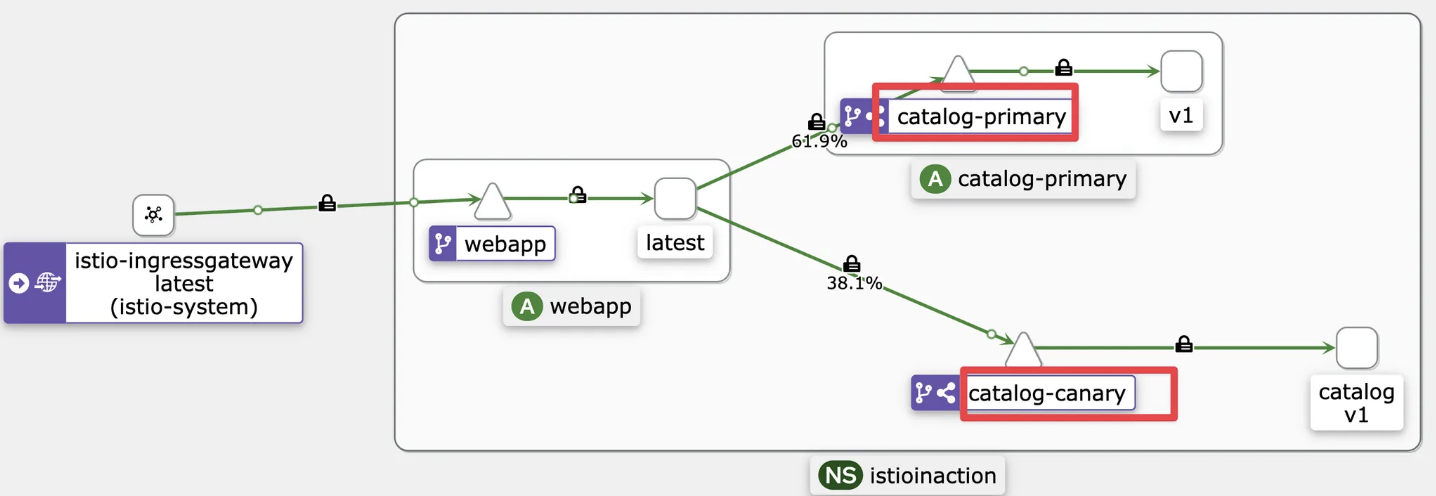

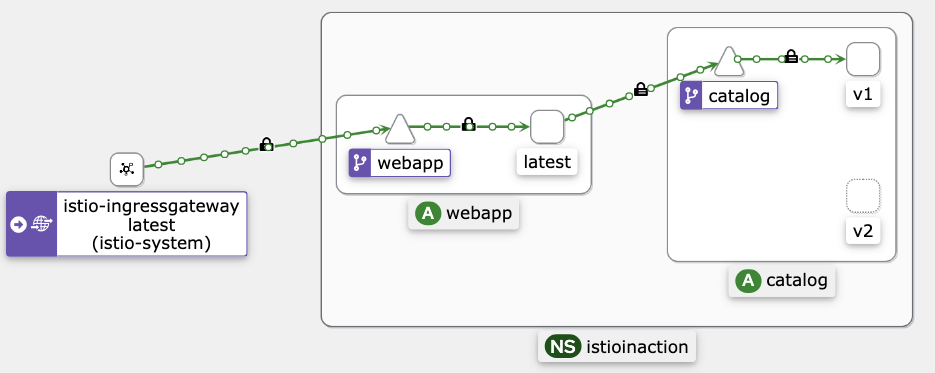

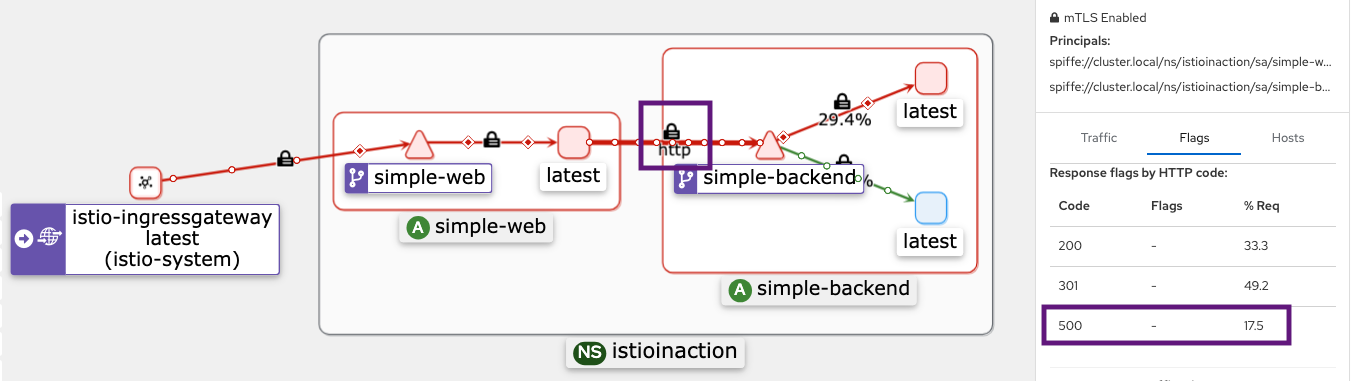

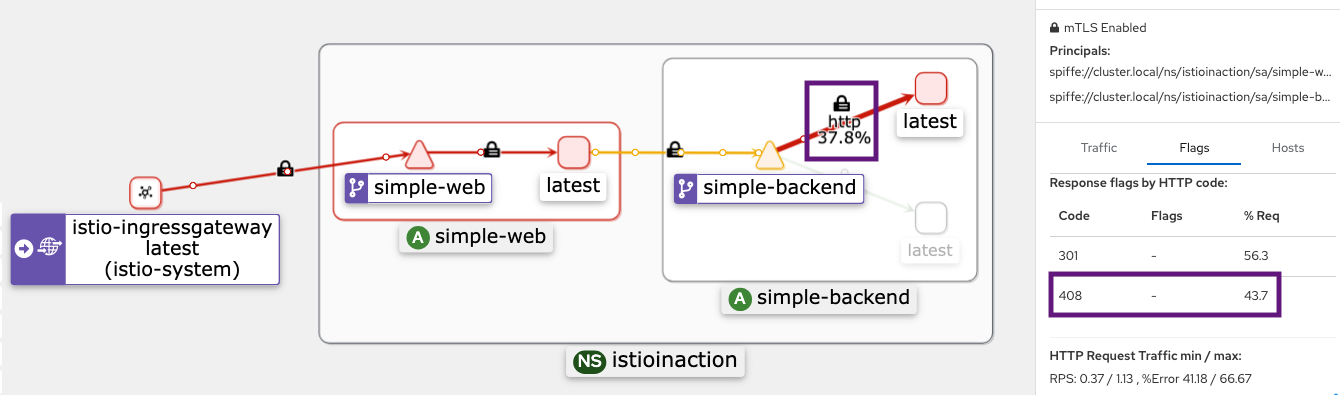

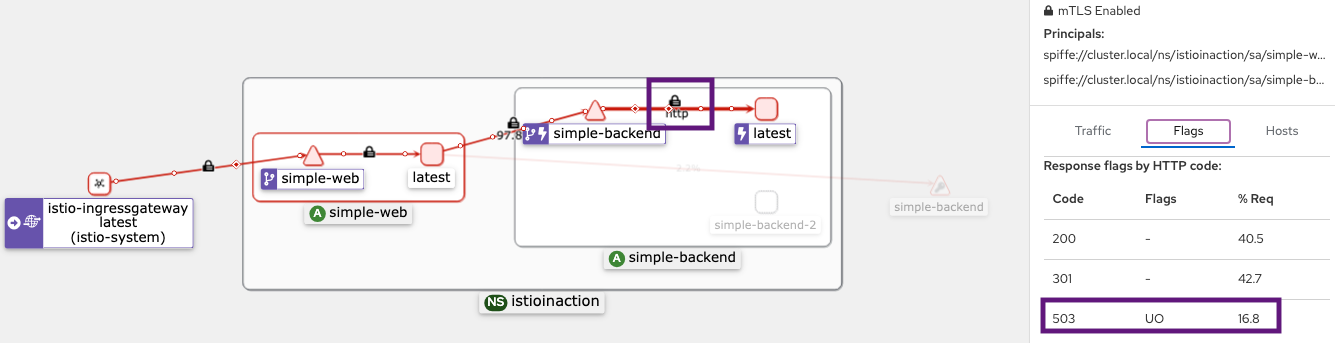

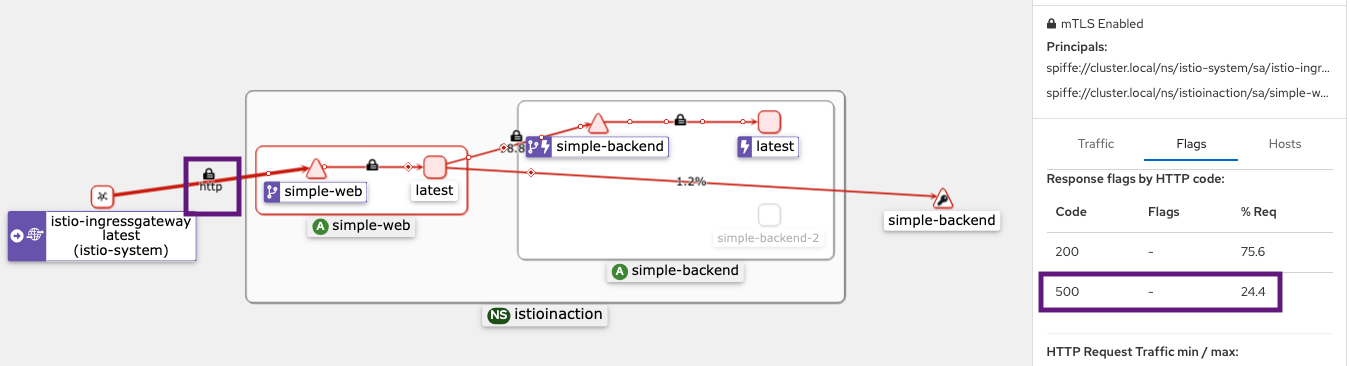

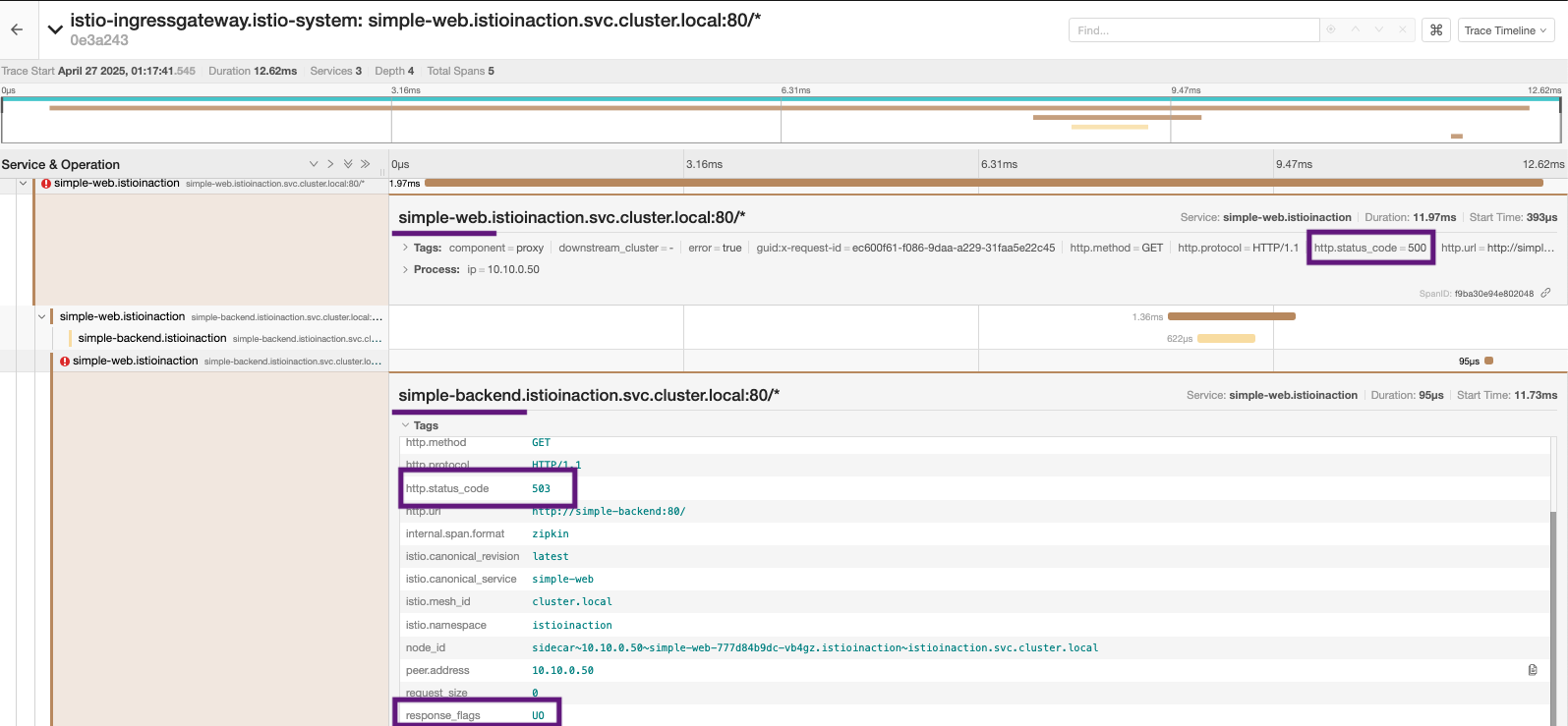

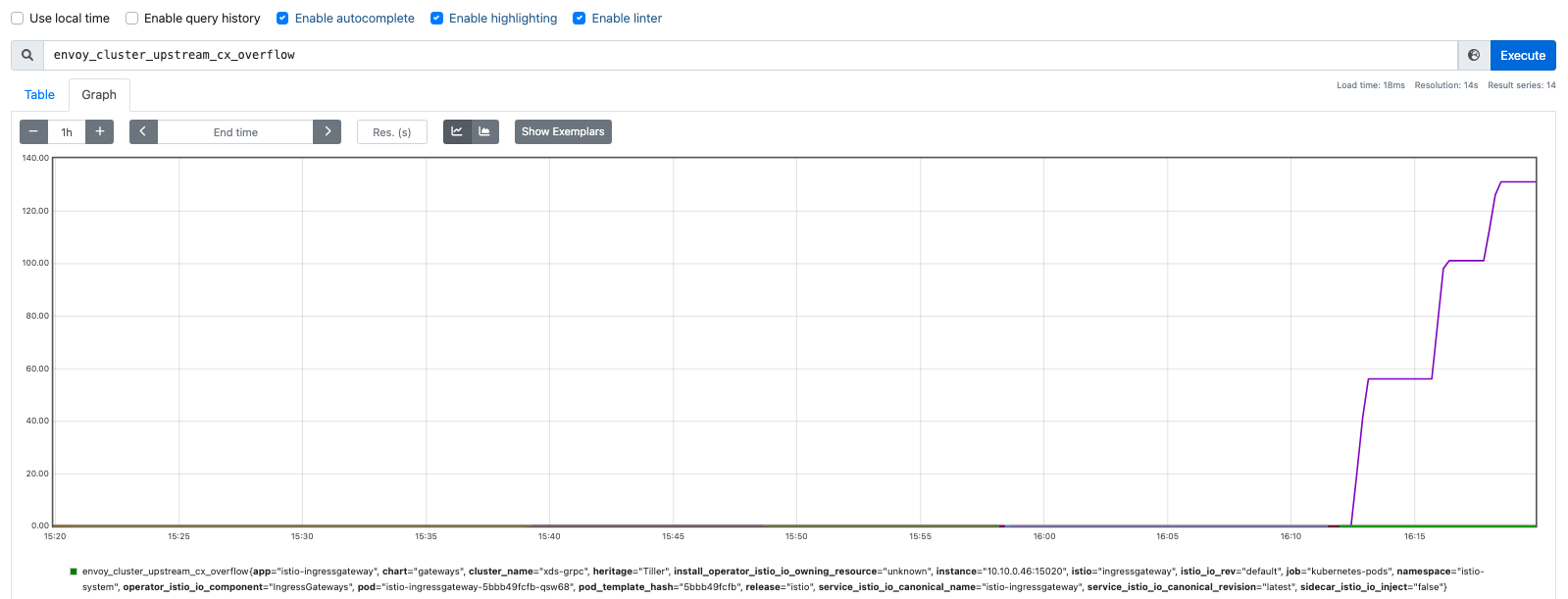

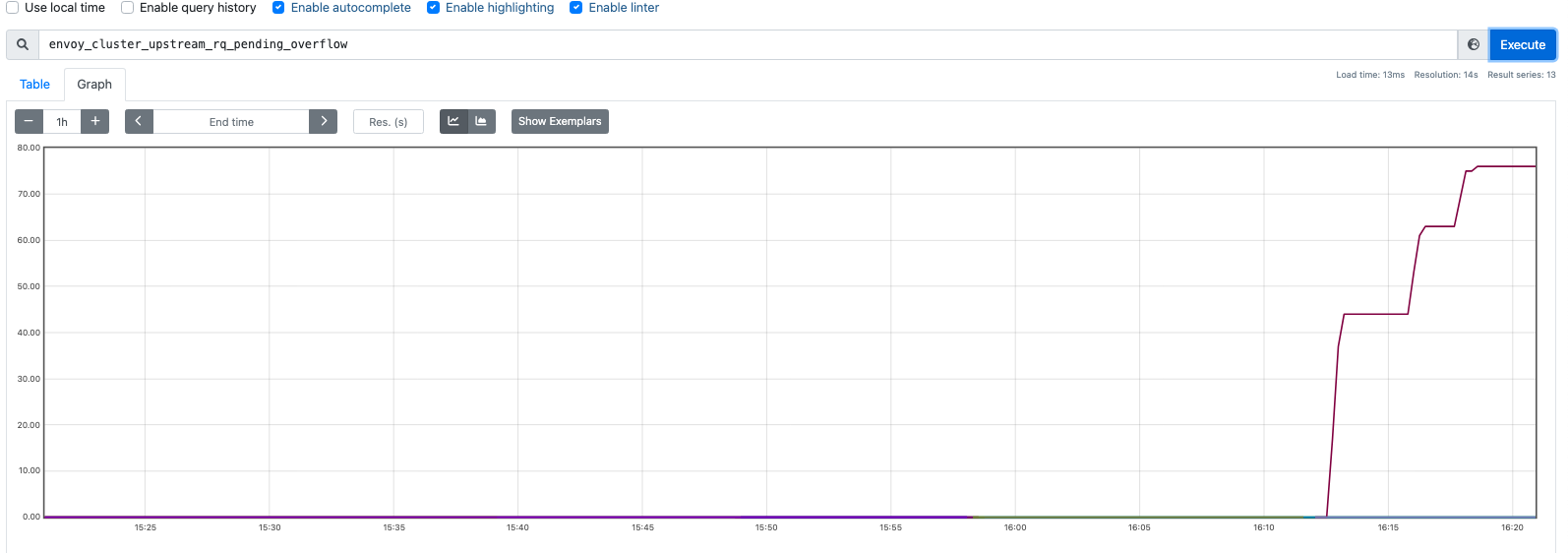

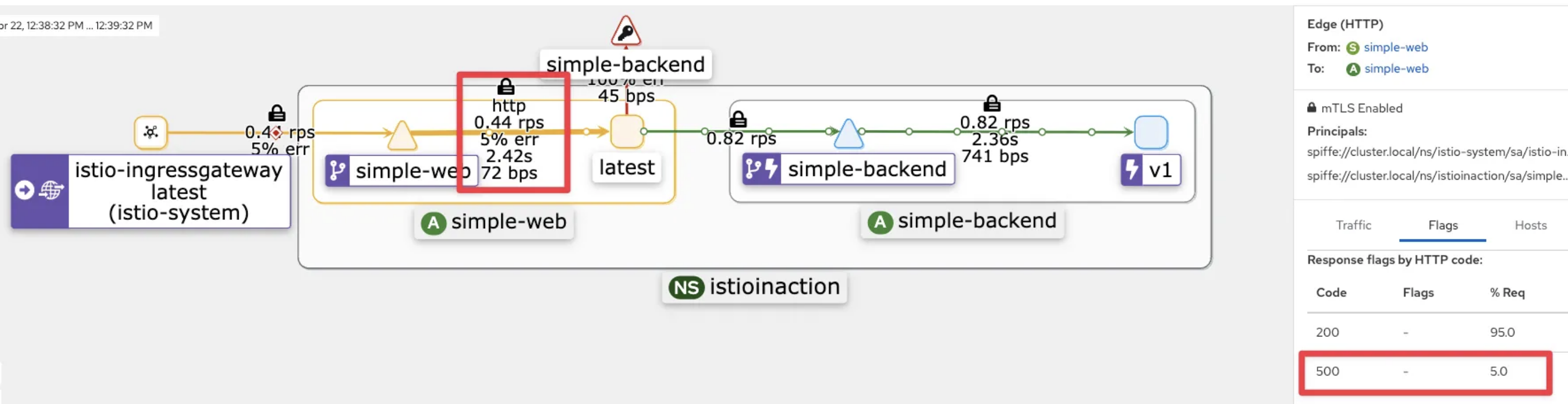

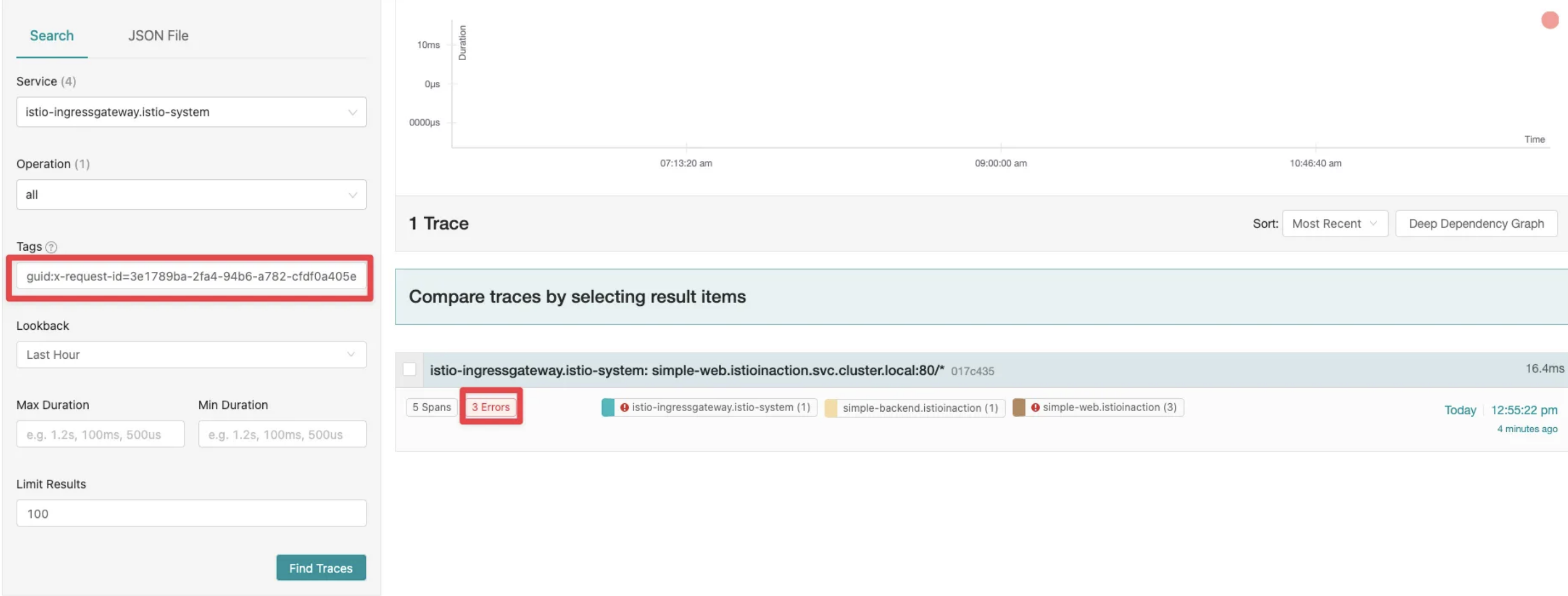

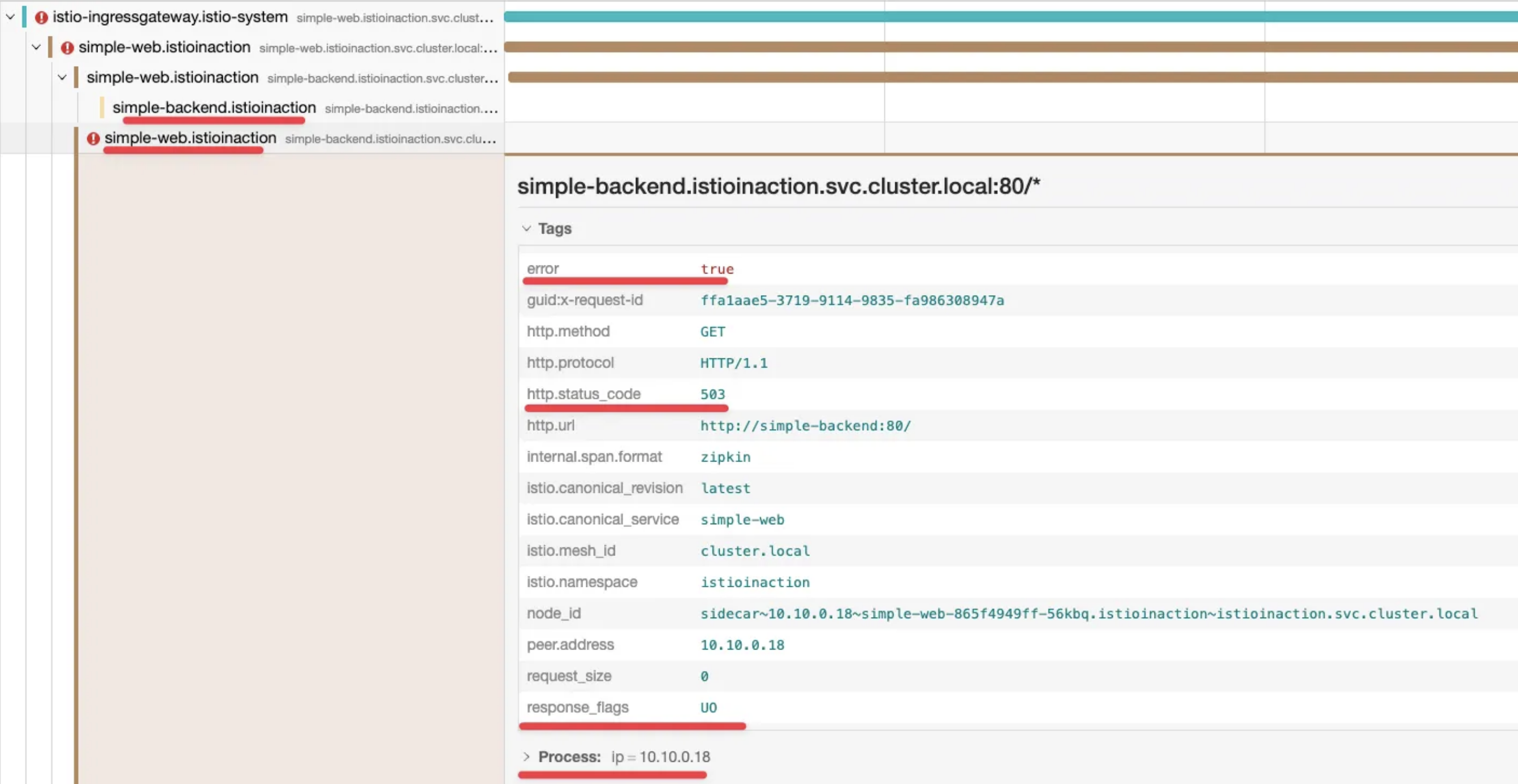

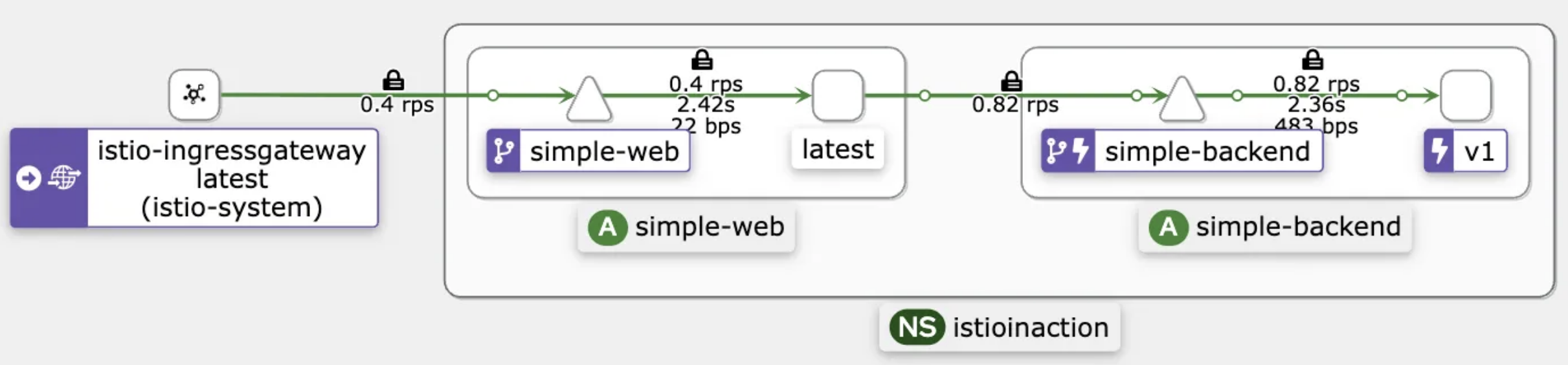

- Kiali

- Prometheus -

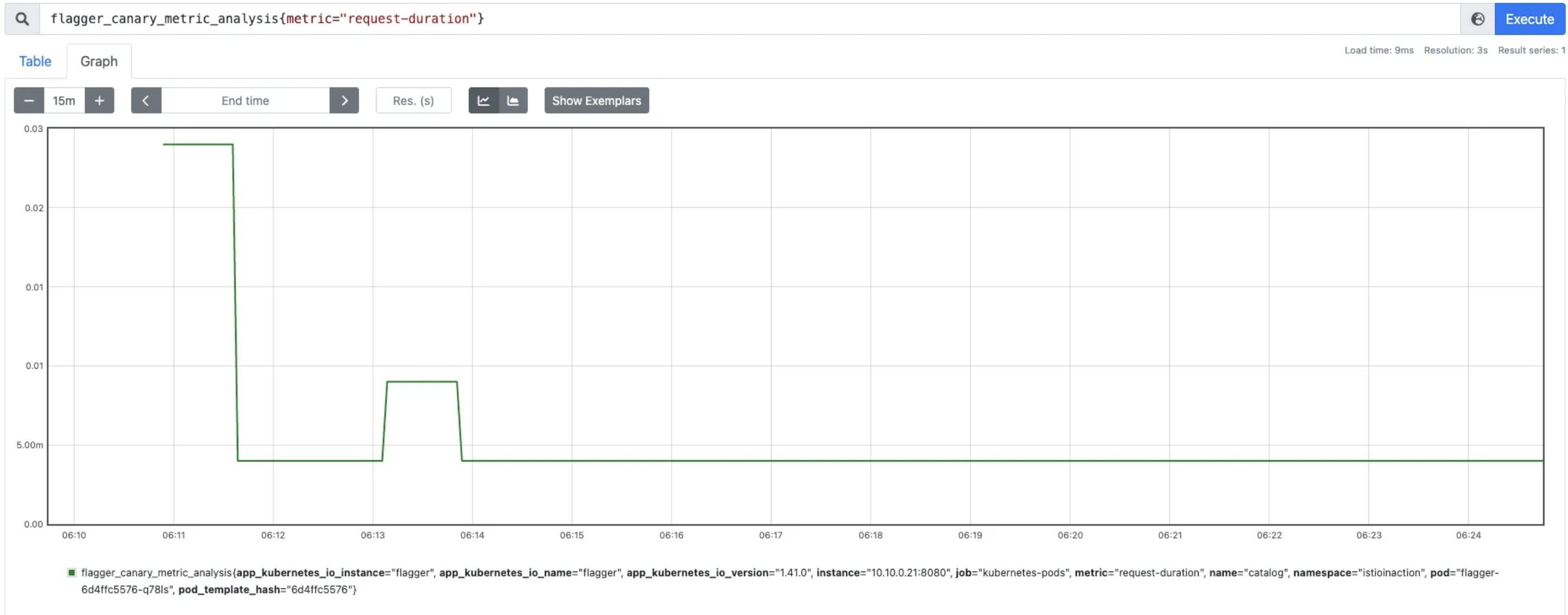

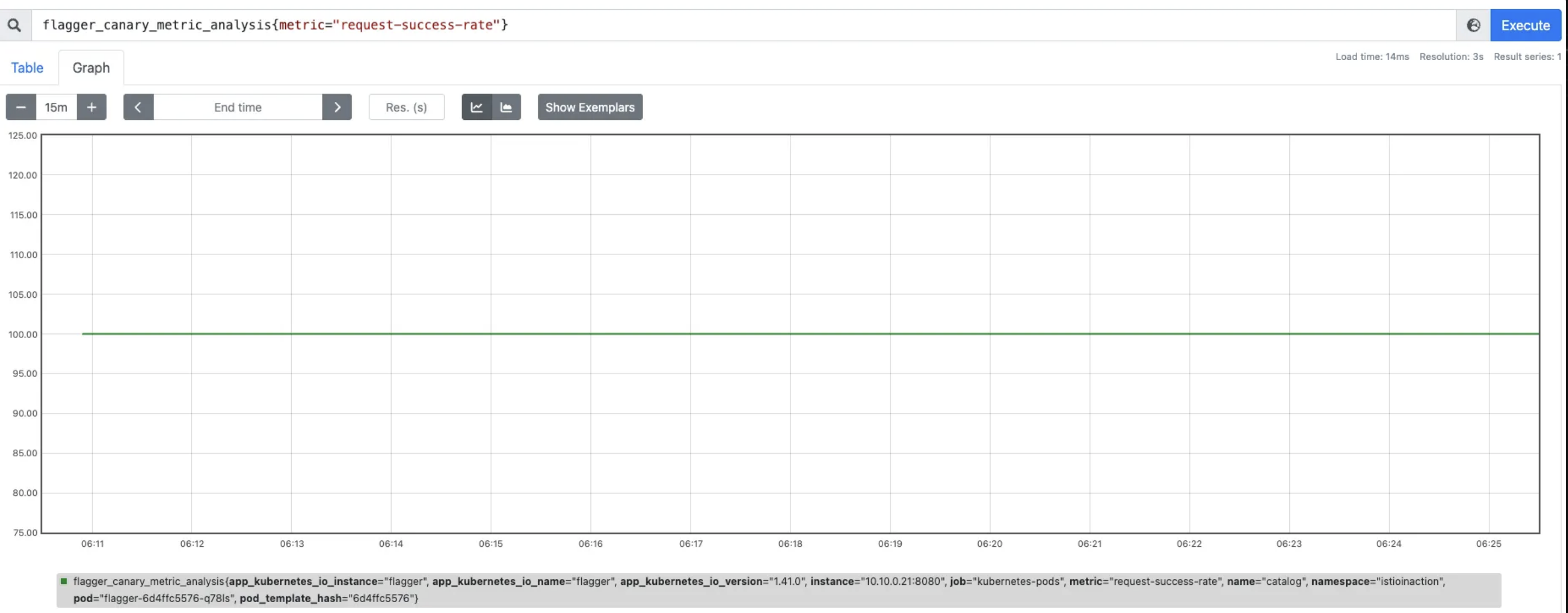

flagger_canary_weight

flagger_canary_metirc_analysis(metric="request-duration")

flagger_canary_metric_analysis(metric="request-seccess-rate")

(실습 중에 캡쳐를 못했습니다. ref: Istio Hands-on Study - 3주차 - Traffic control)

여기서는 Canary만 실습했지만, A/B Testing, Blue/Green 등도 지원한다.

# Canary 삭제 : Flagger가 만든 service (catalog, catalog-canary, catalog-primary), destinationrule (catalog-canary, catalog-primary), deployment (catalog-primary) 를 제거함

kubectl delete canary catalog-release -n istioinaction

# catalog 삭제

kubectl delete deploy catalog -n istioinaction

# Flagger 삭제

helm uninstall flagger -n istio-system

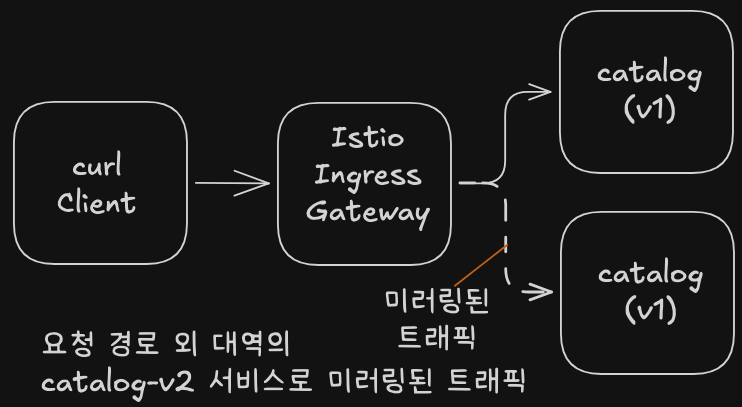

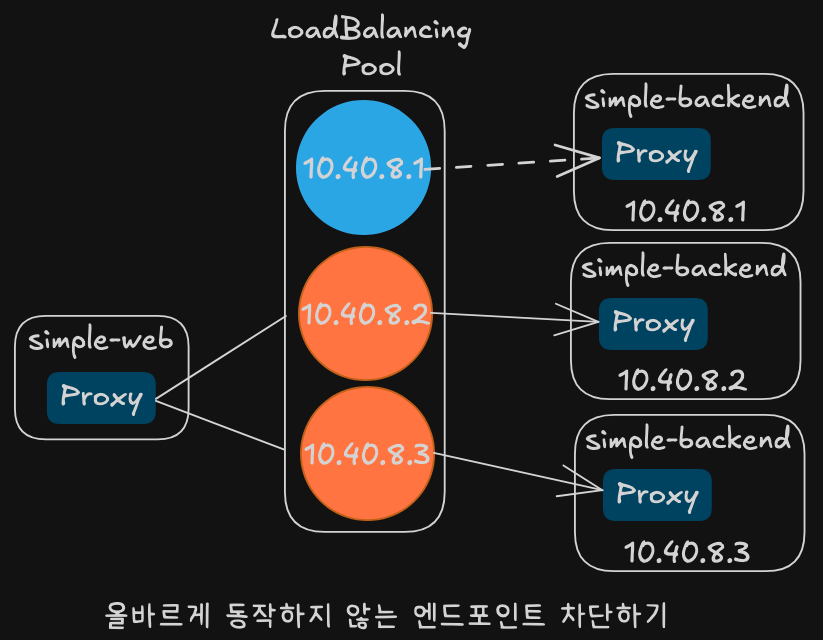

위험을 더욱 줄이기: 트래픽 미러링

운영 트래픽을 복제해 새 버전에 보내면서 사용자에게는 영향을 주지 않는다.

실습 환경 초기화

# catalog 디플로이먼트를 초기 상태로 돌리고, catalog-v2 를 별도의 디플로이먼트로 배포

kubectl apply -f services/catalog/kubernetes/catalog-svc.yaml -n istioinaction

kubectl apply -f services/catalog/kubernetes/catalog-deployment.yaml -n istioinaction

kubectl apply -f services/catalog/kubernetes/catalog-deployment-v2.yaml -n istioinaction

kubectl apply -f ch5/catalog-dest-rule.yaml -n istioinaction

kubectl apply -f ch5/catalog-vs-v1-mesh.yaml -n istioinaction

# 확인

kubectl get deploy -n istioinaction -o wide

kubectl get svc,ep -n istioinaction -owide

kubectl get gw,vs -n istioinaction

# 반복 접속

while true; do curl -s http://webapp.istioinaction.io:30000/api/catalog -I | head -n 1 ; date "+%Y-%m-%d %H:%M:%S" ; sleep 1; echo; done

# catalog v1 으로만 접속 확인

for i in {1..100}; do curl -s http://webapp.istioinaction.io:30000/api/catalog | grep -i imageUrl ; done | wc -l

0

트래픽 미러링 설정

# cat ch5/catalog-vs-v2-mirror.yaml

apiVersion: networking.istio.io/v1alpha3

kind: VirtualService

metadata:

name: catalog

spec:

hosts:

- catalog

gateways:

- mesh

http:

- route:

- destination:

host: catalog

subset: version-v1

weight: 100

mirror:

host: catalog

subset: version-v2

# 반복 접속

while true; do curl -s http://webapp.istioinaction.io:30000/api/catalog -I | head -n 1 ; date "+%Y-%m-%d %H:%M:%S" ; sleep 1; echo; don

# catalog istio-proxy 로그 활성화

cat << EOF | kubectl apply -f -

apiVersion: telemetry.istio.io/v1alpha1

kind: Telemetry

metadata:

name: catalog

namespace: istioinaction

spec:

accessLogging:

- disabled: false

providers:

- name: envoy

selector:

matchLabels:

app: catalog

EOF

kubectl get telemetries -n istioinaction

NAME AGE

catalog 7s

webapp 109m

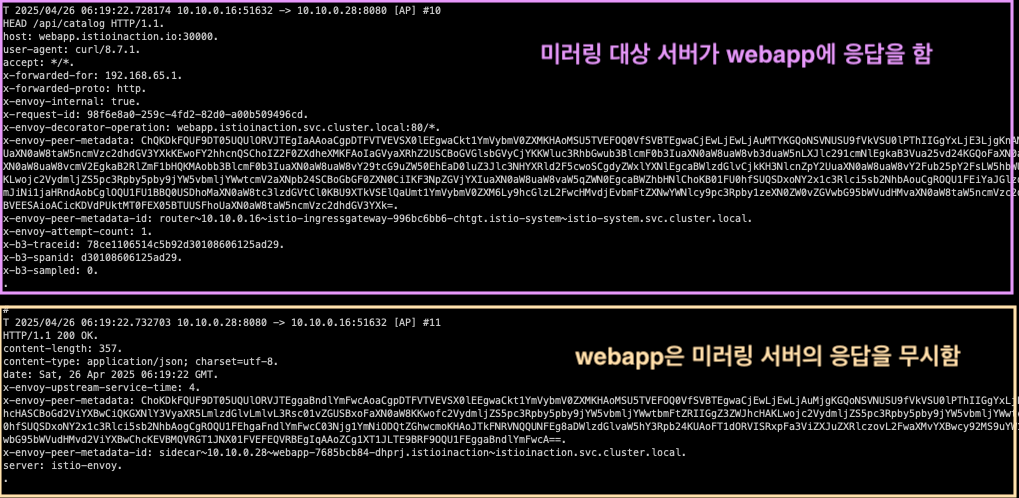

# istio-proxy 로그 확인 : 신규 터미널

kubectl logs -n istioinaction -l app=webapp -c istio-proxy -f

kubectl logs -n istioinaction -l app=catalog -c istio-proxy -f

kubectl logs -n istioinaction -l version=v1 -c istio-proxy -f

kubectl logs -n istioinaction -l app=catalog -l version=v2 -c istio-proxy -f

혹은

kubectl stern -n istioinaction -l app=catalog -c istio-proxy

# proxy-config : webapp

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/webapp.istioinaction | grep catalog

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/webapp.istioinaction | grep catalog

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/webapp.istioinaction | grep catalog

# proxy-config : catalog

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/catalog.istioinaction | grep catalog

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/catalog.istioinaction | grep catalog

docker exec -it myk8s-control-plane istioctl proxy-config endpoint deploy/catalog.istioinaction | grep catalog

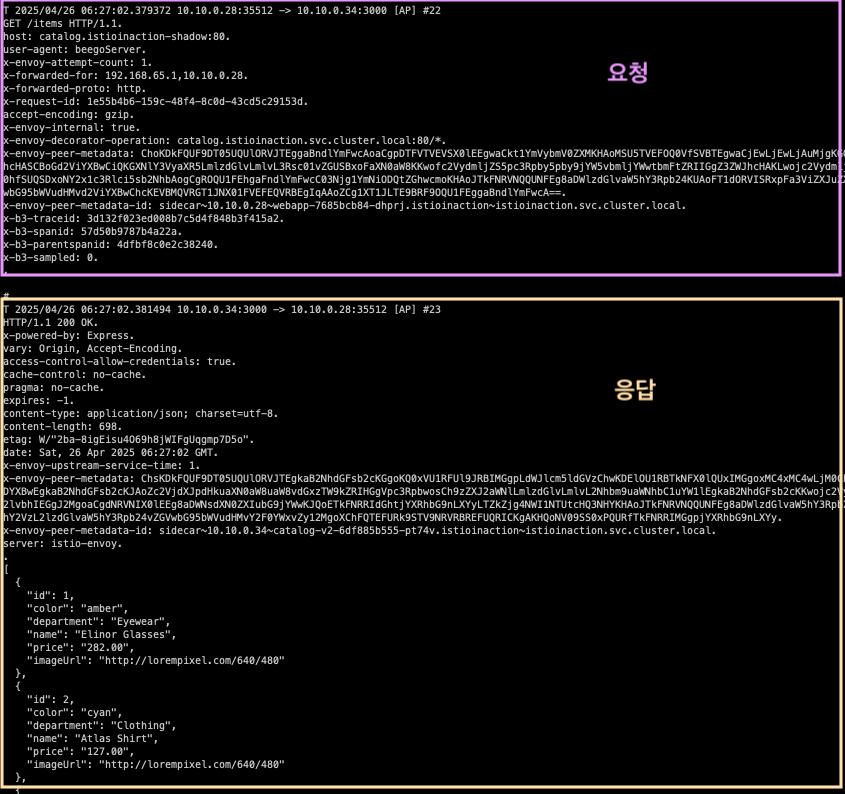

# 미러링 VS 설정

kubectl apply -f ch5/catalog-vs-v2-mirror.yaml -n istioinaction

# v1 으로만 호출 확인

for i in {1..100}; do curl -s http://webapp.istioinaction.io:30000/api/catalog | grep -i imageUrl ; done | wc -l

0

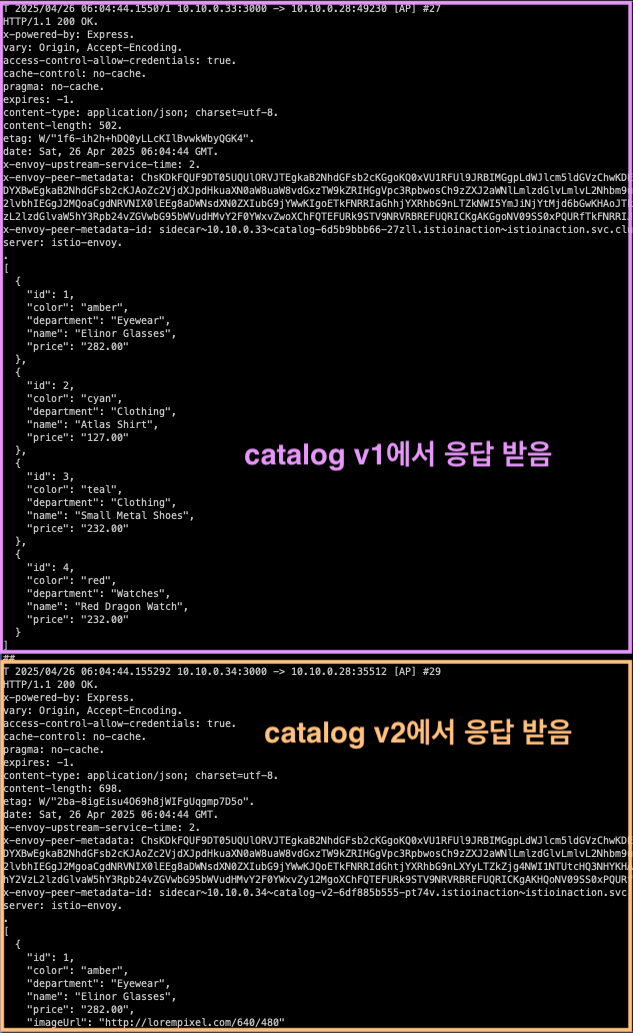

# v1 app 로그 확인

kubectl logs -n istioinaction -l app=catalog -l version=v1 -c catalog -f

request path: /items

blowups: {}

number of blowups: 0

GET catalog.istioinaction:80 /items 200 502 - 0.651 ms

GET /items 200 0.651 ms - 502

...

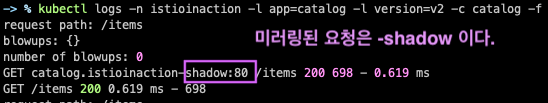

# v2 app 로그 확인 : 미러링된 트래픽이 catalog v2로 향할때, Host 헤더가 수정돼 미러링/섀도잉된 트래픽임을 나타낸다.

## 따라서 Host:catalog:8080 대신 Host:catalog-shadow:8080이 된다.

## -shadow 접미사가 붙은 요청을 받는 서비스는 그 요청이 미러링된 요청임을 식별할 수 있어, 요청을 처리할 때 고려할 수 있다

## 예를 들어, 응답이 버려질 테니 트랜잭션을 롤백하지 않거나 리소스를 많이 사용하는 호출을 하지 않는 것 등.

kubectl logs -n istioinaction -l app=catalog -l version=v2 -c catalog -f

request path: /items

blowups: {}

number of blowups: 0

GET catalog.istioinaction-shadow:80 /items 200 698 - 0.619 ms

GET /items 200 0.619 ms - 698

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/webapp.istioinaction --name 80 -o json > webapp-routes.json

cat webapp-routes.json

...

"route": {

"cluster": "outbound|80|version-v1|catalog.istioinaction.svc.cluster.local",

"timeout": "0s",

"retryPolicy": {

"retryOn": "connect-failure,refused-stream,unavailable,cancelled,retriable-status-codes",

"numRetries": 2,

"retryHostPredicate": [

{

"name": "envoy.retry_host_predicates.previous_hosts",

"typedConfig": {

"@type": "type.googleapis.com/envoy.extensions.retry.host.previous_hosts.v3.PreviousHostsPredicate"

}

}

],

"hostSelectionRetryMaxAttempts": "5",

"retriableStatusCodes": [

503

]

},

"requestMirrorPolicies": [

{

"cluster": "outbound|80|version-v2|catalog.istioinaction.svc.cluster.local",

"runtimeFraction": {

"defaultValue": {

"numerator": 100

}

},

"traceSampled": false

...

# 위 webapp과 상동 : mesh(gateway)이니까...

docker exec -it myk8s-control-plane istioctl proxy-config routes deploy/catalog.istioinaction --name 80 -o json > catalog-routes.json

cat catalog-routes.json

...

# Istio 메시 내부망에서 모든 mTLS 통신 기능 끄기 설정 : (참고) 특정 네임스페이스 등 세부 조절 설정 가능

cat <<EOF | kubectl apply -f -

apiVersion: security.istio.io/v1beta1

kind: PeerAuthentication

metadata:

name: default

namespace: istio-system

spec:

mtls:

mode: DISABLE

EOF

kubectl get PeerAuthentication -n istio-system

NAME MODE AGE

default DISABLE 6h13m

--------------------------------------------------------------------------------

# catalog v2 파드의 vnic 와 vritual-pair 인 control-plane 노드(?)의 veth 이름 찾기

## catalog v2 파드 IP 확인

C2IP=$(kubectl get pod -n istioinaction -l app=catalog -l version=v2 -o jsonpath='{.items[*].status.podIP}')

echo $C2IP

10.10.0.34

## veth 이름 확인

docker exec -it myk8s-control-plane ip -c route | grep $C2IP | awk '{ print $3 }'

C2VETH=$(docker exec -it myk8s-control-plane ip -c route | grep $C2IP | awk '{ print $3 }')

echo $C2VETH

vethb8c60b86

--------------------------------------------------------------------------------

# ngrep 확인 : catalog v2 파드 tcp 3000

docker exec -it myk8s-control-plane sh -c "ngrep -tW byline -d vethb8c60b86 '' 'tcp port 3000'"

- 미러링 대상 서버는 응답은 안하는게 좋지만, 응답을 webapp 파드에 한다고 해도, webapp은 이 응답을 무시한다.

--------------------------------------------------------------------------------

# webapp 파드의 vnic 와 vritual-pair 인 control-plane 노드(?)의 veth 이름 찾기

## webapp 파드 IP 확인

WEBIP=$(kubectl get pod -n istioinaction -l app=webapp -o jsonpath='{.items[*].status.podIP}')

echo $WEBIP

10.10.0.28

## veth 이름 확인

docker exec -it myk8s-control-plane ip -c route | grep $WEBIP | awk '{ print $3 }'

WEBVETH=$(docker exec -it myk8s-control-plane ip -c route | grep $WEBIP | awk '{ print $3 }')

echo $WEBVETH

veth38e54d37

--------------------------------------------------------------------------------

# ngrep 확인 : webapp 파드 tcp 8080

## => 아래 tcp 3000에서 미러링 응답이 있지만 8080에 없다는건, webapp istio-proxy 가 최초 외부 요청자에게는 전달하지 않고 무시(drop?).

docker exec -it myk8s-control-plane sh -c "ngrep -tW byline -d veth38e54d37 '' 'tcp port 8080'"

# ngrep 확인 : webapp 파드 tcp 3000

docker exec -it myk8s-control-plane sh -c "ngrep -tW byline -d veth38e54d37 '' 'tcp port 3000'"

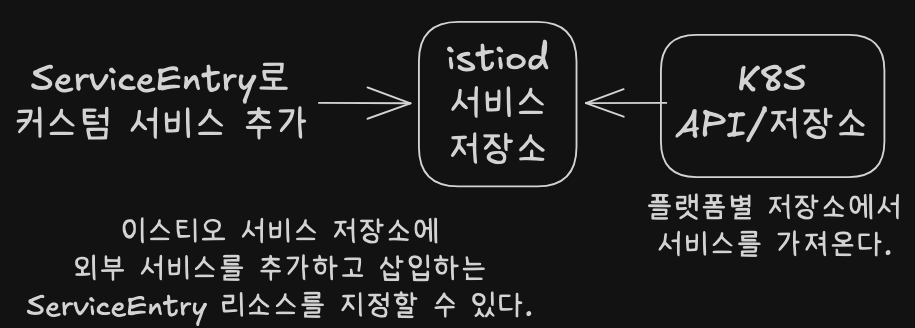

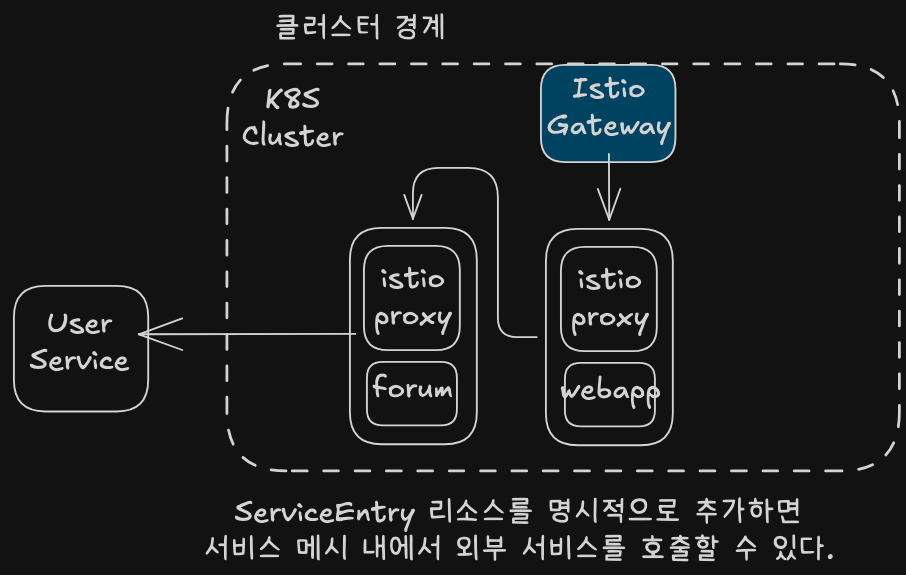

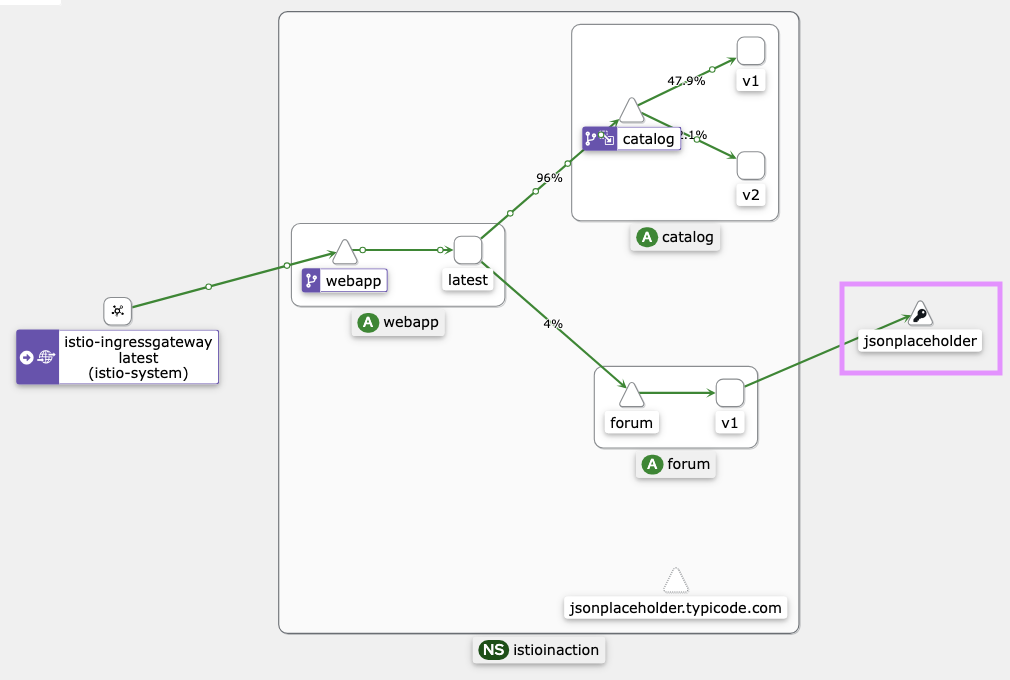

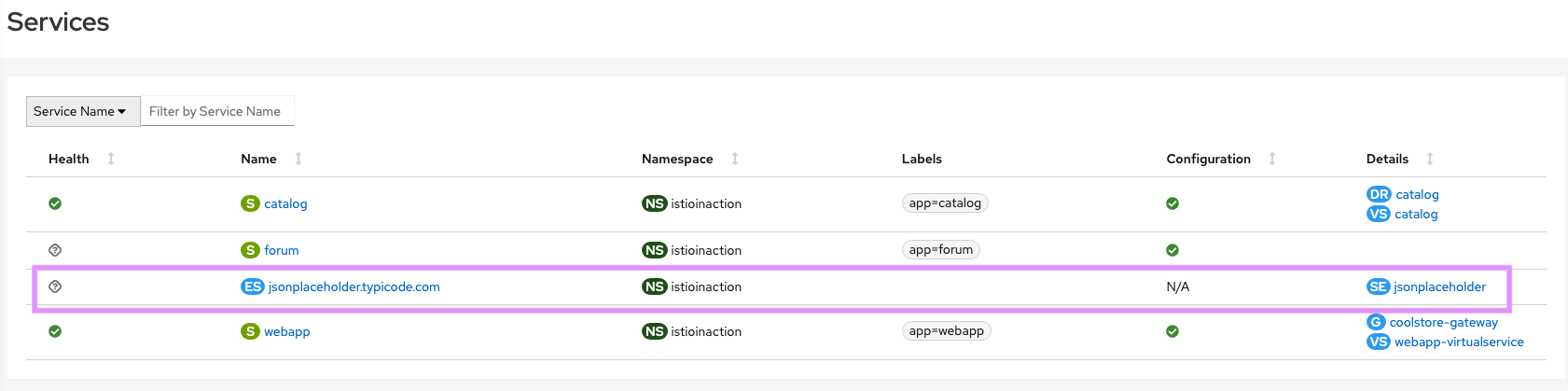

클러스터 외부 서비스와 통신하기

Istio는 기본적으로 모든 아웃바운드 트래픽을 허용하지만, outboundTrafficPolicy를 REGISTRY_ONLY로 설정해 차단할 수 있다.

ServiceEntry를 사용해 필요한 외부 도메인만 허용한다.

실습 준비

# 현재 istiooperators meshConfig 설정 확인

kubectl get istiooperators -n istio-system -o json

...

"meshConfig": {

"defaultConfig": {

"proxyMetadata": {}

},

"enablePrometheusMerge": true

},

...

# webapp 파드에서 외부 다운로드

kubectl exec -it deploy/webapp -n istioinaction -c webapp -- wget https://raw.githubusercontent.com/gasida/KANS/refs/heads/main/msa/sock-shop-demo.yaml

# webapp 로그 : 신규 터미널

kubectl logs -n istioinaction -l app=webapp -c istio-proxy -f

[2025-04-26T06:32:06.582Z] "HEAD /api/catalog HTTP/1.1" 200 - via_upstream - "-" 0 0 4 4 "192.168.65.1" "curl/8.7.1" "31ec608e-0205-412f-aae8-b32f257672e4" "webapp.istioinaction.io:30000" "10.10.0.28:8080" inbound|8080|| 127.0.0.6:35431 10.10.0.28:8080 192.168.65.1:0 - default

# 다음 명령을 실행해 이스티오의 기본값을 ALLOW_ANY 에서 REGISTRY_ONLY 로 바꾸자.

# 이느 서비스 메시 저장소에 명시적으로 허용된 경우(화이트 리스트)에만 트래픽이 메시를 떠나도록 허용하겠다는 의미다.

# 아래 설정 방법 이외에도 IstioOperator 로 설정을 변경하거나, istio-system 의 istio configmap 을 변경해도 됨.

# outboundTrafficPolicy 3가지 모드 : ALLOW_ANY (default) , REGISTRY_ONLY , ALLOW_LIST

docker exec -it myk8s-control-plane bash

----------------------------------------

istioctl install --set profile=default --set meshConfig.outboundTrafficPolicy.mode=REGISTRY_ONLY

y

exit

----------------------------------------

# 배포 확인

docker exec -it myk8s-control-plane istioctl proxy-status

NAME CLUSTER CDS LDS EDS RDS ECDS ISTIOD VERSION

catalog-6d5b9bbb66-vzg4j.istioinaction Kubernetes SYNCED SYNCED SYNCED SYNCED NOT SENT istiod-8d74787f-6w77x 1.17.8

catalog-v2-6df885b555-n9nxw.istioinaction Kubernetes SYNCED SYNCED SYNCED SYNCED NOT SENT istiod-8d74787f-6w77x 1.17.8

istio-ingressgateway-6bb8fb6549-s4pt8.istio-system Kubernetes SYNCED SYNCED SYNCED SYNCED NOT SENT istiod-8d74787f-6w77x 1.17.8

webapp-7685bcb84-skzgg.istioinaction Kubernetes SYNCED SYNCED SYNCED SYNCED NOT SENT istiod-8d74787f-6w77x 1.17.8

# webapp 파드에서 외부 다운로드

kubectl exec -it deploy/webapp -n istioinaction -c webapp -- wget https://raw.githubusercontent.com/gasida/KANS/refs/heads/main/msa/sock-shop-demo.yaml

Connecting to raw.githubusercontent.com (185.199.109.133:443)

wget: error getting response: Connection reset by peer

command terminated with exit code 1

# webapp 로그 : BlackHoleCluster 차단

# UH : NoHealthyUpstream - No healthy upstream hosts in upstream cluster in addition to 503 response code.

# https://www.envoyproxy.io/docs/envoy/latest/configuration/observability/access_log/usage

kubectl logs -n istioinaction -l app=webapp -c istio-proxy -f

[2025-04-19T09:55:34.851Z] "- - -" 0 UH - - "-" 0 0 0 - "-" "-" "-" "-" "-" BlackHoleCluster - 185.199.109.133:443 10.10.0.19:34868 - -

# proxy-config : webapp

docker exec -it myk8s-control-plane istioctl proxy-config cluster deploy/webapp.istioinaction --fqdn BlackHoleCluster -o json

[

{

"name": "BlackHoleCluster",

"type": "STATIC",

"connectTimeout": "10s"

}

]

# 현재 istiooperators meshConfig 설정 확인

kubectl get istiooperators -n istio-system -o json

...

"meshConfig": {

"defaultConfig": {

"proxyMetadata": {}

},